协程

进程时代

最初的计算机上面没有操作系统,更别提进程、线程和协程了。

后来,现代化的计算机有了操作系统,每个程序都是一个进程,但是操作系统在一段时间只能运行一个进程,直到这个进程运行完,才能运行下一个进程,这个时期可以成为单进程时代——串行时代。

后来操作系统就具有了最早的并发能力:多进程并发,当一个进程阻塞的时候,切换到另外等待执行的进程,这样就能尽量把CPU利用起来,CPU就不浪费了。

线程时代

有了对进程的调度能力之后,发现进程拥有太多资源,在创建、切换和销毁的时候,都会占用很长的时间,CPU虽然利用起来了,但CPU有很大的一部分都被用来进行进程调度了,怎么才能提高CPU的利用率呢?

大家希望能有一种轻量级的进程,调度不怎么花时间,这样CPU就有更多的时间 用在执行任务上。

后来,操作系统支持了线程,线程在进程里面,线程运行所需要资源比进程少多了,跟进程比起来,切换简直是“不算事”。

一个进程可以有多个线程,CPU在执行调度的时候切换的是线程,如果下一个线程也是当前进程的,就只有线程切换,“很快”就能完成,如果下一个线程不是当前的进程,就需要切换进程,这就得费点时间了。

传统的编程语言比如C、C++等的并发实现实际上就是基于操作系统调度的,即程序负责创建线程(一般通过pthread等lib调用实现),操作系统负责调度。这种传统支持并发的方式有诸多不足:

复杂:

- 创建容易,退出难:做过C/C++ Programming的童鞋都知道,创建一个thread(比如利用pthread)虽然参数也不少,但好歹可以接受。但一旦涉及到thread的退出,就要考虑thread是detached,还是需要parent thread去join?是否需要在thread中设置cancel point,以保证join时能顺利退出?

- 并发单元间通信困难,易错:多个thread之间的通信虽然有多种机制可选,但用起来是相当复杂;并且一旦涉及到shared memory,就会用到各种lock,死锁便成为家常便饭;

- thread stack size的设定:是使用默认的,还是设置的大一些,或者小一些呢?

难于scaling:

- 一个thread的代价已经比进程小了很多了,但我们依然不能大量创建thread,因为除了每个thread占用的资源不小之外,操作系统调度切换thread的代价也不小;

- 对于很多网络服务程序,由于不能大量创建thread,就要在少量thread里做网络多路复用,即:使用epoll/kqueue/IoCompletionPort这套机制,即便有libevent/libev这样的第三方库帮忙,写起这样的程序也是很不易的,存在大量callback,给程序员带来不小的心智负担。

协程时代

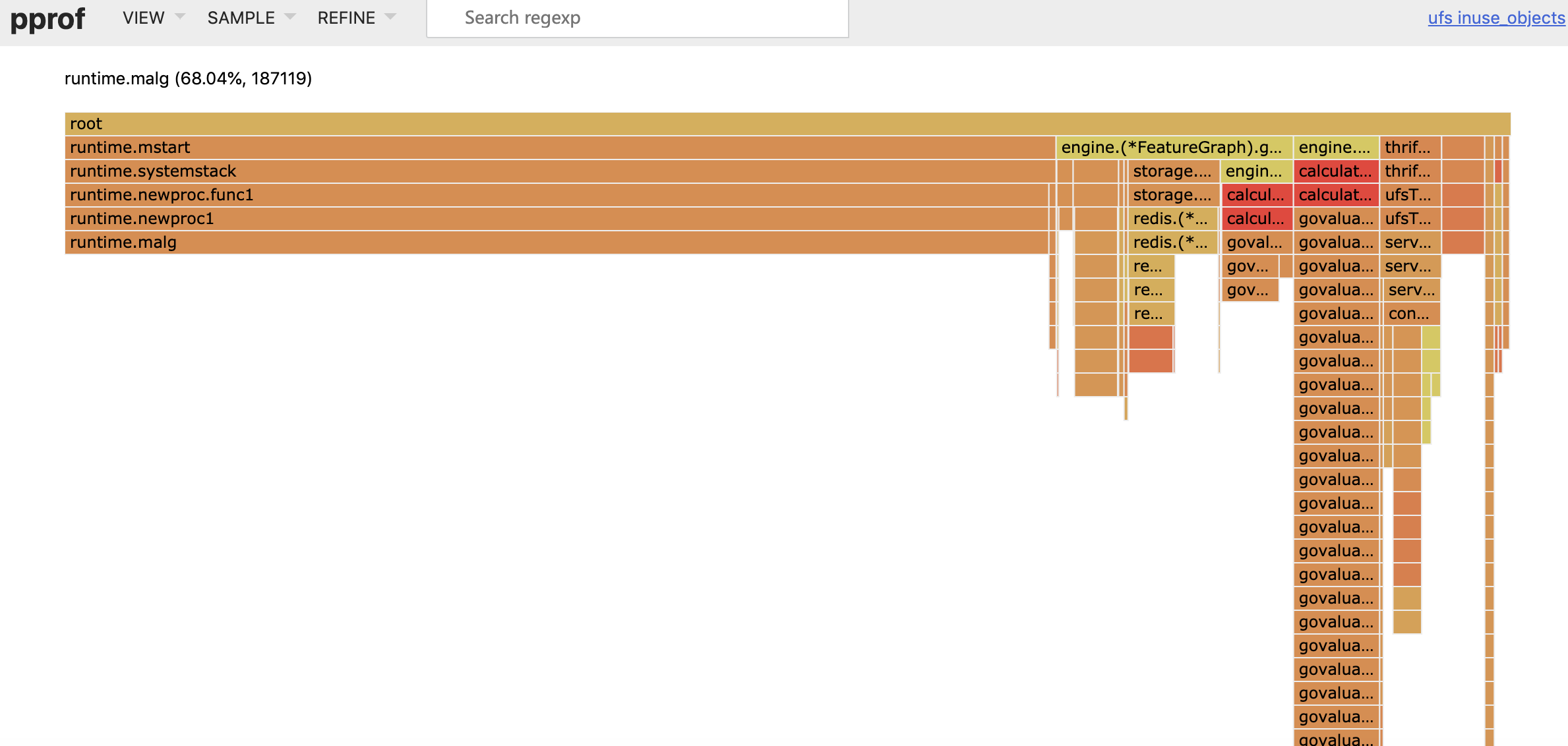

多进程、多线程已经提高了系统的并发能力,但是在当今互联网高并发场景下,为每个任务都创建一个线程是不现实的,因为会消耗大量的内存(每个线程的内存占用级别为MB),线程多了之后调度也会消耗大量的CPU。如何才能充分利用CPU、内存等资源的情况下,实现更高的并发?

既然线程的资源占用、调度在高并发的情况下,依然是比较大的,是否有一种东西,更加轻量?

你可能知道:线程分为内核态线程和用户态线程,用户态线程需要绑定内核态线程,CPU并不能感知用户态线程的存在,它只知道它在运行1个线程,这个线程实际是内核态线程。

用户态线程实际有个名字叫协程(co-routine),为了容易区分,我们使用协程指用户态线程,使用线程指内核态线程。

User-level threads, Application-level threads, Green threads都指一样的东西,就是不受OS感知的线程,如果你Google coroutine相关的资料,会看到它指的就是用户态线程,在Green threads的维基百科里,看Green threads的实现列表,你会看到好很多coroutine实现,比如Java、Lua、Go、Erlang、Common Lisp、Haskell、Rust、PHP、Stackless Python,所以,我认为用户态线程就是协程。

协程跟线程是有区别的,线程由CPU调度是抢占式的,协程由用户态调度是协作式的,一个协程让出CPU后,才执行下一个协程。

协程和线程有3种映射关系:

N:1模型:N个协程在1个内核空间线程上运行。优势是上下文切换非常快但是无法利用多核系统的优点。

1:1模型:1个线程运行一个协程。这种充分利用了多核系统的优势但是上下文切换非常慢,因为每一次调度都会在用户态和内核态之间切换。(POSIX线程模型(pthread),Java)

M:N模型:每个协程对应多个线程,同时也可以一个线程对应多个协程。Go打算采用这种模型,使用任意个内核模型管理任意个goroutine。这样结合了以上两种模型的优点,但缺点就是调度的复杂性。

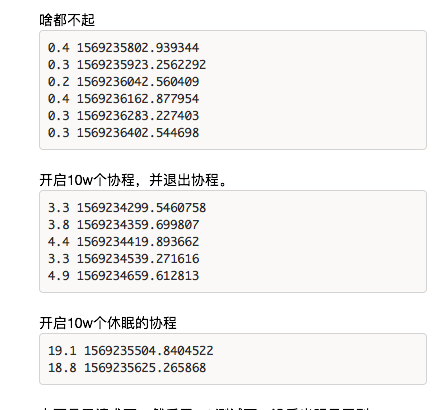

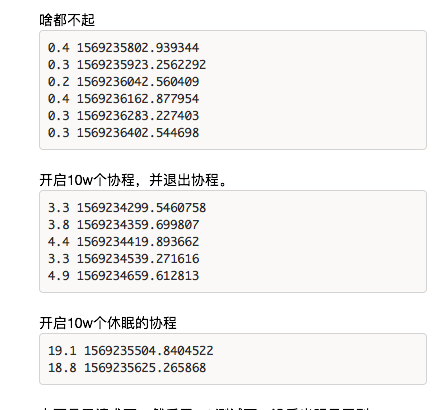

Goroutine

Go采用了用户层轻量级thread或者说是类coroutine的概念来解决这些问题,Go将之称为”goroutine“。goroutine占用的资源非常小(Go 1.4将每个goroutine stack的size默认设置为2k),goroutine调度的切换也不用陷入(trap)操作系统内核层完成,代价很低。因此,一个Go程序中可以创建成千上万个并发的goroutine。所有的Go代码都在goroutine中执行,哪怕是go的runtime也不例外。将这些goroutines按照一定算法放到“CPU”上执行的程序就称为goroutine调度器或goroutine scheduler。

不过,一个Go程序对于操作系统来说只是一个用户层程序,对于操作系统而言,它的眼中只有thread,它甚至不知道有什么叫Goroutine的东西的存在。goroutine的调度全要靠Go自己完成,实现Go程序内goroutine之间“公平”的竞争“CPU”资源,这个任务就落到了Go runtime头上,要知道在一个Go程序中,除了用户代码,剩下的就是go runtime了。

于是Goroutine的调度问题就演变为go runtime如何将程序内的众多goroutine按照一定算法调度到“CPU”资源上运行了。在操作系统层面,Thread竞争的“CPU”资源是真实的物理CPU,但在Go程序层面,各个Goroutine要竞争的”CPU”资源是什么呢?Go程序是用户层程序,它本身整体是运行在一个或多个操作系统线程上的,因此goroutine们要竞争的所谓“CPU”资源就是操作系统线程。这样Go scheduler的任务就明确了:将goroutines按照一定算法放到不同的操作系统线程中去执行。这种在语言层面自带调度器的,我们称之为原生支持并发。

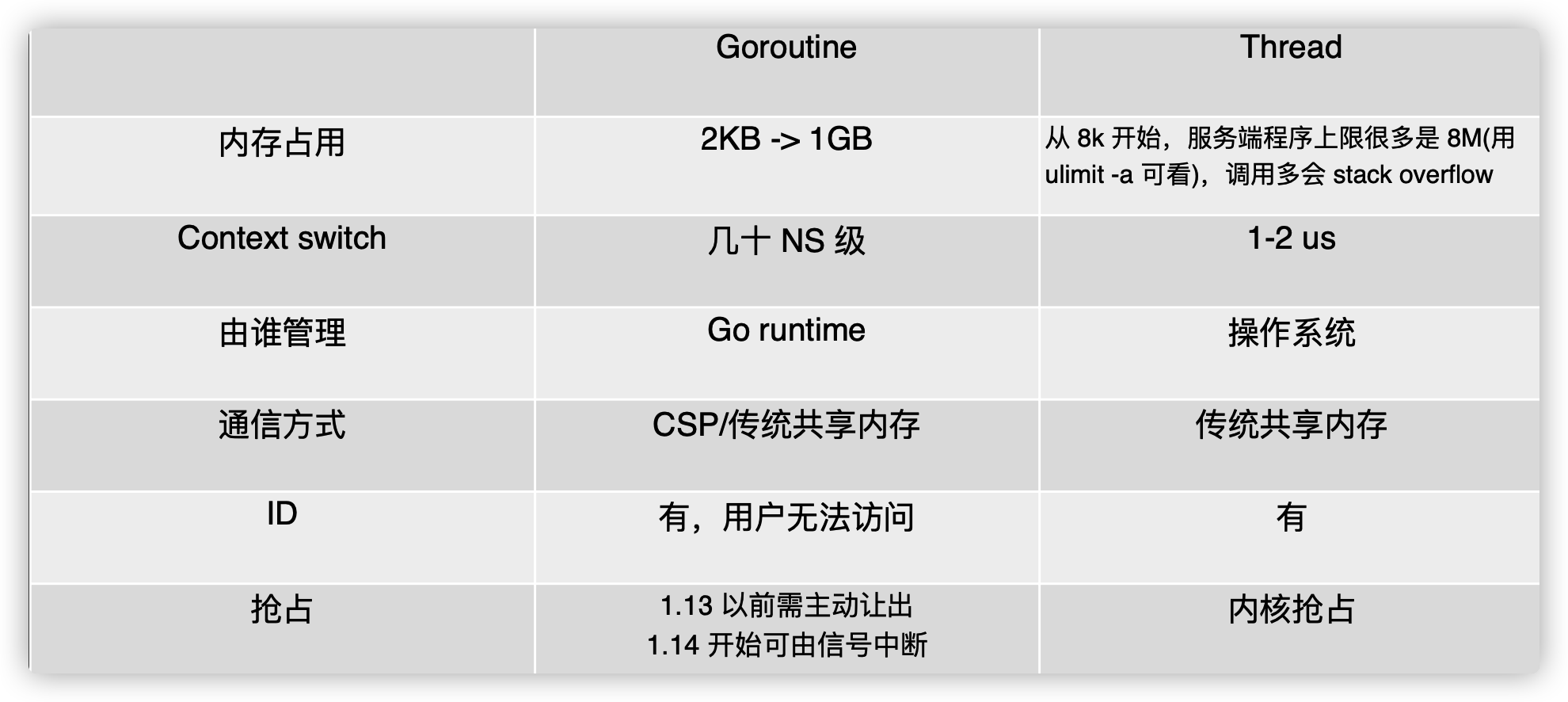

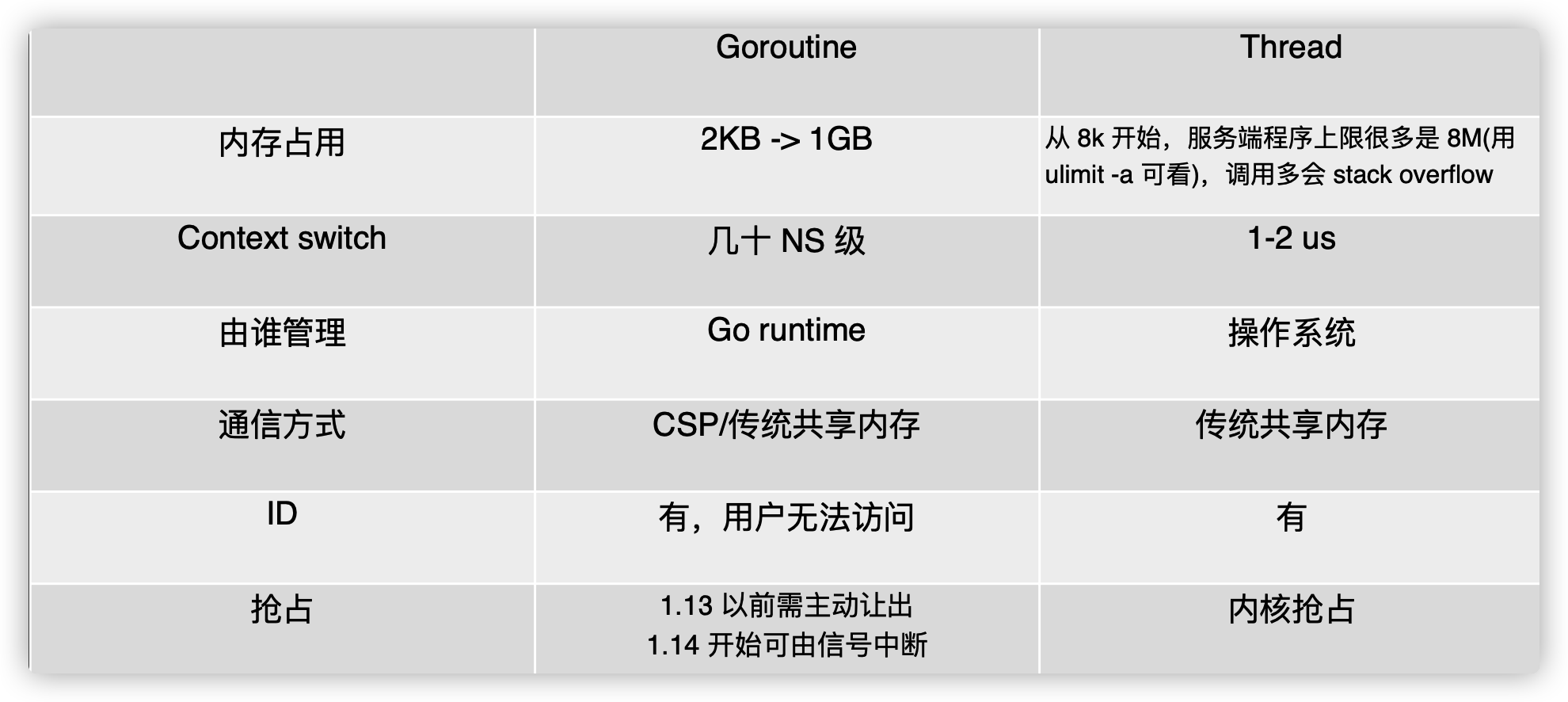

goroutine和线程的区别

我们可以从三个角度区别:内存消耗、创建与销毀、切换。

内存占用

创建一个 goroutine 的栈内存消耗为 2 KB,实际运行过程中,如果栈空间不够用,会自动进行扩容。创建一个 thread 则需要消耗 1 MB 栈内存,而且还需要一个被称为 “a guard page” 的区域用于和其他 thread 的栈空间进行隔离。

对于一个用 Go 构建的 HTTP Server 而言,对到来的每个请求,创建一个 goroutine 用来处理是非常轻松的一件事。而如果用一个使用线程作为并发原语的语言构建的服务,例如 Java 来说,每个请求对应一个线程则太浪费资源了,很快就会出 OOM 错误(OutOfMermoryError)。

创建和销毀

Thread 创建和销毀都会有巨大的消耗,因为要和操作系统打交道,是内核级的,通常解决的办法就是线程池。而 goroutine 因为是由 Go runtime 负责管理的,创建和销毁的消耗非常小,是用户级。

切换

当 threads 切换时,需要保存各种寄存器,以便将来恢复:

16 general purpose registers, PC (Program Counter), SP (Stack Pointer), segment registers, 16 XMM registers, FP coprocessor state, 16 AVX registers, all MSRs etc.

而 goroutines 切换只需保存三个寄存器:Program Counter, Stack Pointer and BP。

gobuf 描述一个 goroutine 所有现场,从一个 g 切换到另一个 g,只要把这几个现场字段保存下来 再把 g 往队列里一扔,m 就可以执行其它 g 了 无需进入内核态

1

2

3

4

5

6

7

8

9

10

11

12

13

|

type gobuf struct {

// 存储 rsp 寄存器的值

sp uintptr

// 存储 rip 寄存器的值

pc uintptr

// 指向 goroutine

g guintptr

ctxt unsafe.Pointer // this has to be a pointer so that gc scans it

// 保存系统调用的返回值

ret sys.Uintreg

lr uintptr

bp uintptr // for GOEXPERIMENT=framepointer

}

|

- sp — 栈指针(Stack Pointer);

- pc — 程序计数器(Program Counter);

- g — 持有 runtime.gobuf 的 Goroutine;

- ret — 系统调用的返回值;

一般而言,线程切换会消耗 1000-1500 纳秒,一个纳秒平均可以执行 12-18 条指令。所以由于线程切换,执行指令的条数会减少 12000-18000。

Goroutine 的切换约为 200 ns,相当于 2400-3600 条指令。

因此,goroutines 切换成本比 threads 要小得多。

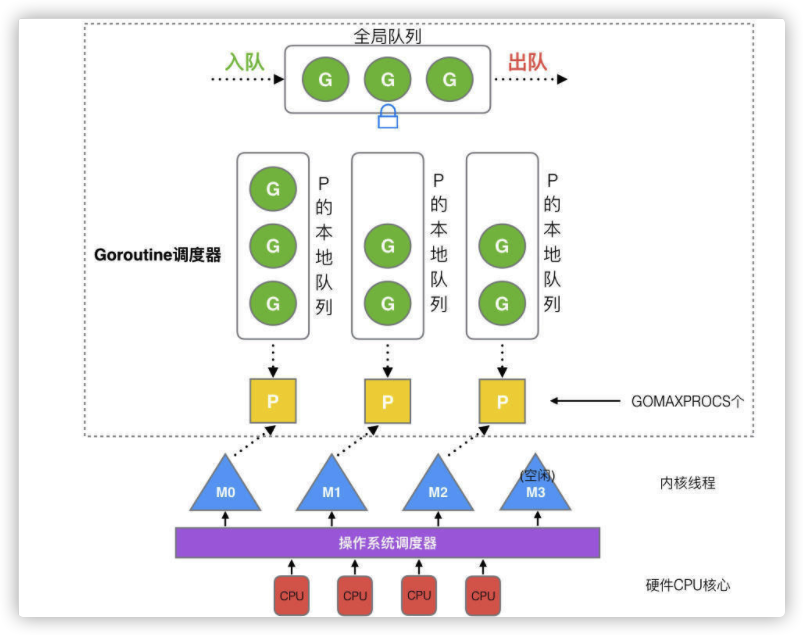

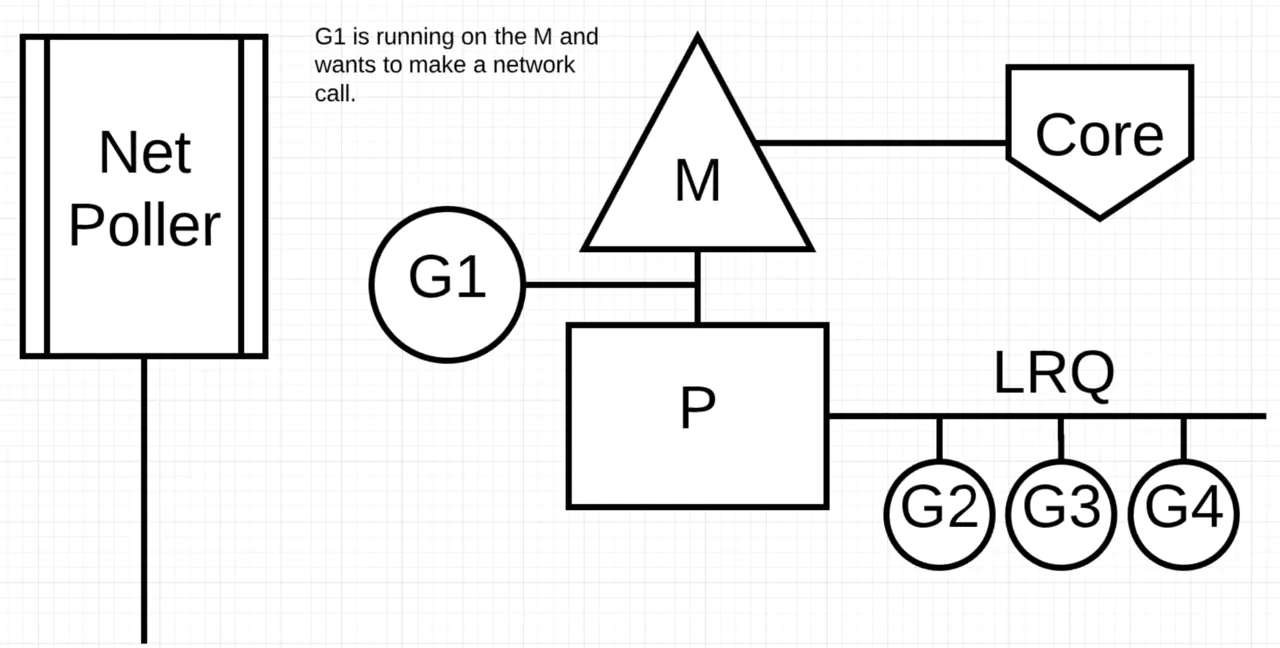

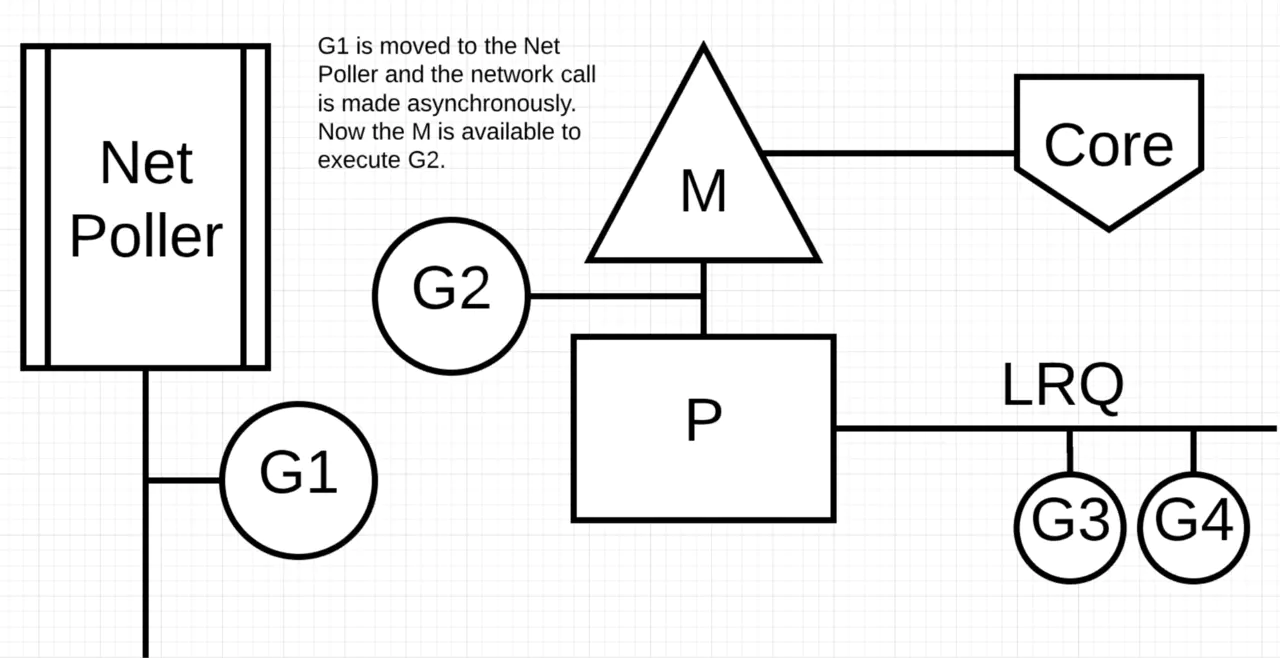

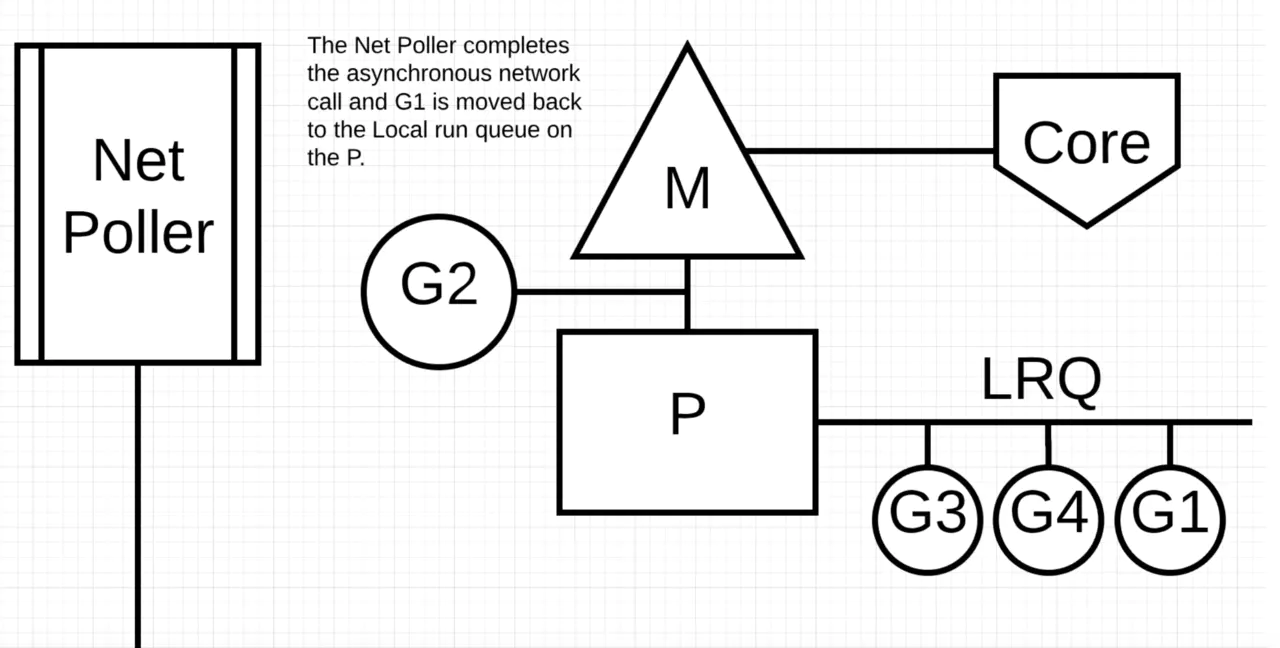

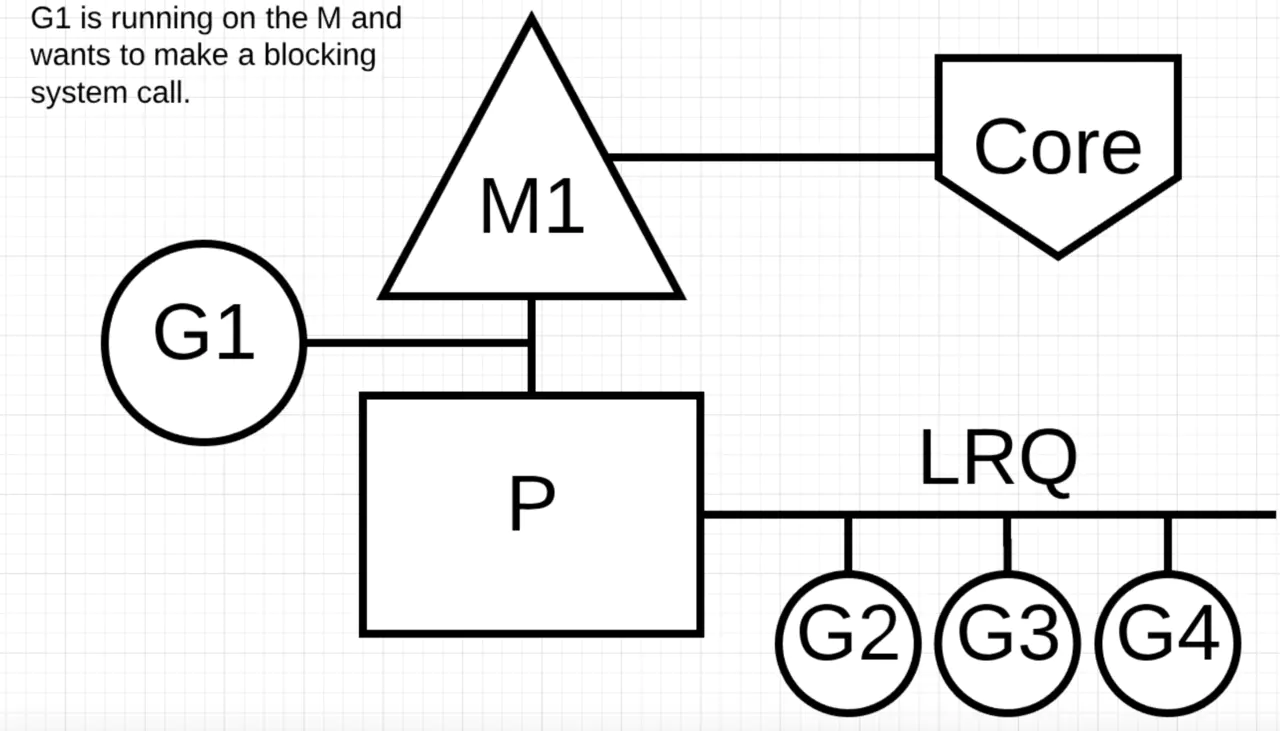

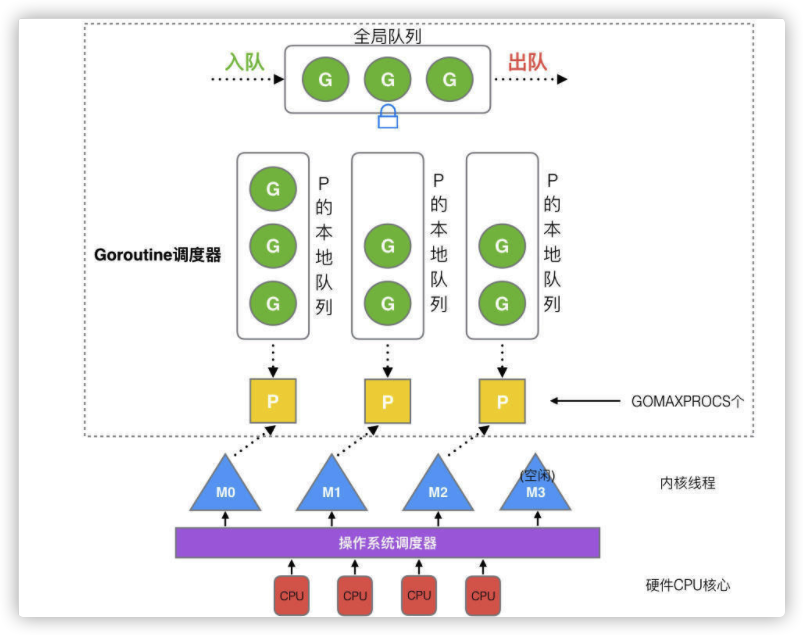

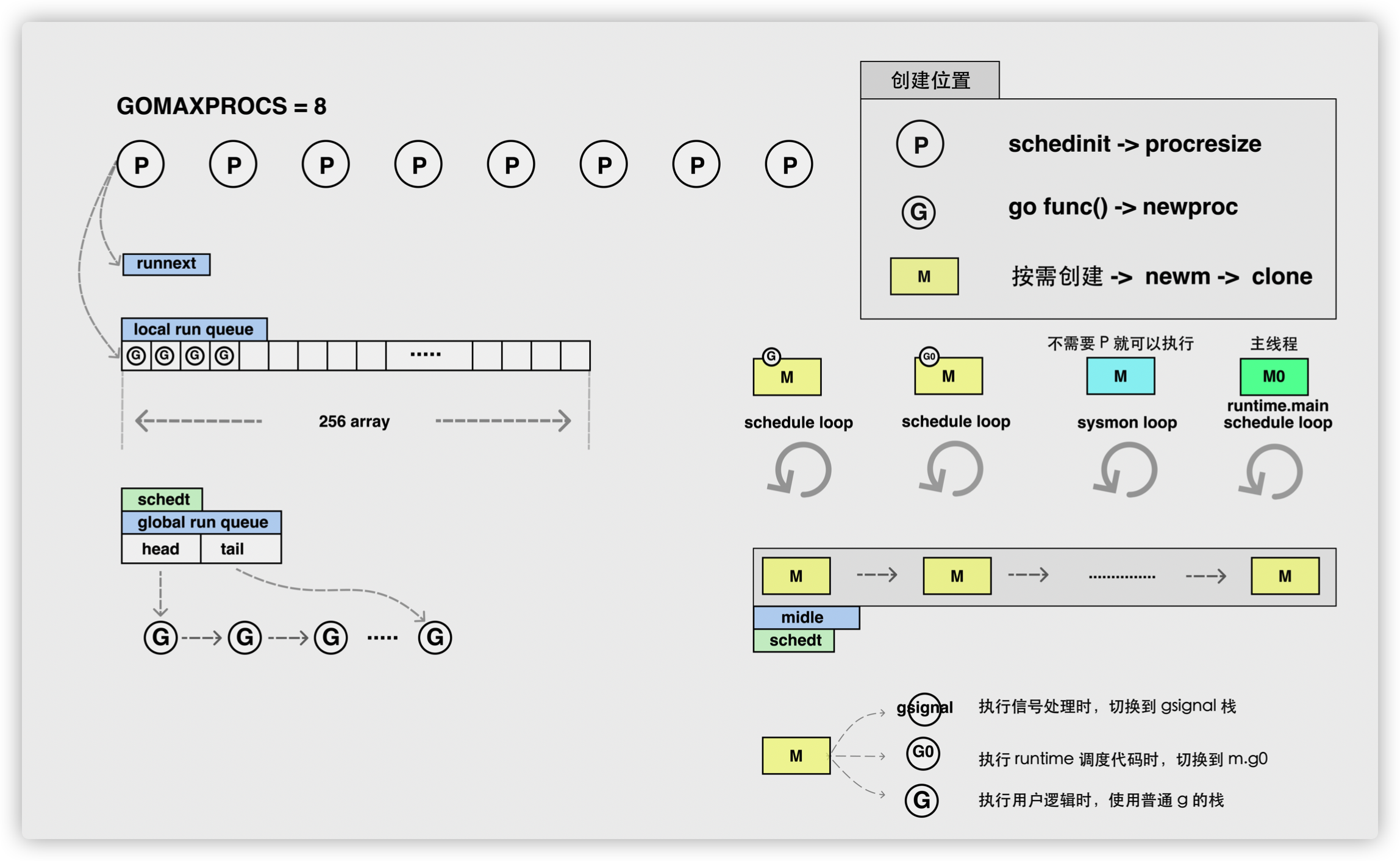

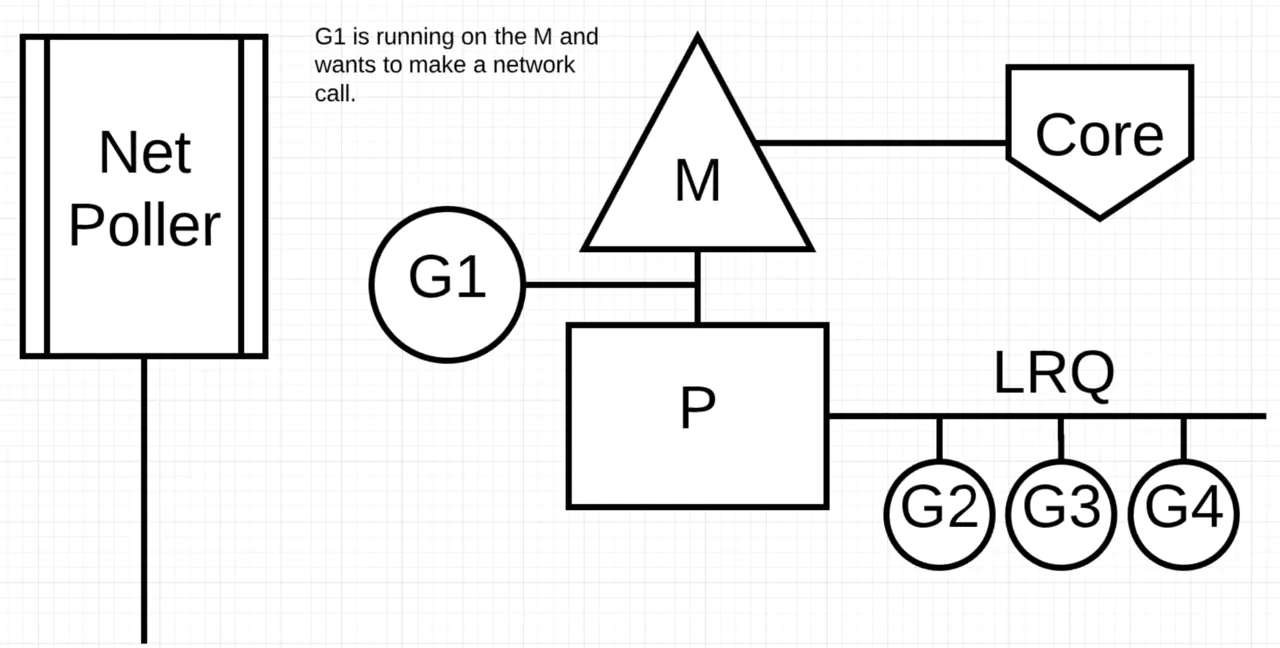

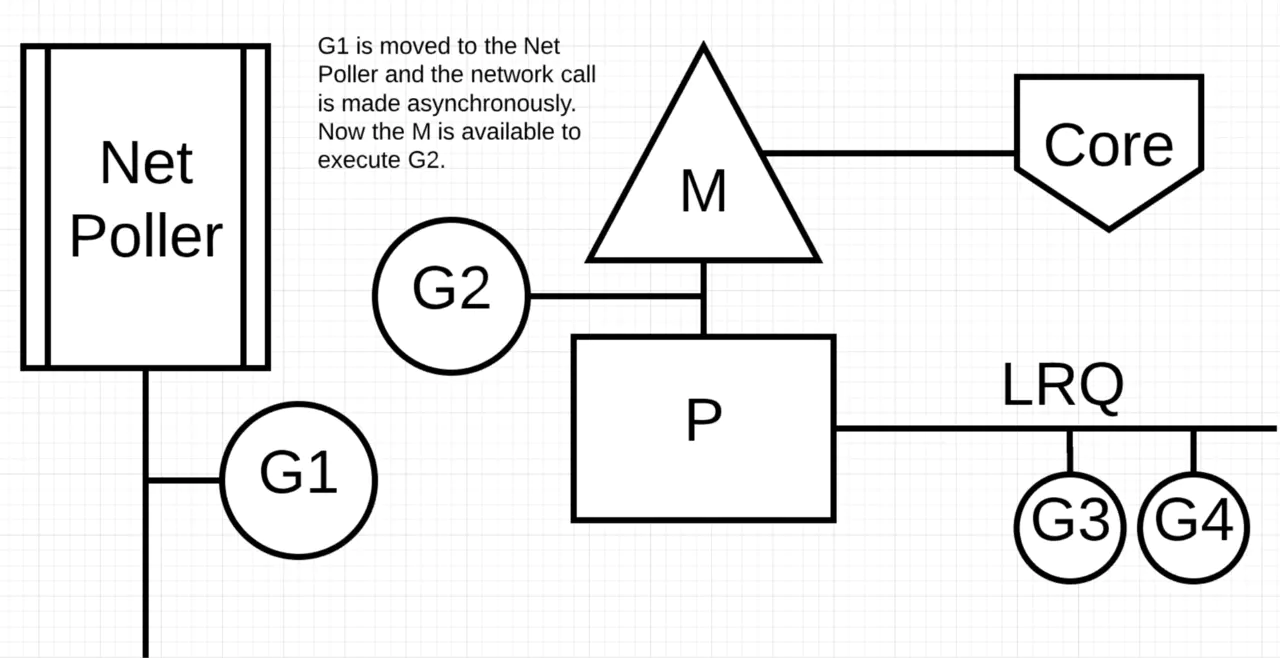

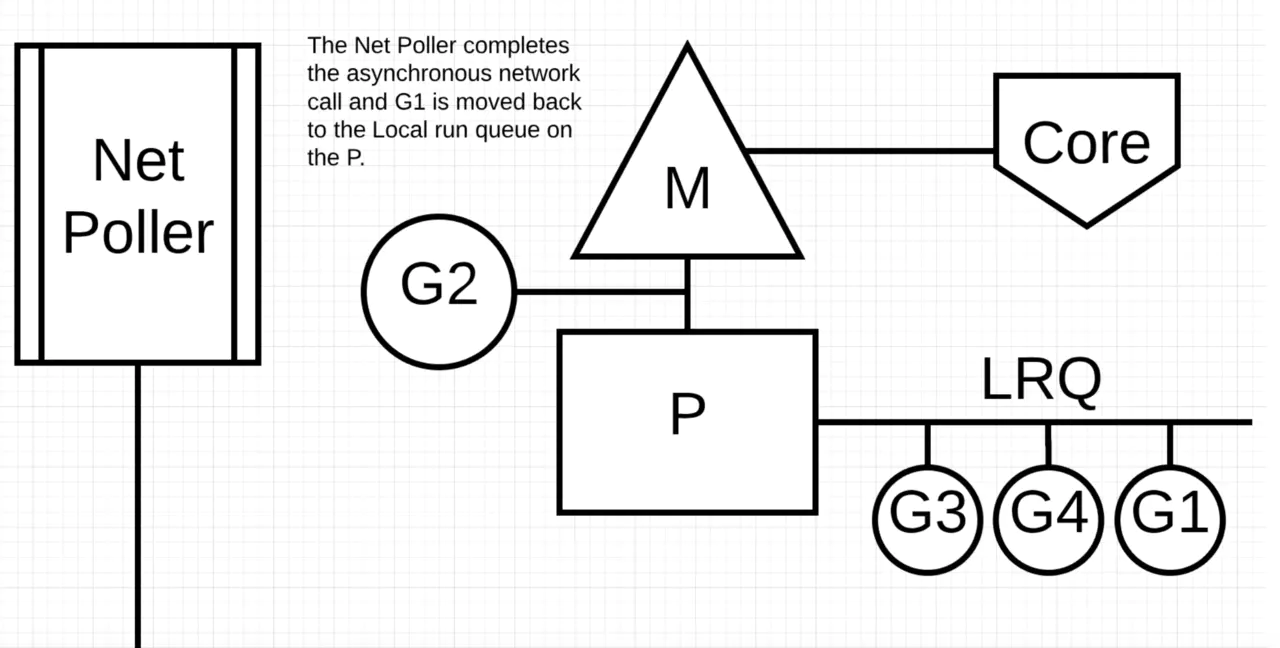

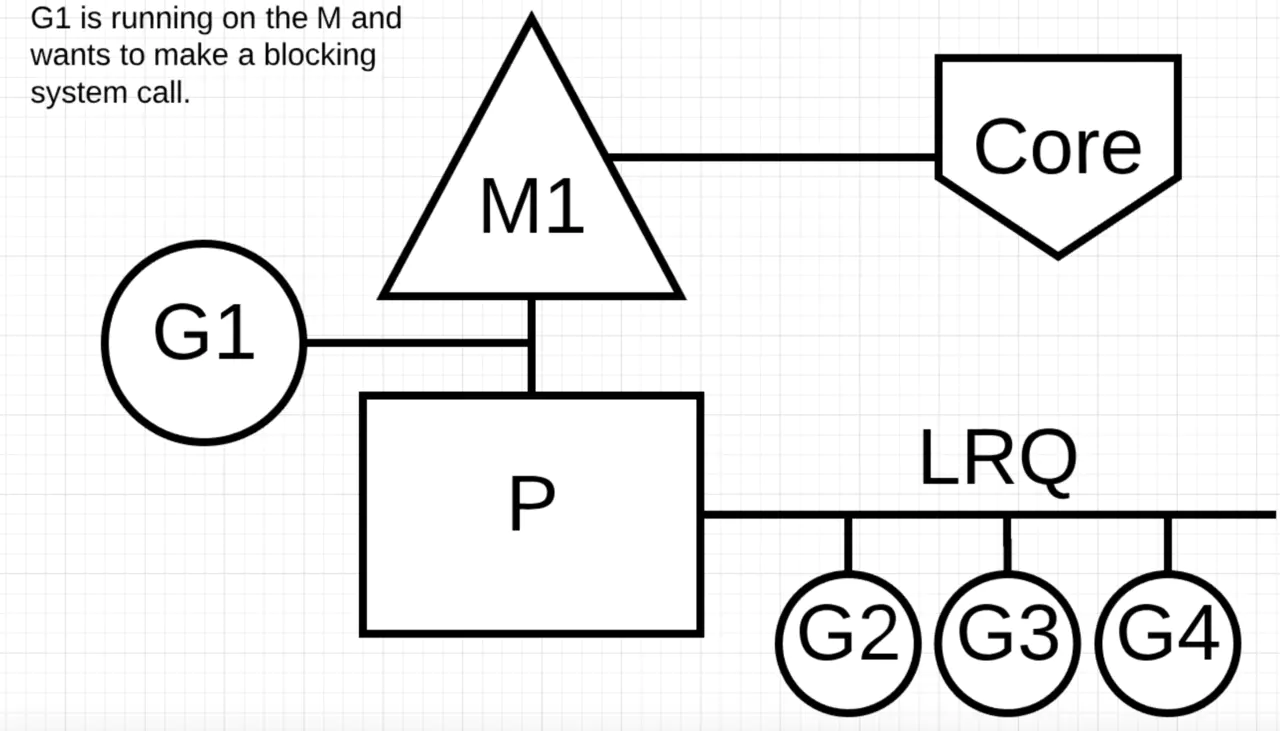

G-P-M模型

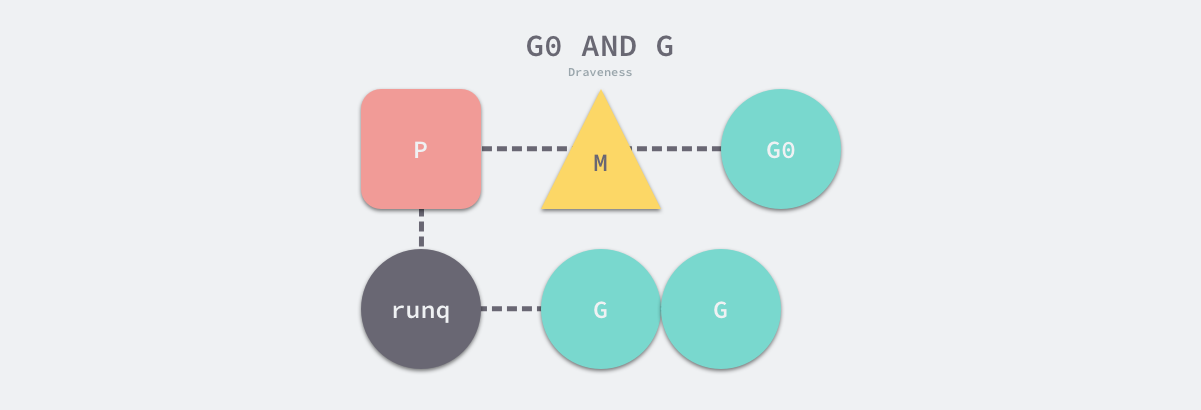

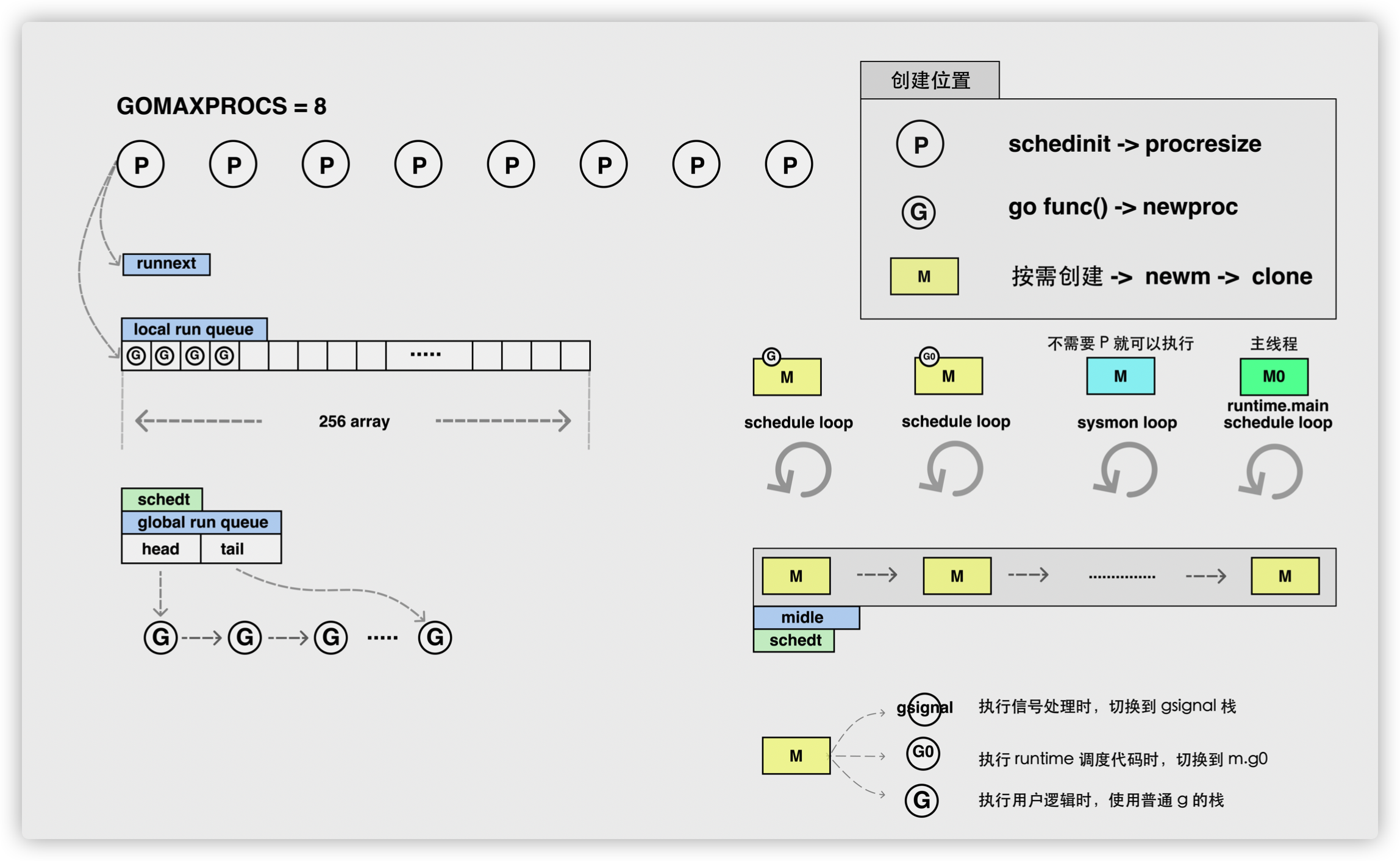

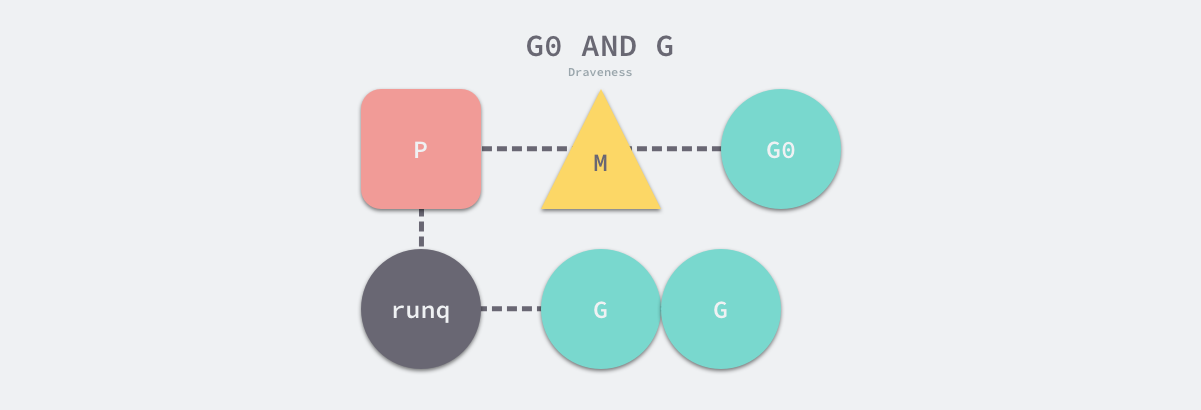

GPM:

-

G: 表示goroutine,存储了goroutine的执行stack信息、goroutine状态以及goroutine的任务函数等;另外G对象是可以重用的。

-

P: 表示逻辑processor,P的数量决定了系统内最大可并行的G的数量(前提:系统的物理cpu核数>=P的数量);P的最大作用还是其拥有的各种G对象队列、链表、一些cache和状态。

-

M: M代表着真正的执行计算资源。在绑定有效的p后,进入schedule循环;而schedule循环的机制大致是从各种队列、p的本地队列中获取G,切换到G的执行栈上并执行G的函数,调用goexit做清理工作并回到m,如此反复。M并不保留G状态,这是G可以跨M调度的基础。

P是一个“逻辑Proccessor”,每个G要想真正运行起来,首先需要被分配一个P(进入到P的local runq中,这里暂忽略global runq那个环节)。对于G来说,P就是运行它的“CPU”,可以说:G的眼里只有P。但从Go scheduler视角来看,真正的“CPU”是M,只有将P和M绑定才能让P的runq中G得以真实运行起来。这样的P与M的关系,就好比Linux操作系统调度层面用户线程(user thread)与核心线程(kernel thread)的对应关系那样(N x M)。

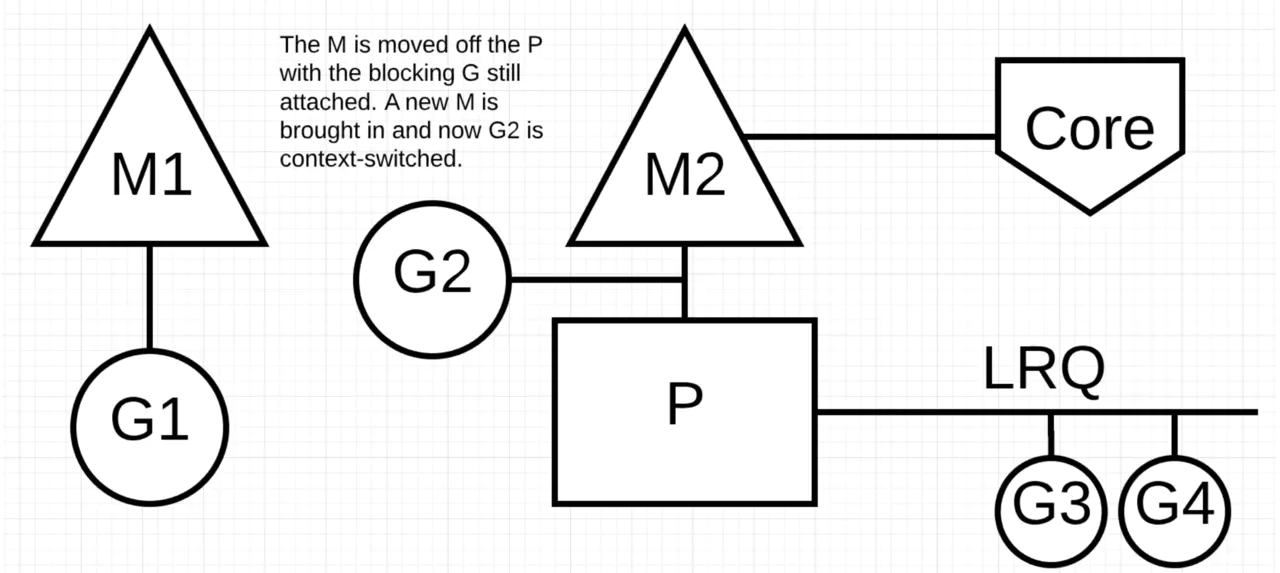

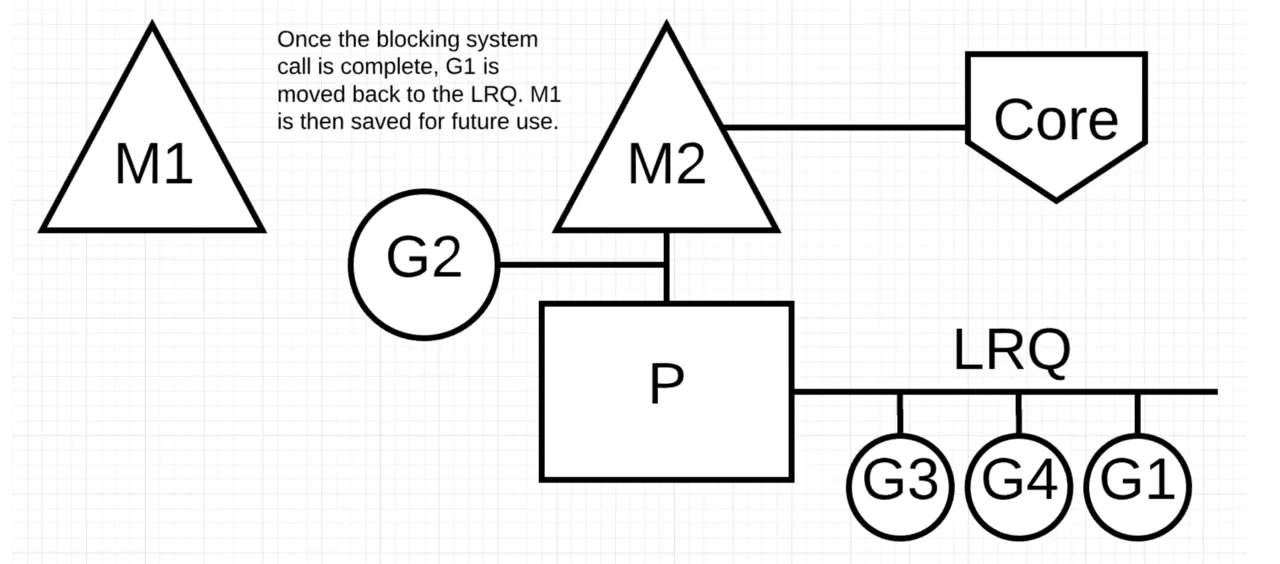

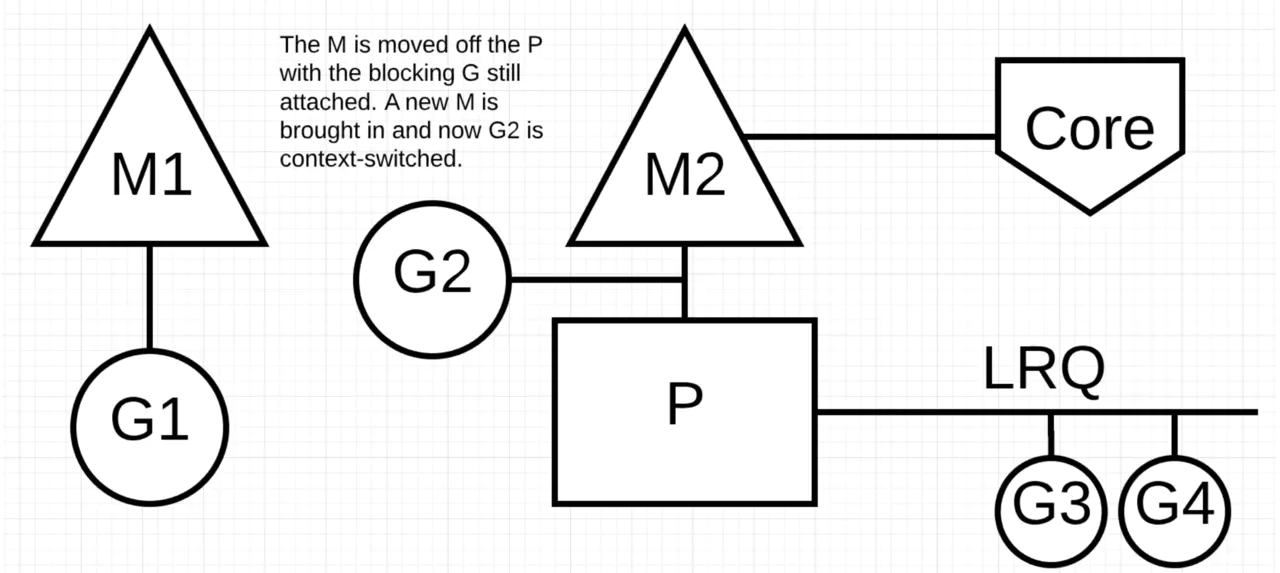

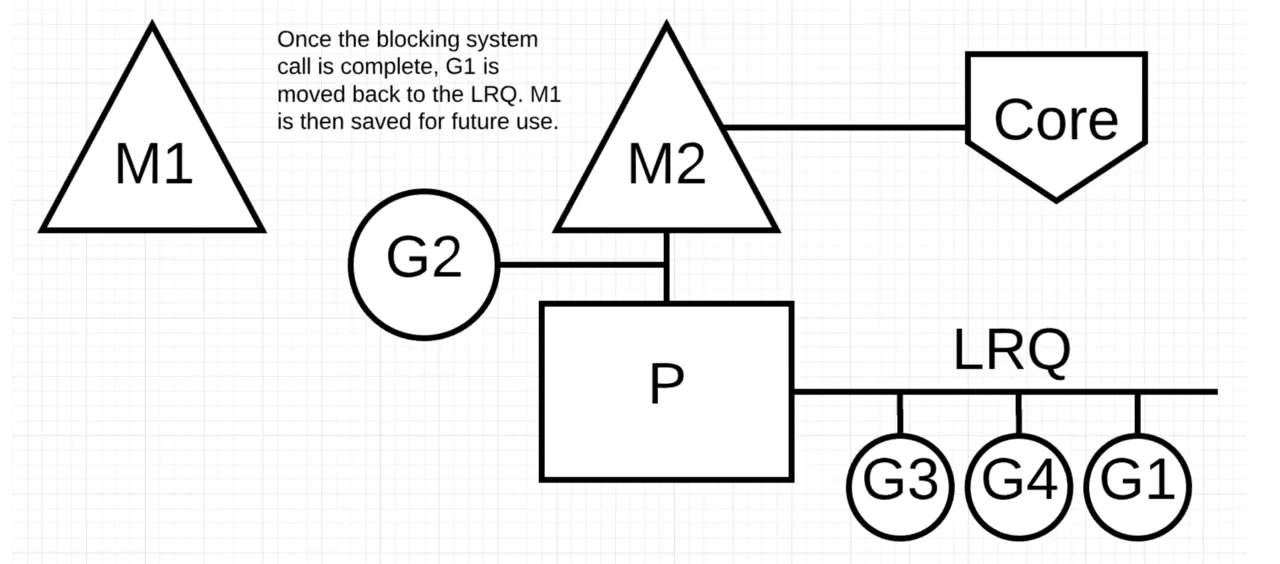

P必须和M组合起来执行G,但是两者也并不是完全1:1对应,通常情况下P的数量固定和CPU的核数一样(GOMAXPROCS参数),M则是按需创建,比如当M因为陷入系统调用而长时间阻塞的时候,P就会被监控线程抢回,去新建或者唤醒另一个M去执行,因此M的数量会增加,系统中可能存在一些阻塞的M。

Goroutine调度器和系统调度器是通过M结合起来的,每个M都代表了1个内核线程,系统调度器负责把内核线程分配到CPU的核上执行。

这幅图,展示了goroutine调度器和系统调度器的关系,而不是把二者割裂开来,并且从宏观的角度展示了调度器的重要组成。

自顶向下是调度器的4个部分:

- 全局队列(Global Queue):存放等待运行的G。

- P的本地队列:同全局队列类似,存放的也是等待运行的G,存的数量有限,不超过256个。新建G’时,G’优先加入到P的本地队列,如果队列满了,则会把本地队列中一半的G移动到全局队列。

- P列表:所有的P都在程序启动时创建,并保存在数组中,最多有GOMAXPROCS个。

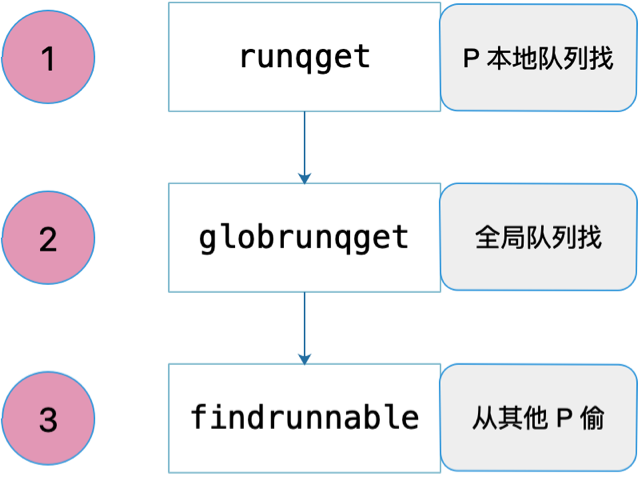

- M线程想运行任务就得获取P,从P的本地队列获取G,P队列为空时,M也会尝试从全局队列拿一批G放到P的本地队列,或从其他P的本地队列偷一半放到自己P的本地队列。M运行G,G执行之后,M会从P获取下一个G,不断重复下去。

G

G:goroutine,一个计算任务。由需要执行的代码和其上下文组成,上下文包括:当前代码位置,栈顶、栈底地址,状态等。

Goroutine 就是 Go 语言调度器中待执行的任务,它在运行时调度器中的地位与线程在操作系统中差不多,但是它占用了更小的内存空间,也降低了上下文切换的开销。

Goroutine 只存在于 Go 语言的运行时,它是 Go 语言在用户态提供的线程,作为一种粒度更细的资源调度单元,如果使用得当能够在高并发的场景下更高效地利用机器的 CPU。

当 goroutine 被调离 CPU 时,调度器负责把 CPU 寄存器的值保存在 g 对象的成员变量之中。

当 goroutine 被调度起来运行时,调度器又负责把 g 对象的成员变量所保存的寄存器值恢复到 CPU 的寄存器。

G 既然是 Goroutine,必然需要定义自身的执行栈:

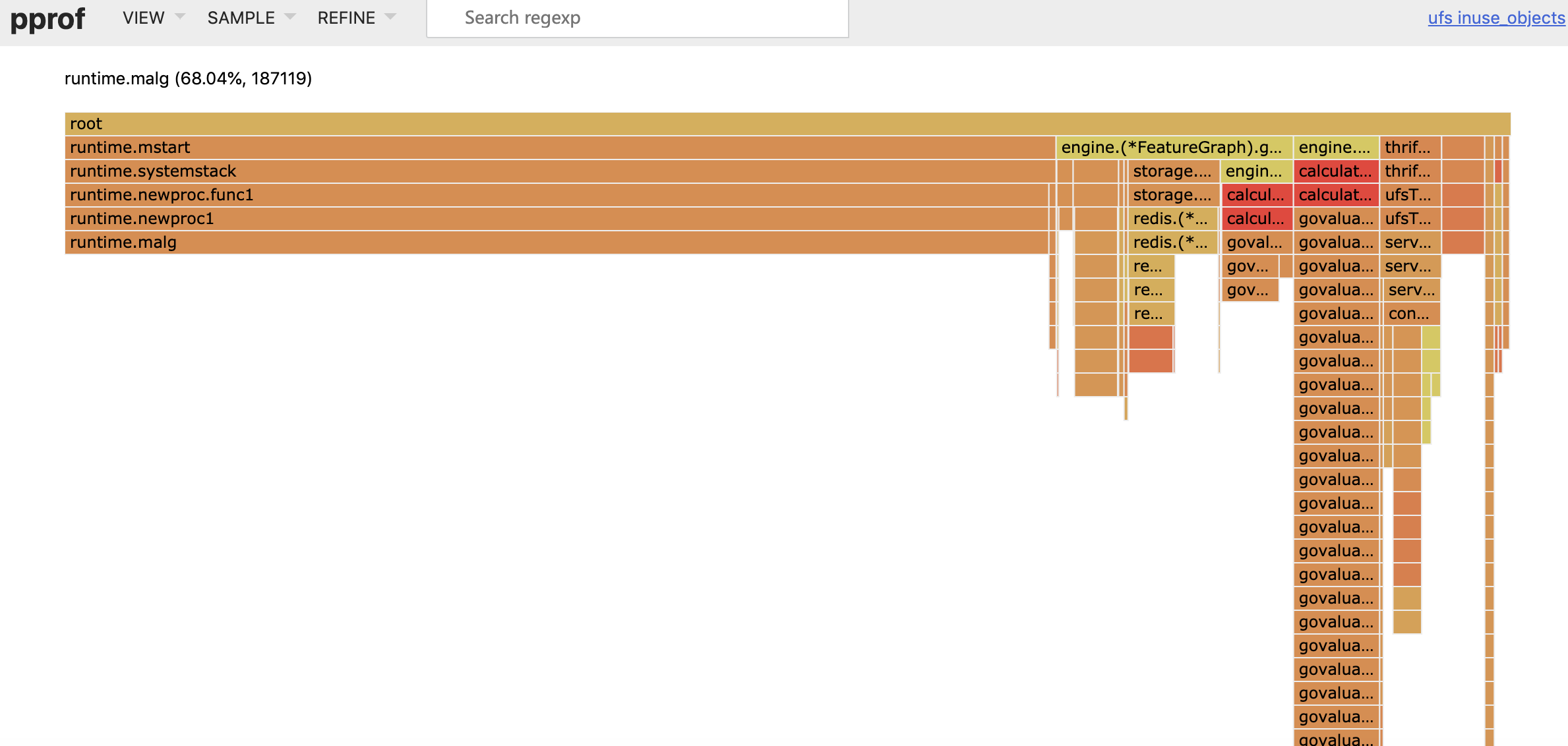

除了执行栈之外,还有很多与调试和 profiling 相关的字段。 一个 G 没有什么黑魔法,无非是将需要执行的函数参数进行了拷贝,保存了要执行的函数体的入口地址,用于执行。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

|

type g struct {

// Stack parameters.

// stack describes the actual stack memory: [stack.lo, stack.hi).

// stackguard0 is the stack pointer compared in the Go stack growth prologue.

// It is stack.lo+StackGuard normally, but can be StackPreempt to trigger a preemption.

// stackguard1 is the stack pointer compared in the C stack growth prologue.

// It is stack.lo+StackGuard on g0 and gsignal stacks.

// It is ~0 on other goroutine stacks, to trigger a call to morestackc (and crash).

// goroutine 使用的栈

stack stack // offset known to runtime/cgo //执行栈

// 用于栈的扩张和收缩检查,抢占标志

stackguard0 uintptr // offset known to liblink

stackguard1 uintptr // offset known to liblink

_panic *_panic // innermost panic - offset known to liblink

_defer *_defer // innermost defer

// 当前与 g 绑定的 m

m *m // current m; offset known to arm liblink

sched gobuf //用于保存执行现场

syscallsp uintptr // if status==Gsyscall, syscallsp = sched.sp to use during gc

syscallpc uintptr // if status==Gsyscall, syscallpc = sched.pc to use during gc

// 期望 sp 位于栈顶,用于回溯检查

stktopsp uintptr // expected sp at top of stack, to check in traceback

// wakeup 唤醒时候传递的参数

param unsafe.Pointer // passed parameter on wakeup

atomicstatus uint32

stackLock uint32 // sigprof/scang lock; TODO: fold in to atomicstatus

goid int64 //唯一序号

// 指向全局队列里下一个 g

schedlink guintptr //链表

// g 被阻塞之后的近似时间

waitsince int64 // approx time when the g become blocked

// g 被阻塞的原因

waitreason waitReason // if status==Gwaiting

// 抢占调度标志。这个为 true 时,stackguard0 等于 stackpreempt

// 抢占信号,stackguard0 = stackpreempt 的副本

preempt bool // preemption signal, duplicates stackguard0 = stackpreempt

paniconfault bool // panic (instead of crash) on unexpected fault address

preemptscan bool // preempted g does scan for gc

gcscandone bool // g has scanned stack; protected by _Gscan bit in status

gcscanvalid bool // false at start of gc cycle, true if G has not run since last scan; TODO: remove?

throwsplit bool // must not split stack

raceignore int8 // ignore race detection events

sysblocktraced bool // StartTrace has emitted EvGoInSyscall about this goroutine

// syscall 返回之后的 cputicks,用来做 tracing

sysexitticks int64 // cputicks when syscall has returned (for tracing)

traceseq uint64 // trace event sequencer

tracelastp puintptr // last P emitted an event for this goroutine

// 如果调用了 LockOsThread,那么这个 g 会绑定到某个 m 上

lockedm muintptr

sig uint32

writebuf []byte

sigcode0 uintptr

sigcode1 uintptr

sigpc uintptr

// 创建该 goroutine 的语句的指令地址

gopc uintptr // pc of go statement that created this goroutine //调用者PC/IP

ancestors *[]ancestorInfo // ancestor information goroutine(s) that created this goroutine (only used if debug.tracebackancestors)

// goroutine 函数的指令地址

startpc uintptr // pc of goroutine function //任务函数

racectx uintptr

waiting *sudog // sudog structures this g is waiting on (that have a valid elem ptr); in lock order

cgoCtxt []uintptr // cgo traceback context

labels unsafe.Pointer // profiler labels

// time.Sleep 缓存的定时器

timer *timer // cached timer for time.Sleep

selectDone uint32 // are we participating in a select and did someone win the race?

// Per-G GC state

// gcAssistBytes is this G's GC assist credit in terms of

// bytes allocated. If this is positive, then the G has credit

// to allocate gcAssistBytes bytes without assisting. If this

// is negative, then the G must correct this by performing

// scan work. We track this in bytes to make it fast to update

// and check for debt in the malloc hot path. The assist ratio

// determines how this corresponds to scan work debt.

gcAssistBytes int64

}

|

Goroutine 在 Go 语言运行时使用私有结构体 runtime.g 表示。这个私有结构体非常复杂,总共包含 40 多个用于表示各种状态的成员变量,我们在这里也不会介绍全部字段,而是会挑选其中的一部分进行介绍,首先是与栈相关的两个字段:

1

2

3

4

|

type g struct {

stack stack

stackguard0 uintptr

}

|

stack 字段描述了当前 Goroutine 的栈内存范围 [stack.lo, stack.hi),另一个字段 stackguard0 可以用于调度器抢占式调度。

1

2

3

4

5

6

7

|

// 描述栈的数据结构,栈的范围:[lo, hi)

type stack struct {

// 栈顶,低地址

lo uintptr

// 栈低,高地址

hi uintptr

}

|

除了 stackguard0 之外,Goroutine 中还包含另外三个与抢占密切相关的字段:

1

2

3

4

5

|

type g struct {

preempt bool // 抢占信号

preemptStop bool // 抢占时将状态修改成 `_Gpreempted`

preemptShrink bool // 在同步安全点收缩栈

}

|

我们再节选一些比较有趣或者重要的字段:

1

2

3

4

5

6

|

type g struct {

m *m

sched gobuf

atomicstatus uint32

goid int64

}

|

- m — 当前 Goroutine 占用的线程,可能为空;

- atomicstatus — Goroutine 的状态;

- sched — 存储 Goroutine 的调度相关的数据;

- goid — Goroutine 的 ID,该字段对开发者不可见,Go 团队认为引入 ID 会让部分 Goroutine 变得更特殊,从而限制语言的并发能力;

上述四个字段中,我们需要展开介绍 sched 字段的 runtime.gobuf 结构体中包含哪些内容:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

type gobuf struct {

// 存储 rsp 寄存器的值

sp uintptr

// 存储 rip 寄存器的值

pc uintptr

// 指向 goroutine

g guintptr

ctxt unsafe.Pointer // this has to be a pointer so that gc scans it

// 保存系统调用的返回值

ret sys.Uintreg

lr uintptr

bp uintptr // for GOEXPERIMENT=framepointer

}

|

- sp — 栈指针(Stack Pointer);

- pc — 程序计数器(Program Counter);

- g — 持有 runtime.gobuf 的 Goroutine;

- ret — 系统调用的返回值;

如果你知道程序时如何在计算机中执行的话(取指、译码、执行),那你就不会对这个结构体感到陌生。由于go的两级线程模型,所以G既要包含代码,又要包含用于执行该代码的栈以以及sp和pc。SP指向的是保存程序数据的栈的栈顶,PC指向的是正在取指的指令。而gogo函数的作用就是从sched结构中恢复出上次G被调度器暂停时的寄存器现场(SP、PC等),这样G就可以从上次暂停的地方继续执行了。

Goroutine 与 defer 和 panic 也有千丝万缕的联系,每一个 Goroutine 上都持有两个分别存储 defer 和 panic 对应结构体的链表:

1

2

3

4

|

type g struct {

_panic *_panic // 最内侧的 panic 结构体

_defer *_defer // 最内侧的延迟函数结构体

}

|

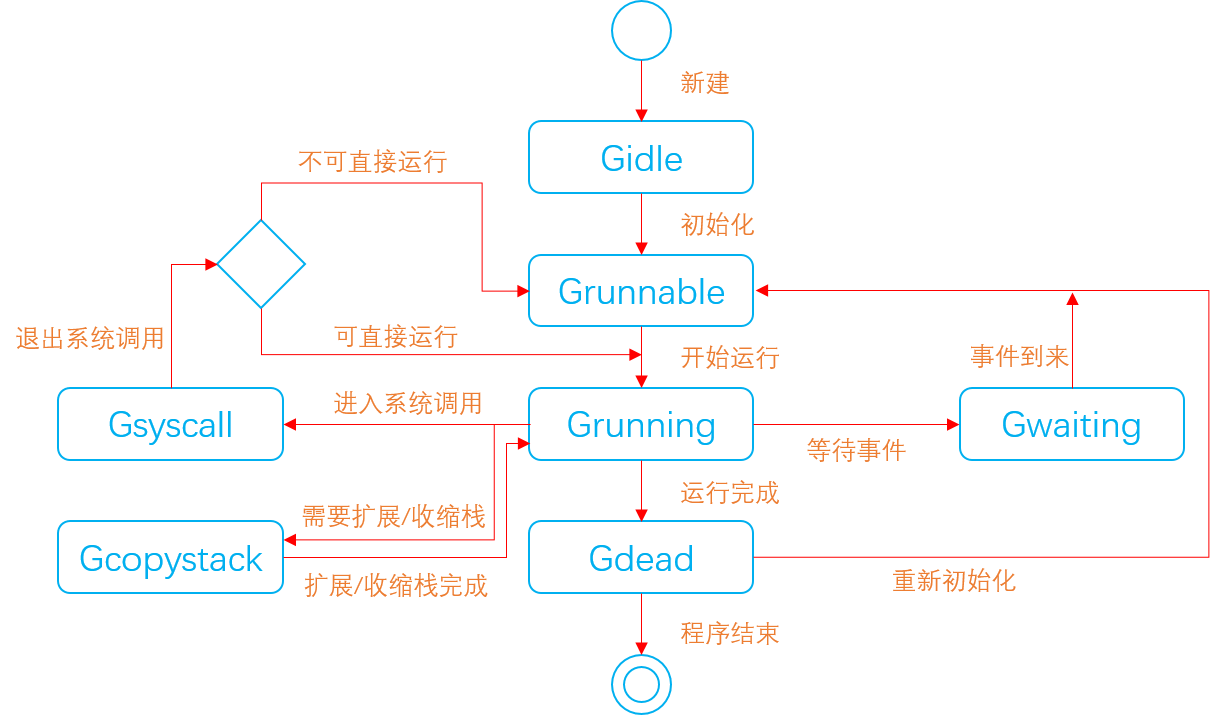

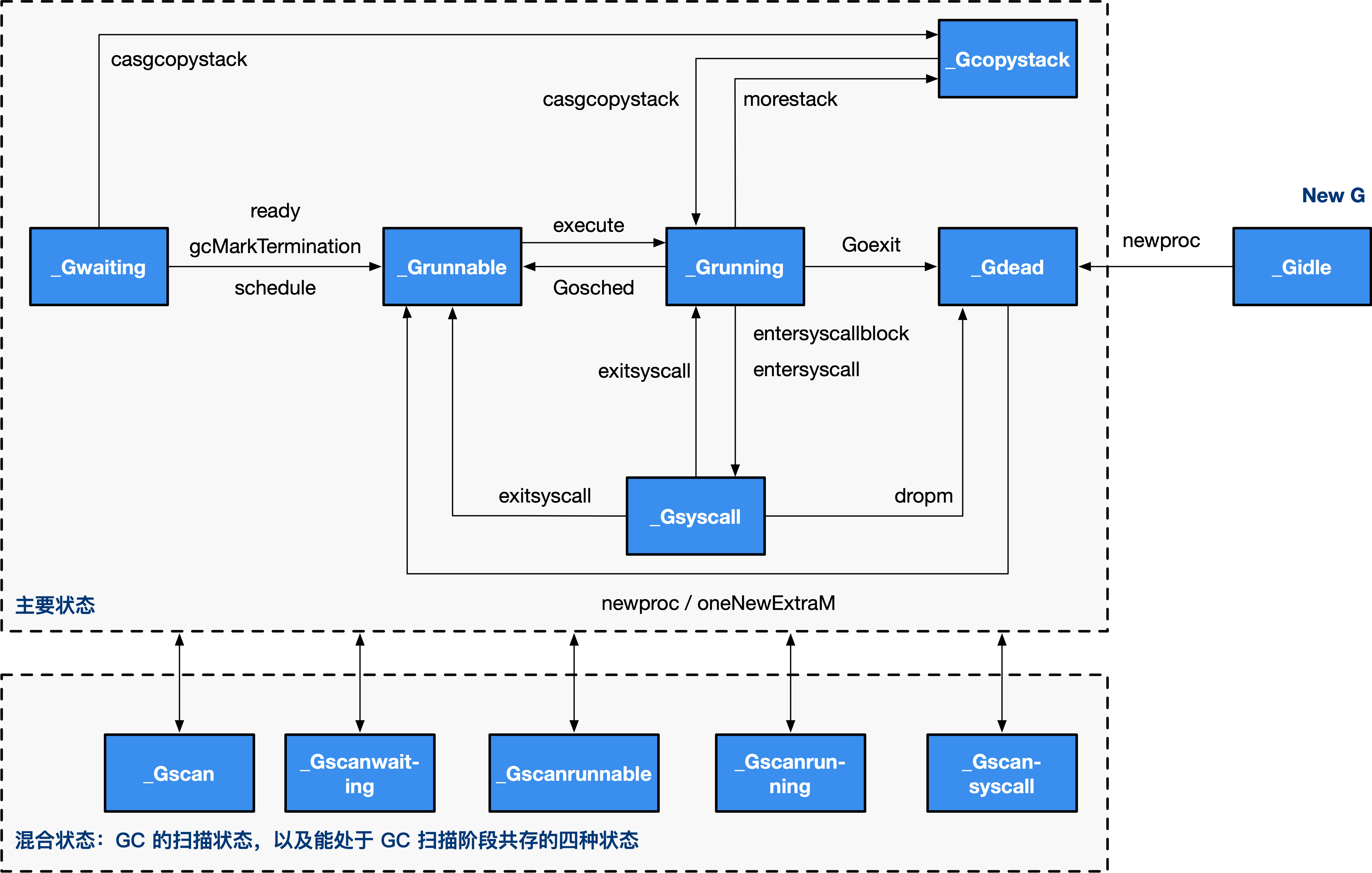

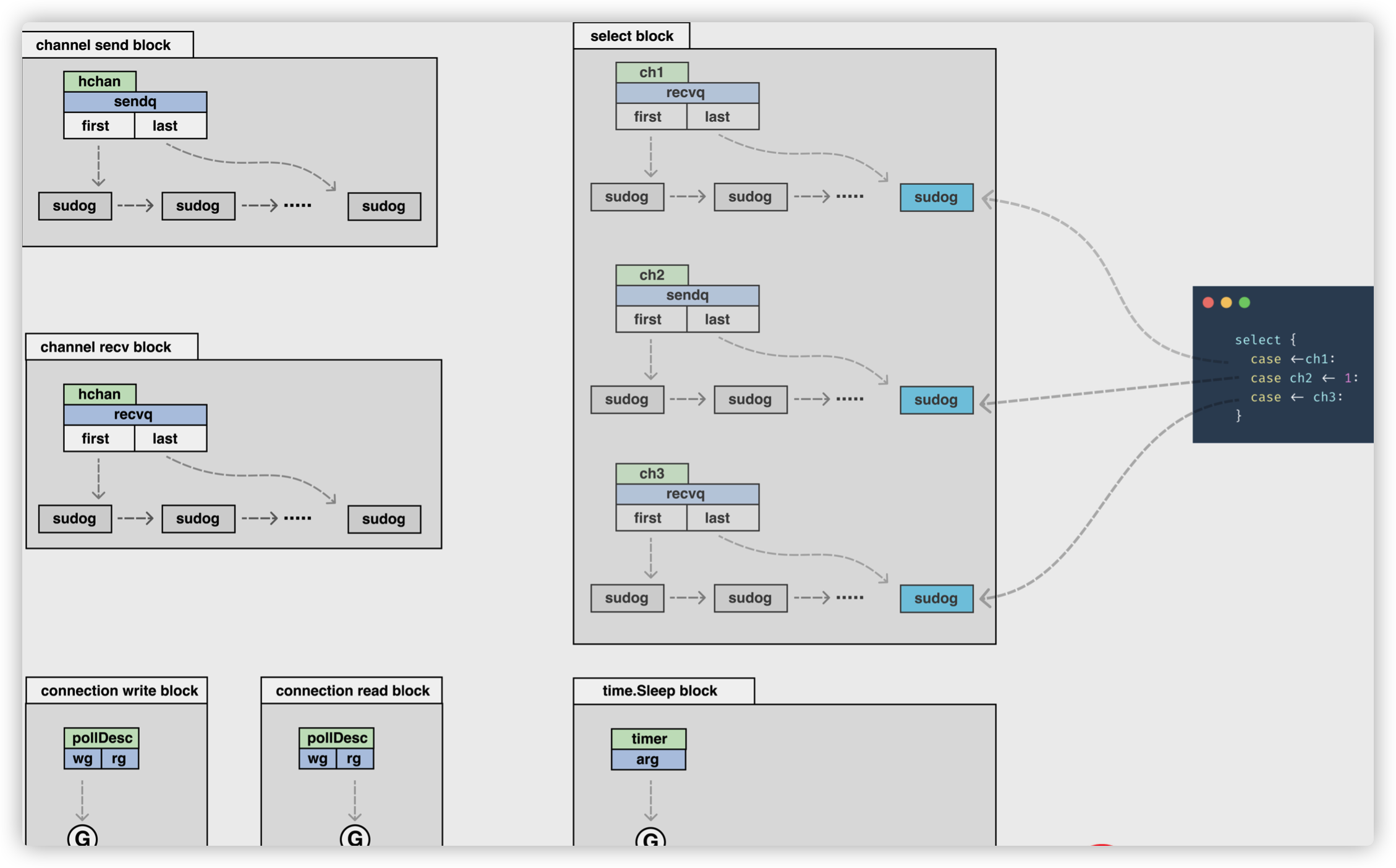

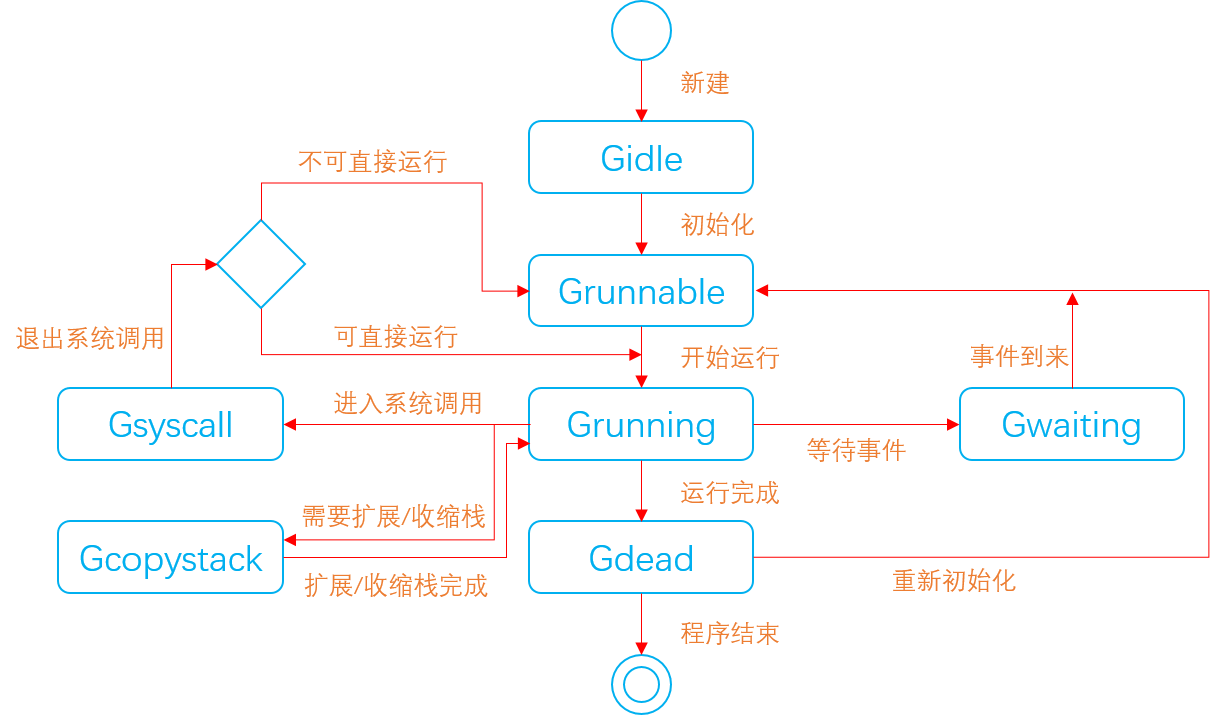

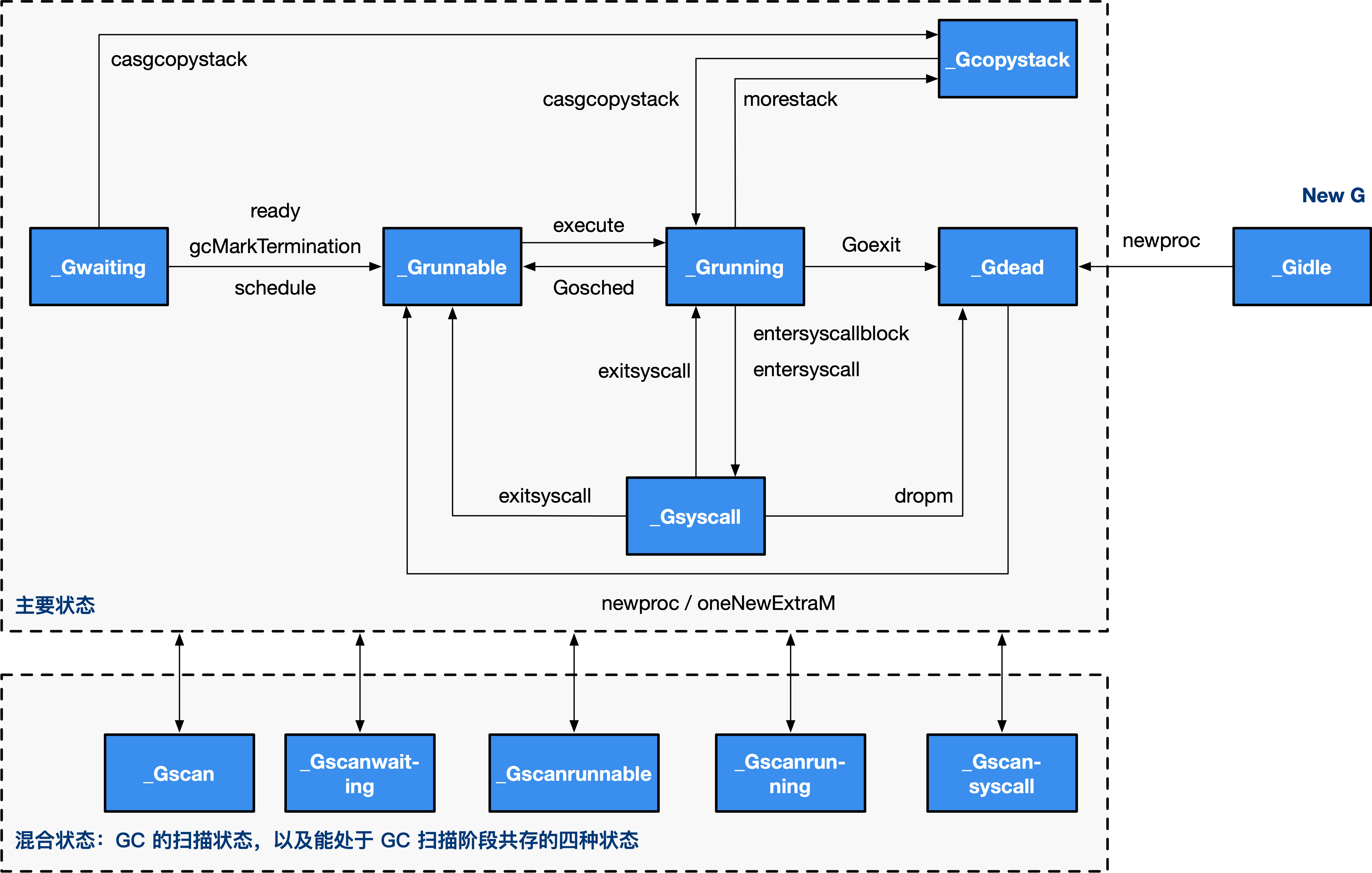

结构体 runtime.g 的 atomicstatus 字段就存储了当前 Goroutine 的状态。除了几个已经不被使用的以及与 GC 相关的状态之外,Goroutine 可能处于以下 9 个状态:

| 状态 |

描述 |

| _Gidle |

刚刚被分配并且还没有被初始化 |

| _Grunnable |

没有执行代码,没有栈的所有权,存储在运行队列中 |

| _Grunning |

可以执行代码,拥有栈的所有权,被赋予了内核线程 M 和处理器 P |

| _Gsyscall |

正在执行系统调用,拥有栈的所有权,没有执行用户代码,被赋予了内核线程 M 但是不在运行队列上 |

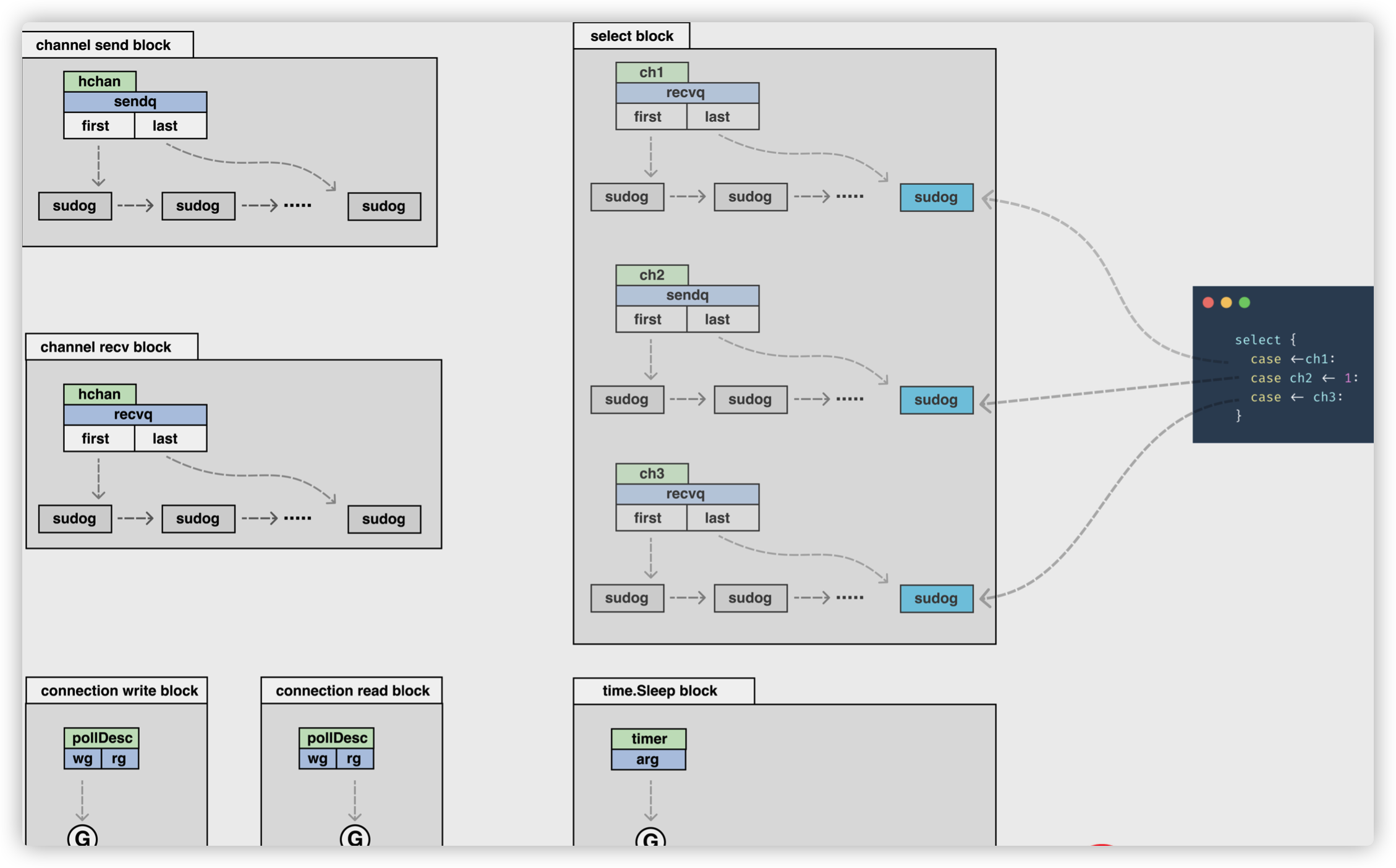

| _Gwaiting |

由于运行时而被阻塞,没有执行用户代码并且不在运行队列上,但是可能存在于 Channel 的等待队列上 |

| _Gdead |

没有被使用,没有执行代码,可能有分配的栈 |

| _Gcopystack |

栈正在被拷贝,没有执行代码,不在运行队列上 |

| _Gpreempted |

由于抢占而被阻塞,没有执行用户代码并且不在运行队列上,等待唤醒 |

| _Gscan |

GC 正在扫描栈空间,没有执行代码,可以与其他状态同时存在 |

上述状态中比较常见是_Grunnable、_Grunning、_Gsyscall、_Gwaiting 和_Gpreempted 五个状态,我们会重点介绍这几个状态,Goroutine 的状态迁移是一个复杂的过程,触发 Goroutine 状态迁移的方法也很多,在这里我们也没有办法介绍全部的迁移线路,我们会从中选择一些进行介绍。

虽然 Goroutine 在运行时中定义的状态非常多而且复杂,但是我们可以将这些不同的状态聚合成最终的三种:等待中、可运行、运行中,在运行期间我们会在这三种不同的状态来回切换:

- 等待中:Goroutine 正在等待某些条件满足,例如:系统调用结束等,包括 _Gwaiting、_Gsyscall 和 _Gpreempted 几个状态;

- 可运行:Goroutine 已经准备就绪,可以在线程运行,如果当前程序中有非常多的 Goroutine,每个 Goroutine 就可能会等待更多的时间,即_Grunnable;

- 运行中:Goroutine 正在某个线程上运行,即 _Grunning;

golang-goroutine-state-transition

上图展示了 Goroutine 状态迁移的常见路径,其中包括创建 Goroutine 到 Goroutine 被执行、触发系统调用或者抢占式调度器的状态迁移过程。

一个G在创建之初是Gidle状态。只有被初始化之后,其状态才变成Grunnable。一个G真正开始被使用是在其状态设置为Grunnabel之后。

一个G在运行过程中是否会等待某个事件以及等待什么事件,完全由其封装的go函数决定。涉及通道操作,网络I/O以及操纵定时器和调用time.sleep函数会使G进入Gwaiting状态。

事件到来之后,等待的G会被唤醒,并置于Grunnable状态,等待运行。

G在退出系统调用时,运行时系统会首先尝试直接运行这个G。仅当无法直接运行时,才会把它转换为Grunnable状态并放入调度器的可运行G队列。那么为什么不是放入本地P的可运行G队列呢?因为在G进入系统调用之后,本地P就与当前M分离开了。当G退出系统调用时,本地P已经不在了,也就是说这个G没有本地P,所以只能让调度器去接纳它了。

进入死亡状态(Gdead)的G会被放入本地P或调度器的自由G列表,可以在需要的时候重新初始化并使用。相比之下,P在进入死亡状态(Pdead)之后,只能面临销毁的结局。

G 的状态流转:

说明一下,上图省略了一些垃圾回收的状态。

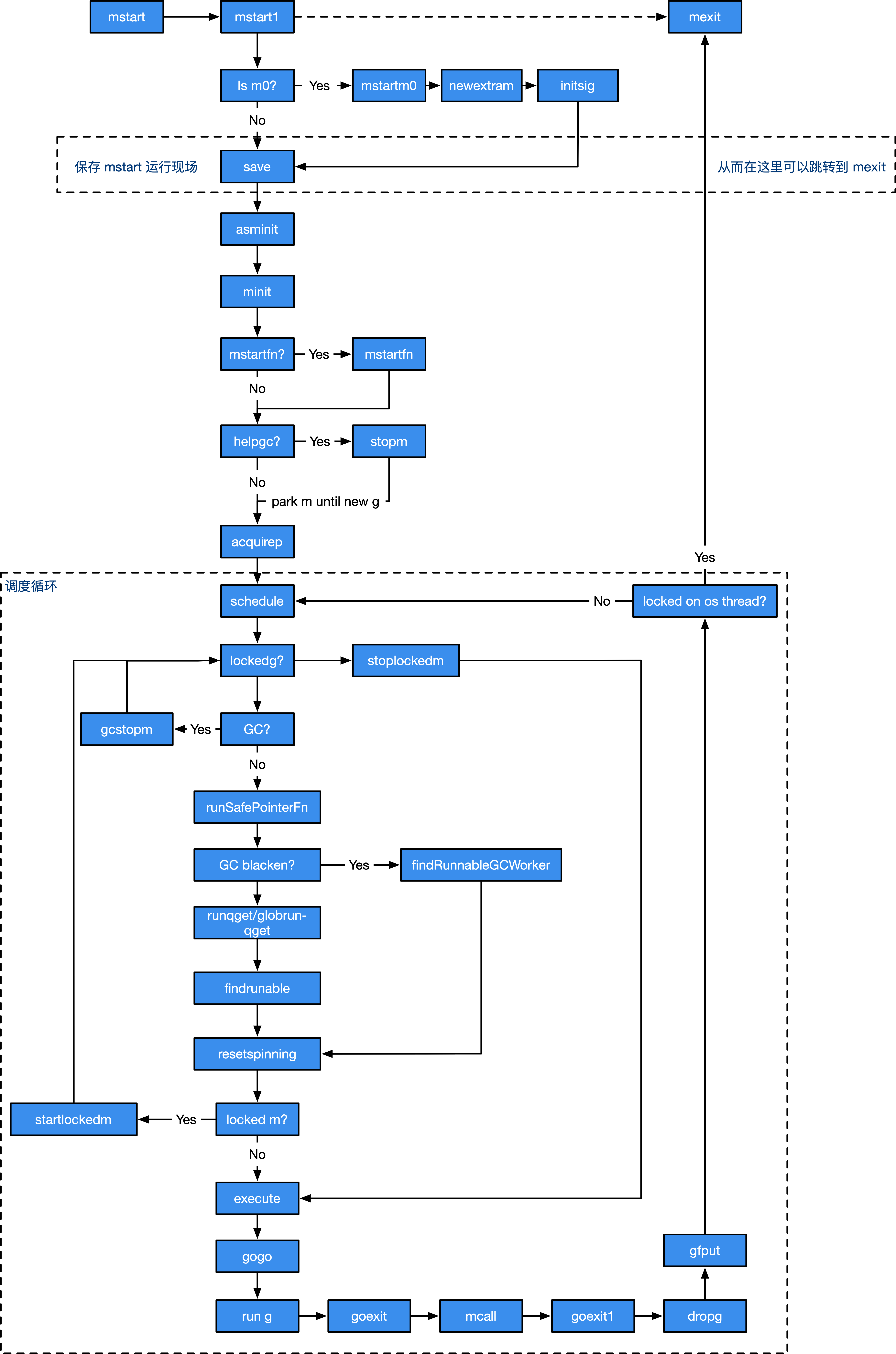

M

M:machine,系统线程,执行实体,想要在 CPU 上执行代码,必须有线程,与 C 语言中的线程相同,通过系统调用 clone 来创建。

Go 语言并发模型中的 M 是操作系统线程。调度器最多可以创建 10000 个线程,但是其中大多数的线程都不会执行用户代码(可能陷入系统调用),最多只会有 GOMAXPROCS 个活跃线程能够正常运行。

在默认情况下,运行时会将 GOMAXPROCS 设置成当前机器的核数,我们也可以使用 runtime.GOMAXPROCS 来改变GOMAXPROCS。

在默认情况下,一个四核机器上会创建四个活跃的操作系统线程,每一个线程都对应一个运行时中的 runtime.m 结构体。

在大多数情况下,我们都会使用 Go 的默认设置,也就是线程数等于 CPU 个数,在这种情况下不会触发操作系统的线程调度和上下文切换,所有的调度都会发生在用户态,由 Go 语言调度器触发,能够减少非常多的额外开销。

操作系统线程在 Go 语言中会使用私有结构体 runtime.m 来表示.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

|

type m struct {

// 记录工作线程(也就是内核线程)使用的栈信息。在执行调度代码时需要使用

// 执行用户 goroutine 代码时,使用用户 goroutine 自己的栈,因此调度时会发生栈的切换

g0 *g // goroutine with scheduling stack //提供系统栈空间

morebuf gobuf // gobuf arg to morestack

divmod uint32 // div/mod denominator for arm - known to liblink

// Fields not known to debuggers.

procid uint64 // for debuggers, but offset not hard-coded

// 处理 signal 的 g

gsignal *g // signal-handling g

goSigStack gsignalStack // Go-allocated signal handling stack

sigmask sigset // storage for saved signal mask

// 通过 tls 结构体实现 m 与工作线程的绑定

// 线程本地存储

tls [6]uintptr // thread-local storage (for x86 extern register)

//在新的M上启动某个特殊任务的函数,可能系统监控,GC辅助或M自旋。

mstartfn func() //启动函数

//当前M正在运行的那个G(goroutine)的指针。

curg *g // current running goroutine //当前运行G

caughtsig guintptr // goroutine running during fatal signal

// 执行 go 代码时持有的 p (如果没有执行则为 nil)

p puintptr // attached p for executing go code (nil if not executing go code) //绑定P

//暂存与当前M有潜在关联的P,将P赋给M的nextp字段称为M和P的预联。

nextp puintptr //临时存放P

oldp puintptr // the p that was attached before executing a syscall

id int64

mallocing int32

throwing int32

// 该字段不等于空字符串的话,要保持 curg 始终在这个 m 上运行

preemptoff string // if != "", keep curg running on this m

locks int32

dying int32

profilehz int32

// 为 true 时表示当前 m 处于自旋状态,正在从其他线程偷工作

spinning bool // m is out of work and is actively looking for work //自旋状态

// m 正阻塞在 note 上

blocked bool // m is blocked on a note

// m 正在执行 write barrier

inwb bool // m is executing a write barrier

newSigstack bool // minit on C thread called sigaltstack

printlock int8

// 正在执行 cgo 调用

incgo bool // m is executing a cgo call

freeWait uint32 // if == 0, safe to free g0 and delete m (atomic)

fastrand [2]uint32

needextram bool

traceback uint8

// cgo 调用总计数

ncgocall uint64 // number of cgo calls in total

ncgo int32 // number of cgo calls currently in progress

cgoCallersUse uint32 // if non-zero, cgoCallers in use temporarily

// cgo 调用崩溃的 cgo 回溯

cgoCallers *cgoCallers // cgo traceback if crashing in cgo call

// 没有 goroutine 需要运行时,工作线程睡眠在这个 park 成员上,

// 其它线程通过这个 park 唤醒该工作线程

park note //休眠锁

// 记录所有工作线程的链表

alllink *m // on allm

schedlink muintptr //链表

mcache *mcache

//与当前M锁定的G。一旦锁定,这个M只能运行这个G,这个G也只能由该M运行。

lockedg guintptr

createstack [32]uintptr // stack that created this thread.

lockedExt uint32 // tracking for external LockOSThread

lockedInt uint32 // tracking for internal lockOSThread

// 正在等待锁的下一个 m

nextwaitm muintptr // next m waiting for lock

waitunlockf unsafe.Pointer // todo go func(*g, unsafe.pointer) bool

waitlock unsafe.Pointer

waittraceev byte

waittraceskip int

startingtrace bool

syscalltick uint32

//线程句柄。真正用来执行go代码的系统线程。

// 工作线程 id

thread uintptr // thread handle

freelink *m // on sched.freem

// these are here because they are too large to be on the stack

// of low-level NOSPLIT functions.

libcall libcall

libcallpc uintptr // for cpu profiler

libcallsp uintptr

libcallg guintptr

syscall libcall // stores syscall parameters on windows

vdsoSP uintptr // SP for traceback while in VDSO call (0 if not in call)

vdsoPC uintptr // PC for traceback while in VDSO call

mOS

}

|

M 是 OS 线程的实体。我们介绍几个比较重要的字段,包括:

- 持有用于执行调度器的 g0

- 持有用于信号处理的 gsignal

- 持有线程本地存储 tls

- 持有当前正在运行的 curg

- 持有运行 Goroutine 时需要的本地资源 p

- 表示自身的自旋和非自旋状态 spining

- 管理在它身上执行的 cgo 调用

- 将自己与其他的 M 进行串联

- 持有当前线程上进行内存分配的本地缓存 mcache

等等其他五十多个字段,包括关于 M 的一些调度统计、调试信息等。

1

2

3

4

5

|

type m struct {

g0 *g

curg *g

...

}

|

其中 g0 是持有调度栈的 Goroutine,curg 是在当前线程上运行的用户 Goroutine,这也是操作系统线程唯一关心的两个 Goroutine。

g0 是一个运行时中比较特殊的 Goroutine,它会深度参与运行时的调度过程,包括 Goroutine 的创建、大内存分配和 CGO 函数的执行。在后面的小节中,我们会经常看到 g0 的身影。runtime.m 结构体中还存在着三个处理器字段,它们分别表示正在运行代码的处理器 p、暂存的处理器 nextp 和执行系统调用之前的使用线程的处理器 oldp:

1

2

3

4

5

|

type m struct {

p puintptr

nextp puintptr

oldp puintptr

}

|

除了在上面介绍的字段之外,runtime.m 中还包含大量与线程状态、锁、调度、系统调用有关的字段,我们会在分析调度过程时详细介绍。

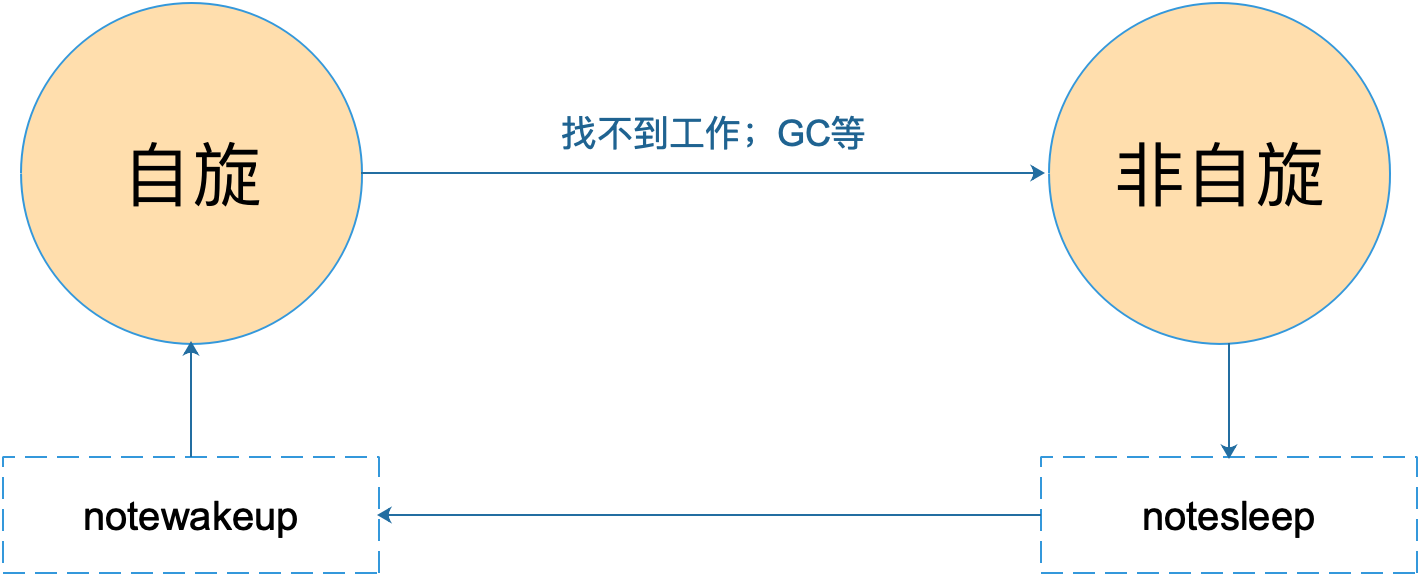

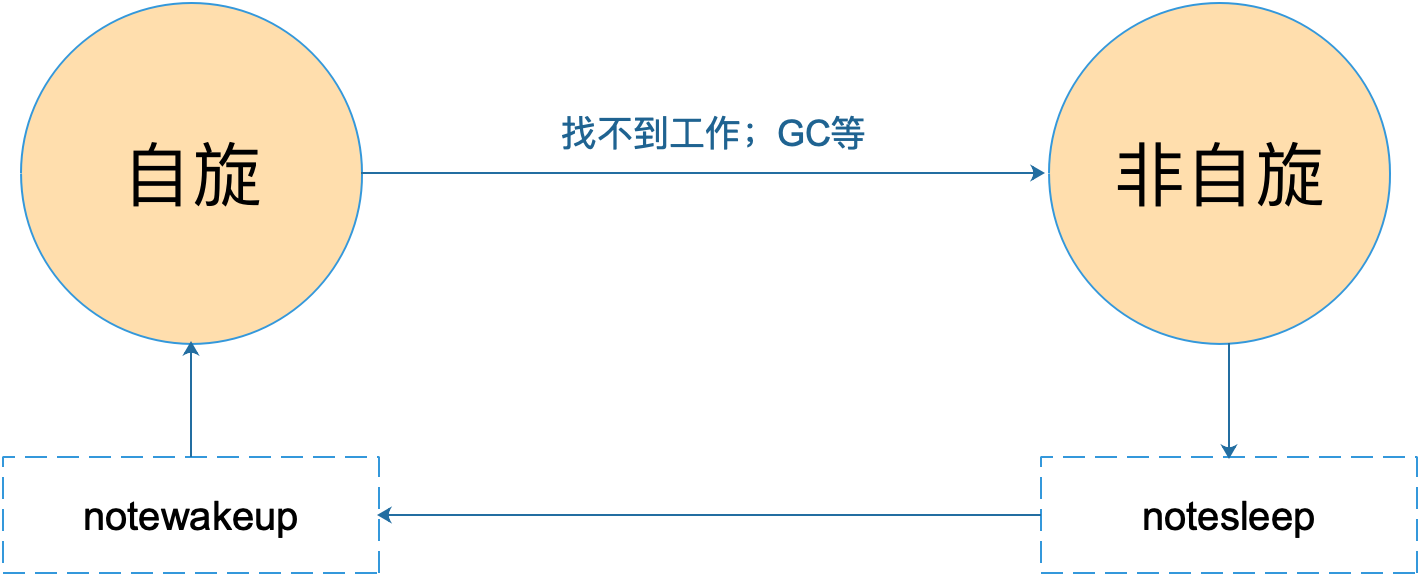

M 的状态变化:

M 只有自旋和非自旋两种状态。自旋的时候,会努力找工作;找不到的时候会进入非自旋状态,之后会休眠,直到有工作需要处理时,被其他工作线程唤醒,又进入自旋状态。

P

P:processor,虚拟处理器,M 必须获得 P 才能执行代码,否则必须陷入休眠(后台监控线程除外),你也可以将其理解为一种 token,有这个 token,才 有在物理 CPU 核心上执行的权力。

调度器中的处理器 P 是线程和 Goroutine 的中间层,它能提供线程需要的上下文环境,也会负责调度线程上的等待队列,通过处理器 P 的调度,每一个内核线程都能够执行多个 Goroutine,它能在 Goroutine 进行一些 I/O 操作时及时切换,提高线程的利用率。

因为调度器在启动时就会创建 GOMAXPROCS 个处理器,所以 Go 语言程序的处理器数量一定会等于 GOMAXPROCS,这些处理器会绑定到不同的内核线程上并利用线程的计算资源运行 Goroutine。

P 只是处理器的抽象,而非处理器本身,它存在的意义在于实现工作窃取(work stealing)算法。 简单来说,每个 P 持有一个 G 的本地队列。

在没有 P 的情况下,所有的 G 只能放在一个全局的队列中。 当 M 执行完 G 而没有 G 可执行时,必须将队列锁住从而取值。

当引入了 P 之后,P 持有 G 的本地队列,而持有 P 的 M 执行完 G 后在 P 本地队列中没有 发现其他 G 可以执行时,虽然仍然会先检查全局队列、网络,但这时增加了一个从其他 P 的 队列偷取(steal)一个 G 来执行的过程。优先级为本地 > 全局 > 网络 > 偷取。

所以整个结构除去 P 的本地 G 队列外,就是一些统计、调试、GC 辅助的字段了。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

|

type p struct {

lock mutex

// 在 allp 中的索引

id int32

//P的状态

status uint32 // one of pidle/prunning/...

link puintptr

// 调度计数 每次调用 schedule 时会加一

schedtick uint32 // incremented on every scheduler call

// 系统调用计数 每次系统调用时加一

syscalltick uint32 // incremented on every system call

// sysmon持有的调用计数备份,用于 sysmon 线程记录被监控 p 的系统调用时间和运行时间

sysmontick sysmontick // last tick observed by sysmon

// 反向链接到关联的 m (nil 则表示 idle)

m muintptr // back-link to associated m (nil if idle)

mcache *mcache

racectx uintptr

// 不同大小的可用的 defer 结构池

deferpool [5][]*_defer // pool of available defer structs of different sizes (see panic.go)

deferpoolbuf [5][32]*_defer

// Cache of goroutine ids, amortizes accesses to runtime·sched.goidgen.

goidcache uint64

goidcacheend uint64

// Queue of runnable goroutines. Accessed without lock.

//可运行G队列的队头

runqhead uint32

//可运行G队列的队尾

runqtail uint32

//可运行G队列,固定长度为256

runq [256]guintptr //本地队列,访问时无须加锁

// runnext, if non-nil, is a runnable G that was ready'd by

// the current G and should be run next instead of what's in

// runq if there's time remaining in the running G's time

// slice. It will inherit the time left in the current time

// slice. If a set of goroutines is locked in a

// communicate-and-wait pattern, this schedules that set as a

// unit and eliminates the (potentially large) scheduling

// latency that otherwise arises from adding the ready'd

// goroutines to the end of the run queue.

// runnext 非空时,代表的是一个 runnable 状态的 G,

// 这个 G 被 当前 G 修改为 ready 状态,相比 runq 中的 G 有更高的优先级。

// 如果当前 G 还有剩余的可用时间,那么就应该运行这个 G

// 运行之后,该 G 会继承当前 G 的剩余时间

runnext guintptr //优先执行

// Available G's (status == Gdead)

//自由G队列

gFree struct {

gList

n int32

}

sudogcache []*sudog

sudogbuf [128]*sudog

tracebuf traceBufPtr

// traceSweep indicates the sweep events should be traced.

// This is used to defer the sweep start event until a span

// has actually been swept.

traceSweep bool

// traceSwept and traceReclaimed track the number of bytes

// swept and reclaimed by sweeping in the current sweep loop.

traceSwept, traceReclaimed uintptr

palloc persistentAlloc // per-P to avoid mutex

// Per-P GC state

gcAssistTime int64 // Nanoseconds in assistAlloc

gcFractionalMarkTime int64 // Nanoseconds in fractional mark worker

gcBgMarkWorker guintptr

gcMarkWorkerMode gcMarkWorkerMode

// gcMarkWorkerStartTime is the nanotime() at which this mark

// worker started.

gcMarkWorkerStartTime int64

// gcw is this P's GC work buffer cache. The work buffer is

// filled by write barriers, drained by mutator assists, and

// disposed on certain GC state transitions.

gcw gcWork

// wbBuf is this P's GC write barrier buffer.

//

// TODO: Consider caching this in the running G.

wbBuf wbBuf

runSafePointFn uint32 // if 1, run sched.safePointFn at next safe point

pad cpu.CacheLinePad

}

|

runtime.p 是处理器的运行时表示,作为调度器的内部实现,它包含的字段也非常多,其中包括与性能追踪、垃圾回收和计时器相关的字段,这些字段也非常重要,但是在这里就不一一展示了,我们主要关注处理器中的线程和运行队列:

1

2

3

4

5

6

7

8

|

type p struct {

m muintptr

runqhead uint32

runqtail uint32

runq [256]guintptr

runnext guintptr

...

}

|

反向存储的线程维护着线程与处理器之间的关系,而 runhead、runqtail 和 runq 三个字段表示处理器持有的运行队列,其中存储着待执行的 Goroutine 列表,runnext 中是线程下一个需要执行的 Goroutine。

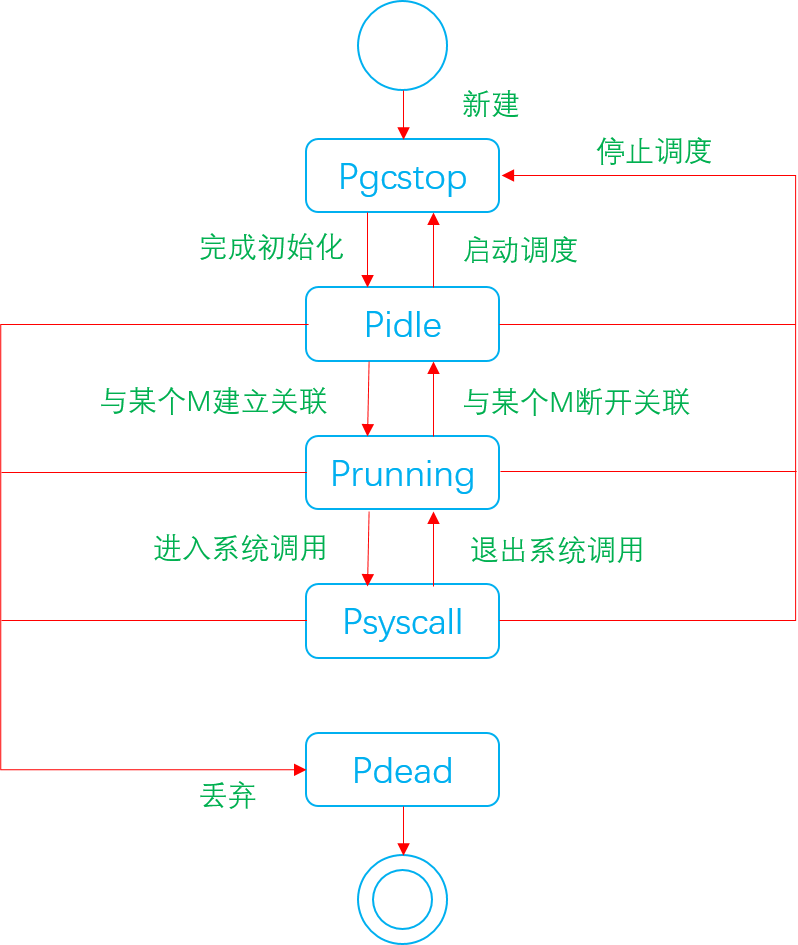

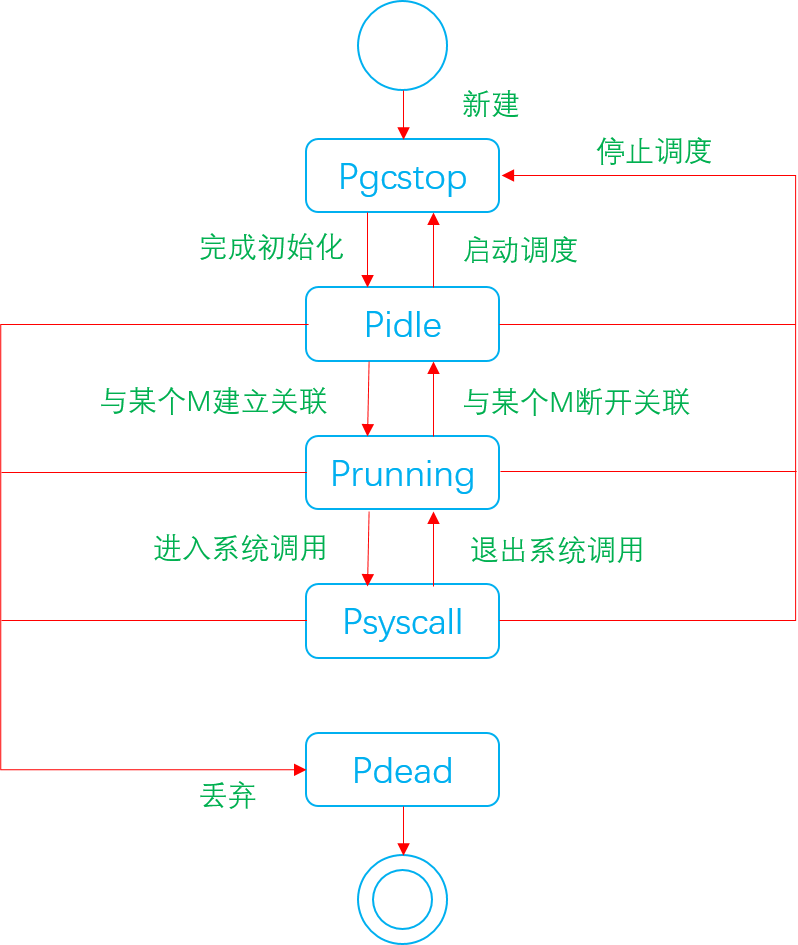

runtime.p 结构体中的状态 status 字段会是以下五种中的一种:

| 状态 |

描述 |

| _Pidle |

处理器没有运行用户代码或者调度器,被空闲队列或者改变其状态的结构持有,运行队列为空 |

| _Prunning |

被线程 M 持有,并且正在执行用户代码或者调度器 |

| _Psyscall |

没有执行用户代码,当前线程陷入系统调用 |

| _Pgcstop |

被线程 M 持有,当前处理器由于垃圾回收被停止 |

| _Pdead |

当前处理器已经不被使用 |

通过分析处理器 P 的状态,我们能够对处理器的工作过程有一些简单理解,例如处理器在执行用户代码时会处于 _Prunning 状态,在当前线程执行 I/O 操作时会陷入_Psyscall 状态。

P在创建之初的状态是Pgcstop,但这并不意味着运行时系统要进行垃圾回收。P出于这一状态的时间会非常短暂,在紧接着的初始化后,运行时系统会将其状态设置为Pidle并放入调度器的空闲P列表。

非Pdead状态的P在运行时系统停止调度时都会被置于Pgcstop状态。重启调度时(如垃圾回收结束后),所有P都会被置于Pidle状态,而不是他们原来的状态。

非Pgcstop状态的P都会因最大P数量的减小而被认为是多余的,并被置于Pdead状态。当P进入Pdead状态之前,该P的可运行G队列会被转移到调度器的可运行G队列,它的自由G列表会被转移到调度器的自由G列表。

每个P中有一个可运行的G队列,以及一个自由G列表。自由G列表中包含了已运行完成的G。随着已运行完成的G越来越多,该列表会不断增长。如果它增长到一定程度,运行时系统会把其中部分G转移到调度器的自由G列表。同样,当调度器发现其中的自由G太少时,会预先尝试从调度器的自由G列表中转移一些G过来。

当使用go语句启用一个G时,运行时系统会先从相应P的自由G列表中获取一个G来封装这个go语句的函数。仅当获取不到的时候,也就是调度器的自由G列表也空了,才会创建一个新的G。

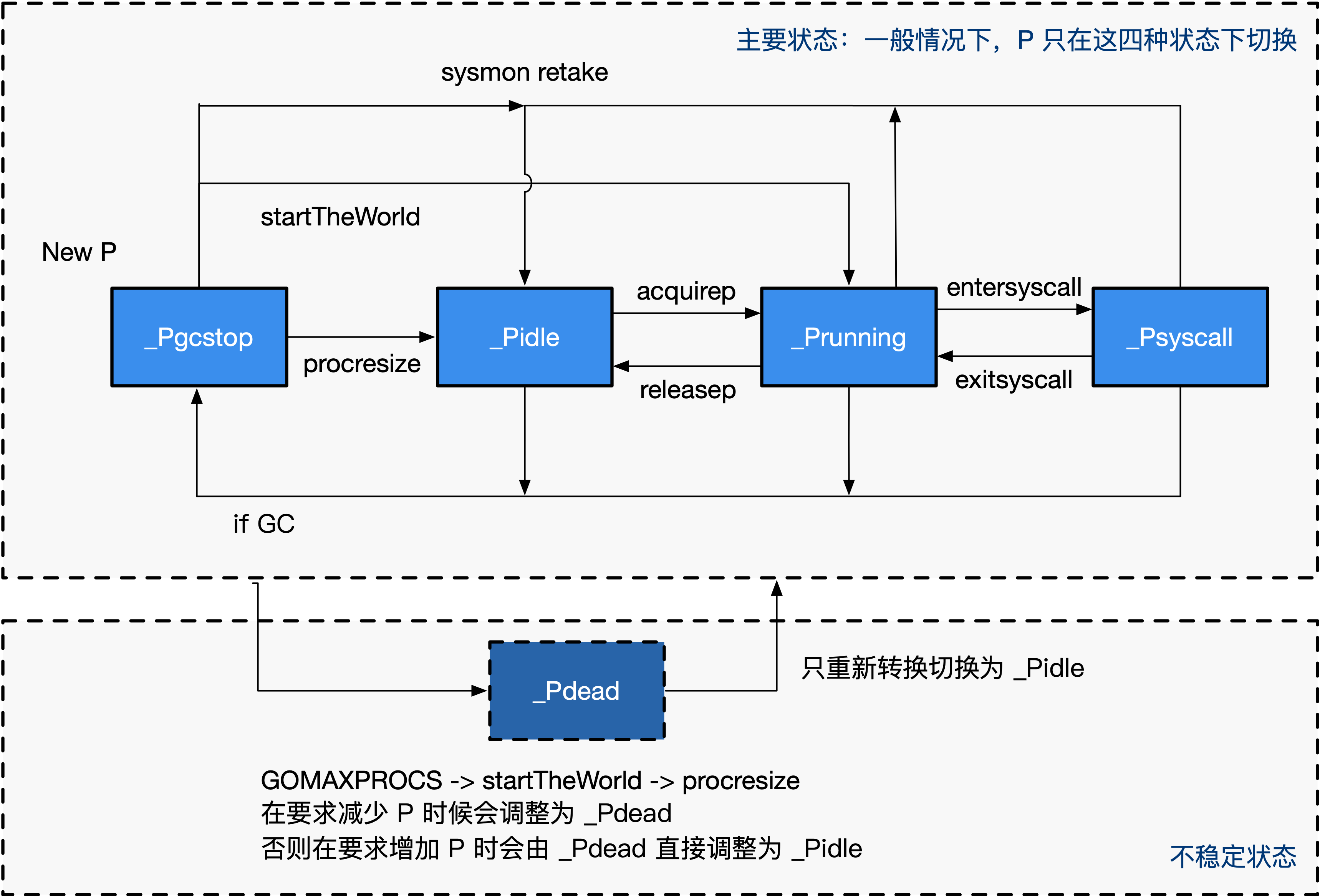

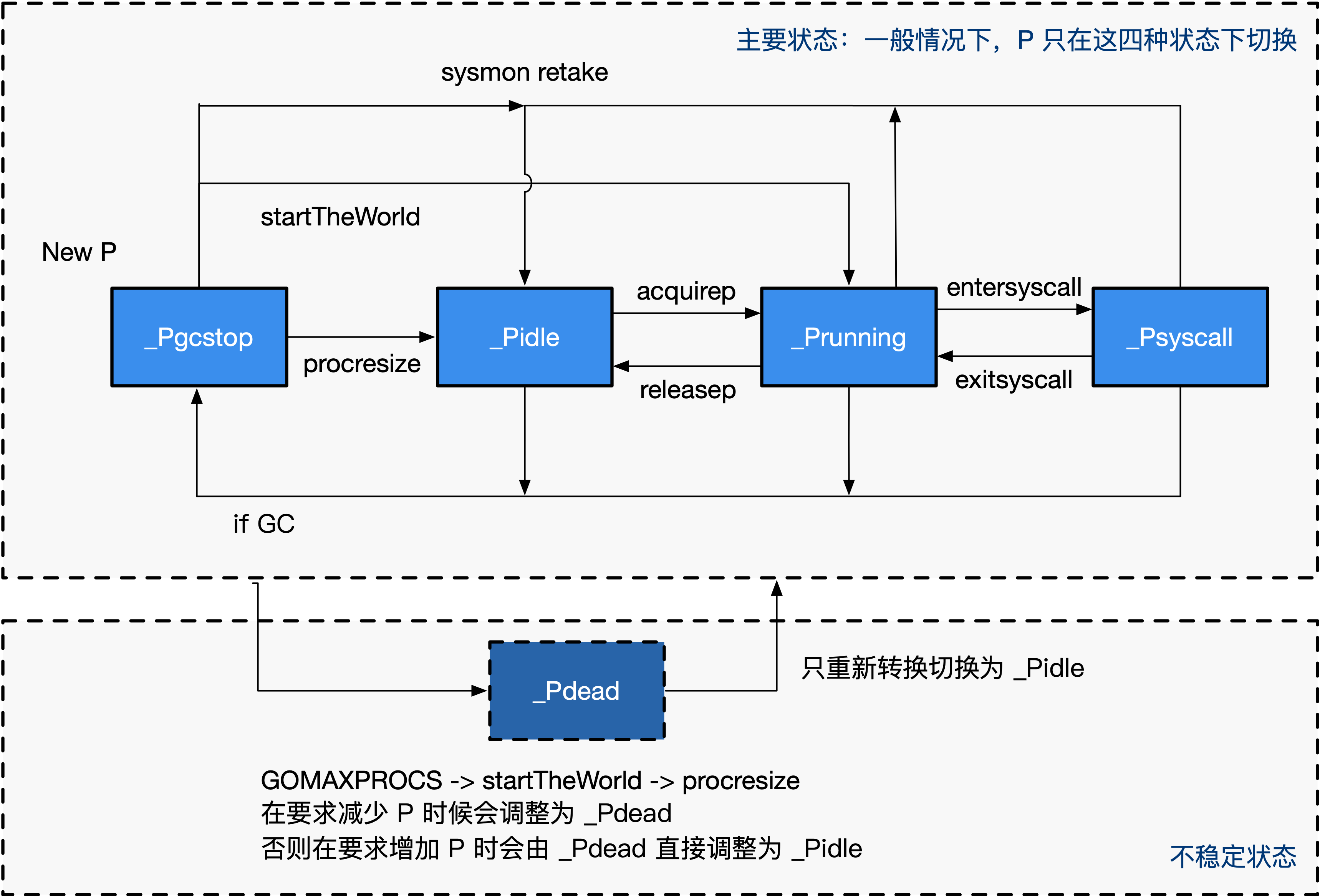

P 的状态流转:

通常情况下(在程序运行时不调整 P 的个数),P 只会在上图中的四种状态下进行切换。 当程序刚开始运行进行初始化时,所有的 P 都处于 _Pgcstop 状态, 随着 P 的初始化(runtime.procresize),会被置于_Pidle。

当 M 需要运行时,会 runtime.acquirep 来使 P 变成 Prunning 状态,并通过 runtime.releasep 来释放。

当 G 执行时需要进入系统调用,P 会被设置为 _Psyscall, 如果这个时候被系统监控抢夺(runtime.retake),则 P 会被重新修改为_Pidle。

如果在程序运行中发生 GC,则 P 会被设置为 _Pgcstop, 并在 runtime.startTheWorld 时重新调整为_Pidle 或者 _Prunning。

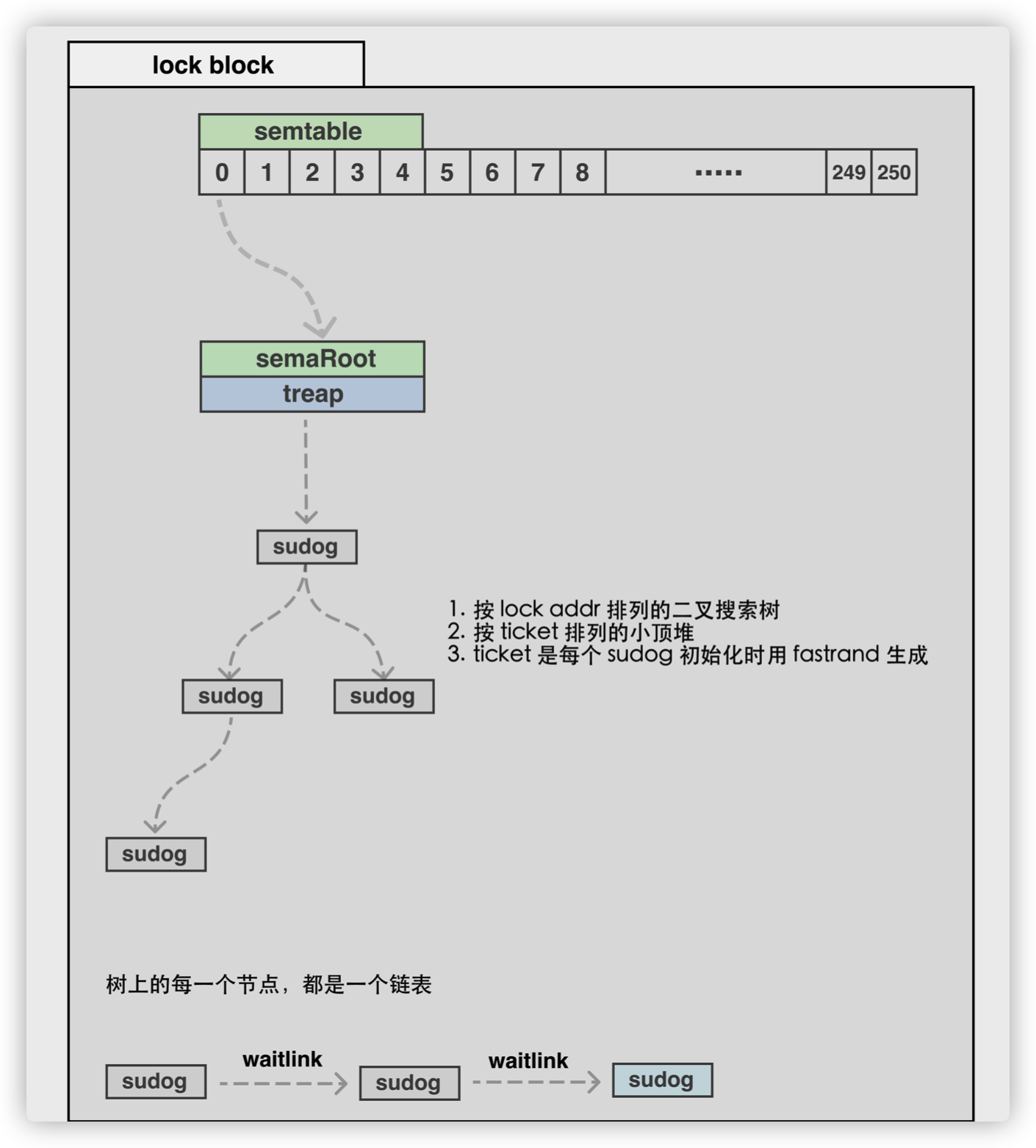

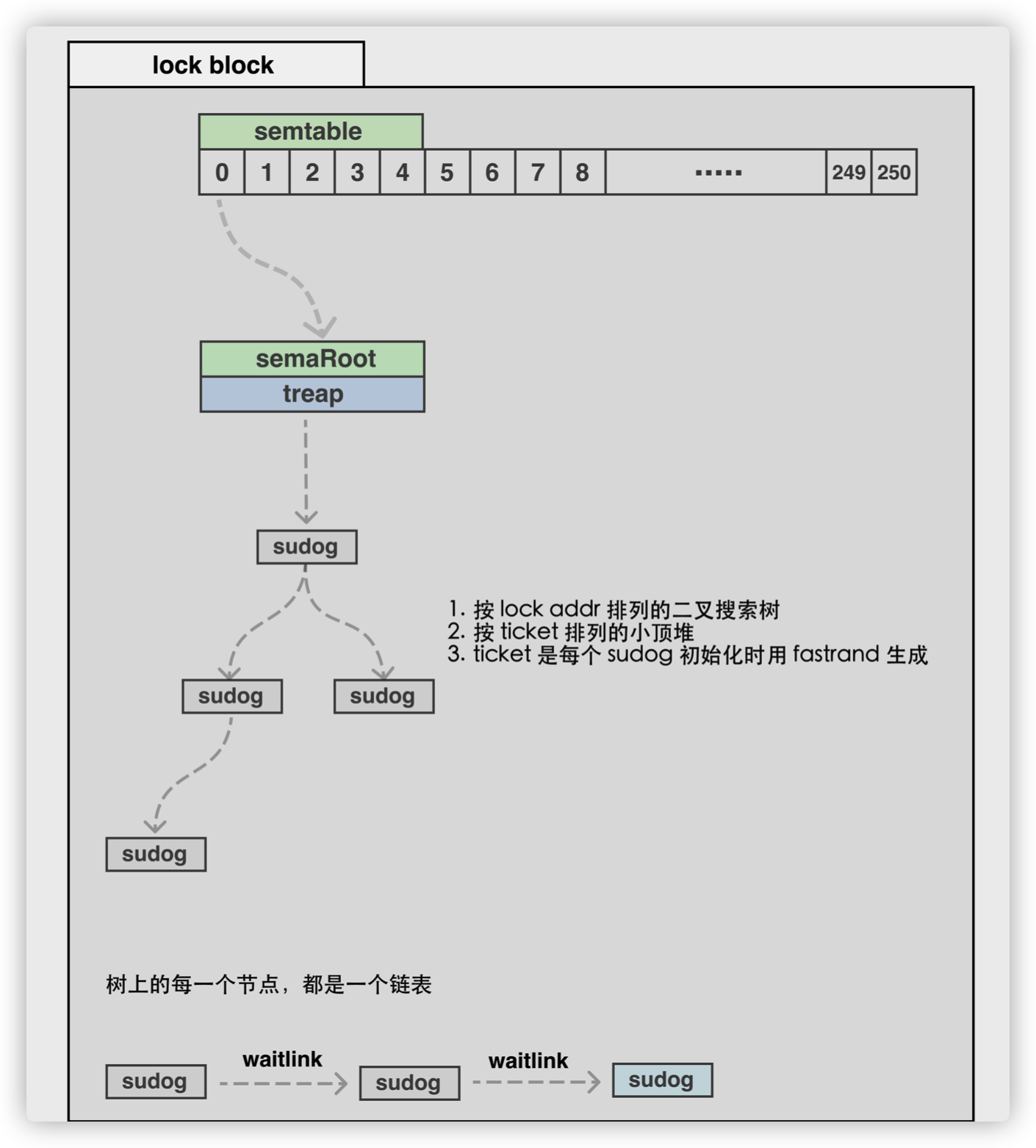

schedt

调度器,所有 Goroutine 被调度的核心,存放了调度器持有的全局资源,访问这些资源需要持有锁:

- 管理了能够将 G 和 M 进行绑定的 M 队列

- 管理了空闲的 P 链表(队列)

- 管理了 G 的全局队列

- 管理了可被复用的 G 的全局缓存

调度器的数据结构是一个结构体,但是不能单纯的说调度器就是一个结构体。结构体只是为了辅助调度,真正的调度行为还的靠调度函数来完成。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

|

type schedt struct {

// accessed atomically. keep at top to ensure alignment on 32-bit systems.

// 需以原子访问访问。

// 保持在 struct 顶部,以使其在 32 位系统上可以对齐

goidgen uint64

lastpoll uint64

lock mutex

// When increasing nmidle, nmidlelocked, nmsys, or nmfreed, be

// sure to call checkdead().

//闲置M链表 由空闲的工作线程组成的链表

midle muintptr // idle m's waiting for work

//闲置的M数量 空闲的工作线程数量

nmidle int32 // number of idle m's waiting for work

//因锁定而停止的M的数量 空闲的且被 lock 的 m 计数

nmidlelocked int32 // number of locked m's waiting for work

//已创建的M的数量,也是下一个M的ID号

mnext int64 // number of m's that have been created and next M ID

// 表示最多所能创建的工作线程数量

maxmcount int32 // maximum number of m's allowed (or die) //M最大闲置数

//执行系统监测任务的M的数量

nmsys int32 // number of system m's not counted for deadlock

//已被释放的M的数量

nmfreed int64 // cumulative number of freed m's

// goroutine 的数量,自动更新

ngsys uint32 // number of system goroutines; updated atomically

// 由空闲的 p 结构体对象组成的链表

pidle puintptr // idle p's

// 空闲的 p 结构体对象的数量

npidle uint32

// 自旋状态的 M 的数量

nmspinning uint32 // See "Worker thread parking/unparking" comment in proc.go.

// Global runnable queue.

// 全局 runnable G 队列

runq gQueue

// 元素数量

runqsize int32

// disable controls selective disabling of the scheduler.

//

// Use schedEnableUser to control this.

//

// disable is protected by sched.lock.

disable struct {

// user disables scheduling of user goroutines.

user bool

runnable gQueue // pending runnable Gs

n int32 // length of runnable

}

// Global cache of dead G's.

// dead G 的全局缓存

// 已退出的 goroutine 对象,缓存下来

// 避免每次创建 goroutine 时都重新分配内存

gFree struct {

lock mutex

// 包含栈的 Gs

stack gList // Gs with stacks

// 没有栈的 Gs

noStack gList // Gs without stacks

// 空闲 g 的数量

n int32

}

// Central cache of sudog structs.

// sudog 结构的集中缓存

sudoglock mutex

sudogcache *sudog

// Central pool of available defer structs of different sizes.

// 不同大小的可用的 defer struct 的集中缓存池

deferlock mutex

deferpool [5]*_defer

// freem is the list of m's waiting to be freed when their

// m.exited is set. Linked through m.freelink.

freem *m

gcwaiting uint32 // gc is waiting to run //是否需要因一些任务而停止调度

stopwait int32//需要停止但仍未停止的P的数量

stopnote note//实现与stopwait相关的事件通知机制

sysmonwait uint32//停止调度期间,系统监控任务是否在等待

sysmonnote note//实现与sysmonwait相关的事件通知机制

// safepointFn should be called on each P at the next GC

// safepoint if p.runSafePointFn is set.

safePointFn func(*p)

safePointWait int32

safePointNote note

profilehz int32 // cpu profiling rate

// 上次修改 gomaxprocs 的纳秒时间

procresizetime int64 // nanotime() of last change to gomaxprocs

totaltime int64 // ∫gomaxprocs dt up to procresizetime

}

|

在程序运行过程中,schedt 对象只有一份实体,它维护了调度器的所有信息。

在go运行时系统中,一些任务执行前需要停止调度。例如垃圾回收任务中的某些子任务,发起运行时恐慌的任务。下面我们将这类任务统称为串行运行时任务。上面的字段都是和串行运行时任务相关的。并且它们也是并发安全的。

暂停调度任务:主要与gcwaiting、stopwait、stopnote字段有关。

- gcwaiting字段表示是否需要停止调度。在停止调度前,该值被设置为1;恢复调度前,该值被设置为0。

- 一些调度任务在执行时,一旦发现gcwaiting的值为1,就会把当前P的状态设置为Pgcstop,然后自减stopwait字段的值。

- 当自减后发现stopwait的值为0,说明所有P都进入了Pgcstop状态。然后就利用stopnote字段唤醒因等待调度停止而暂停的串行运行时任务。

暂停系统检测任务:主要与sysmonwait和sysmonnote字段相关。

- 串行运行时任务执行前,系统检测任务也要暂停。

- sysmonwait字段表示是否已暂停。0表示未暂停,1表示已暂停。

- 系统监测任务是一直执行的,它处于无限循环中。在每个循环的开始,系统监测程序都会检查调度情况。

- 一旦发现调度停止(gcwaiting的值不为0或所有P都已闲置),就会把sysmonwait字段的值设置为1,并利用sysmonnote字段暂停自身。

- 恢复调度之前,调度器若发现sysmonwait的值不为0,就把它置为0,并利用sysmonnote字段恢复系统监测任务的执行。

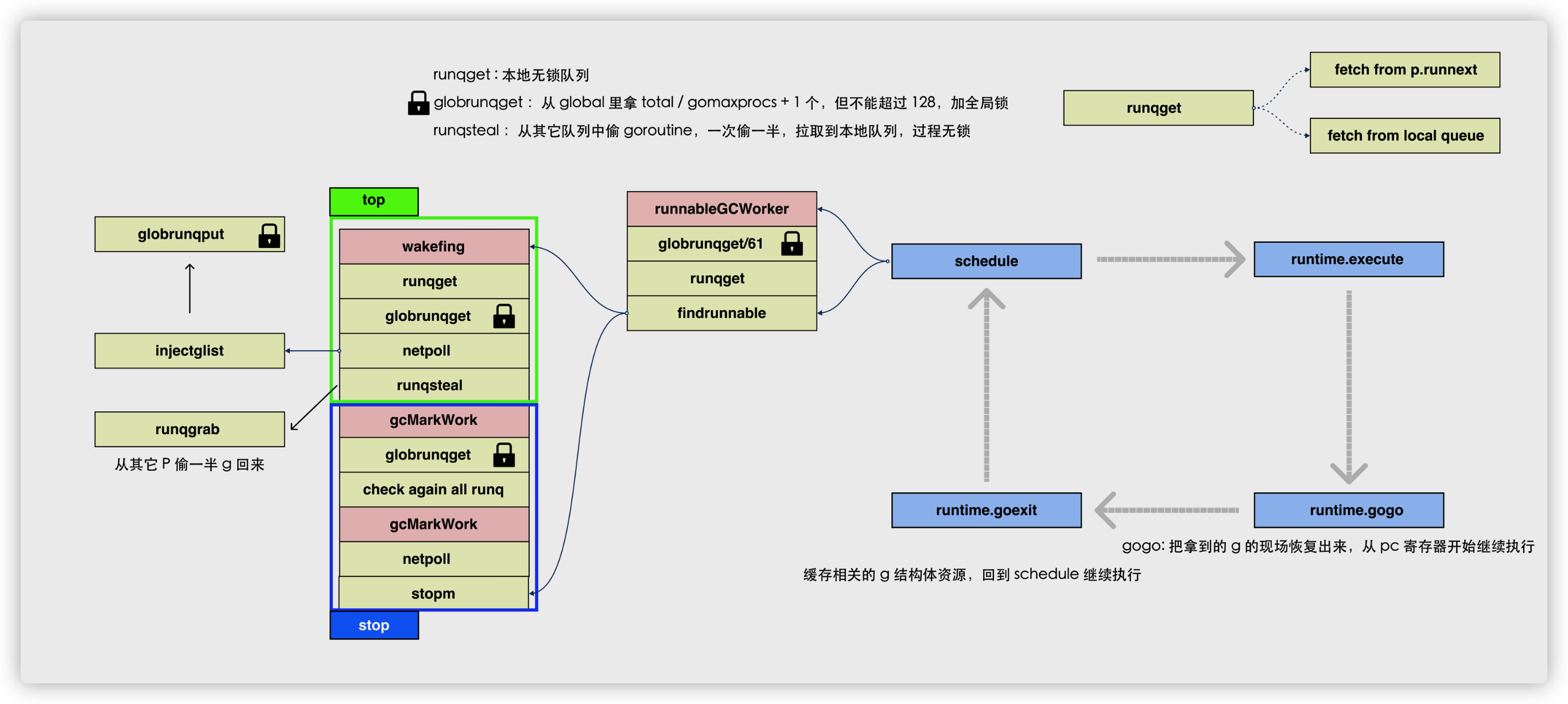

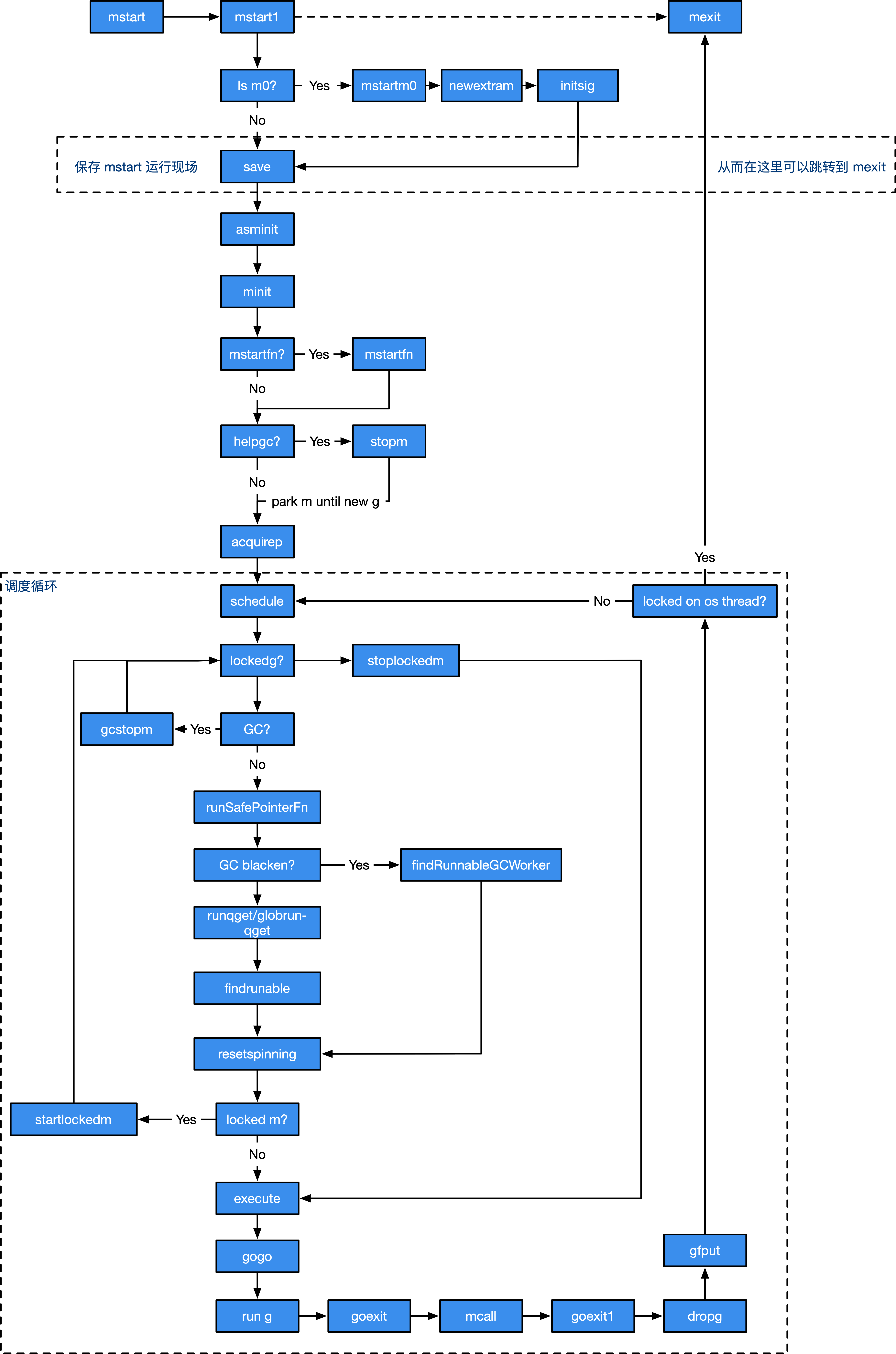

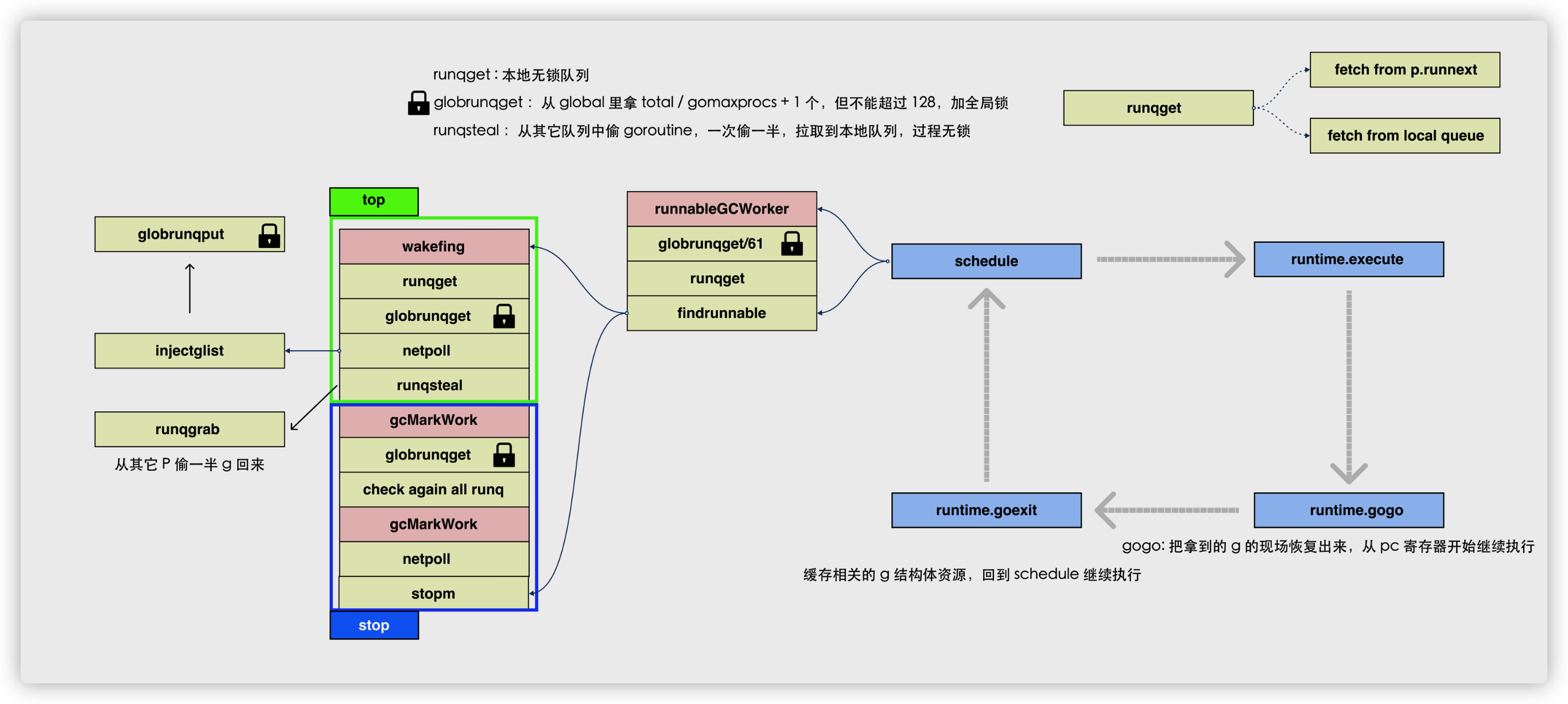

调度循环流程

当我们每次写下:

1

2

3

|

go func(){

println("hello world)

}()

|

的时候,到底发生了什么?其实是向runtime提交了一个计算任务.func(){xxxxx}里包裹的代码就是这个计算任务的内容.

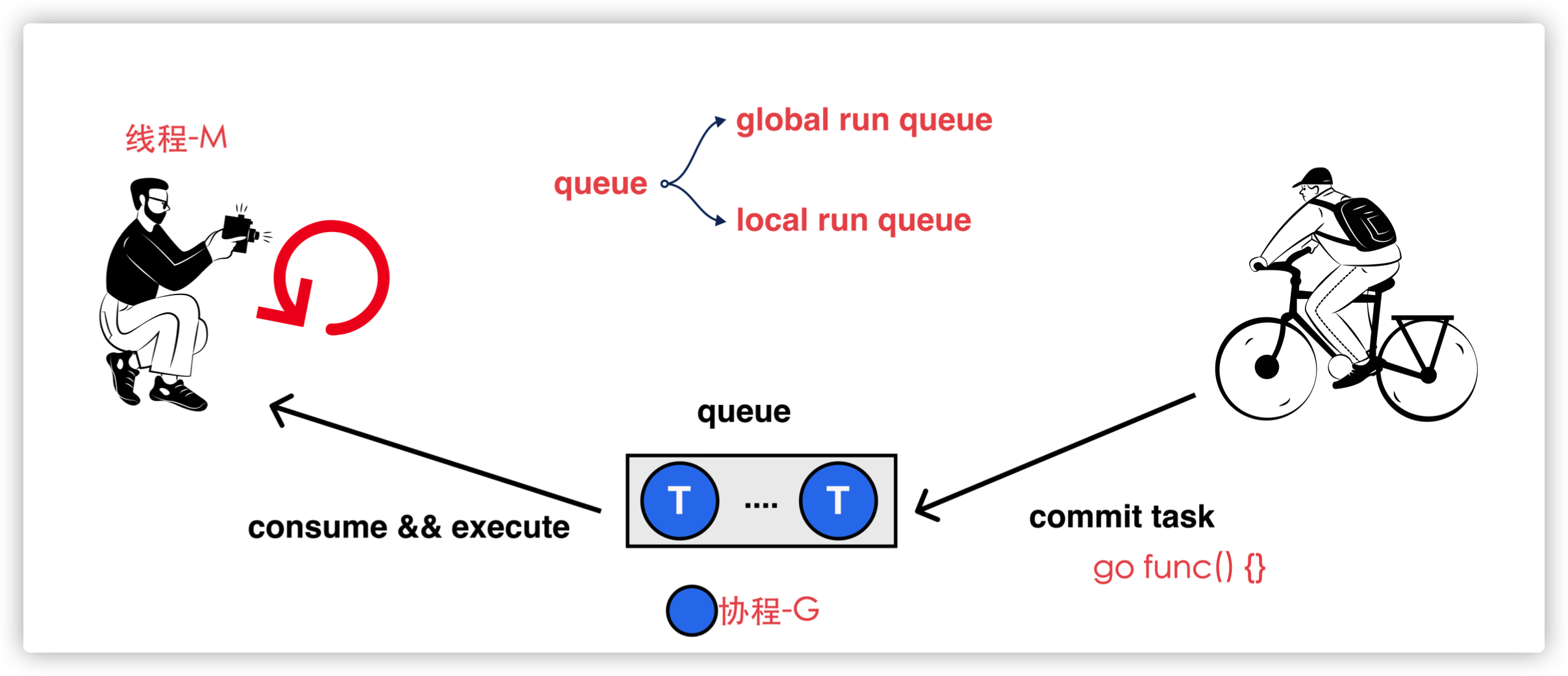

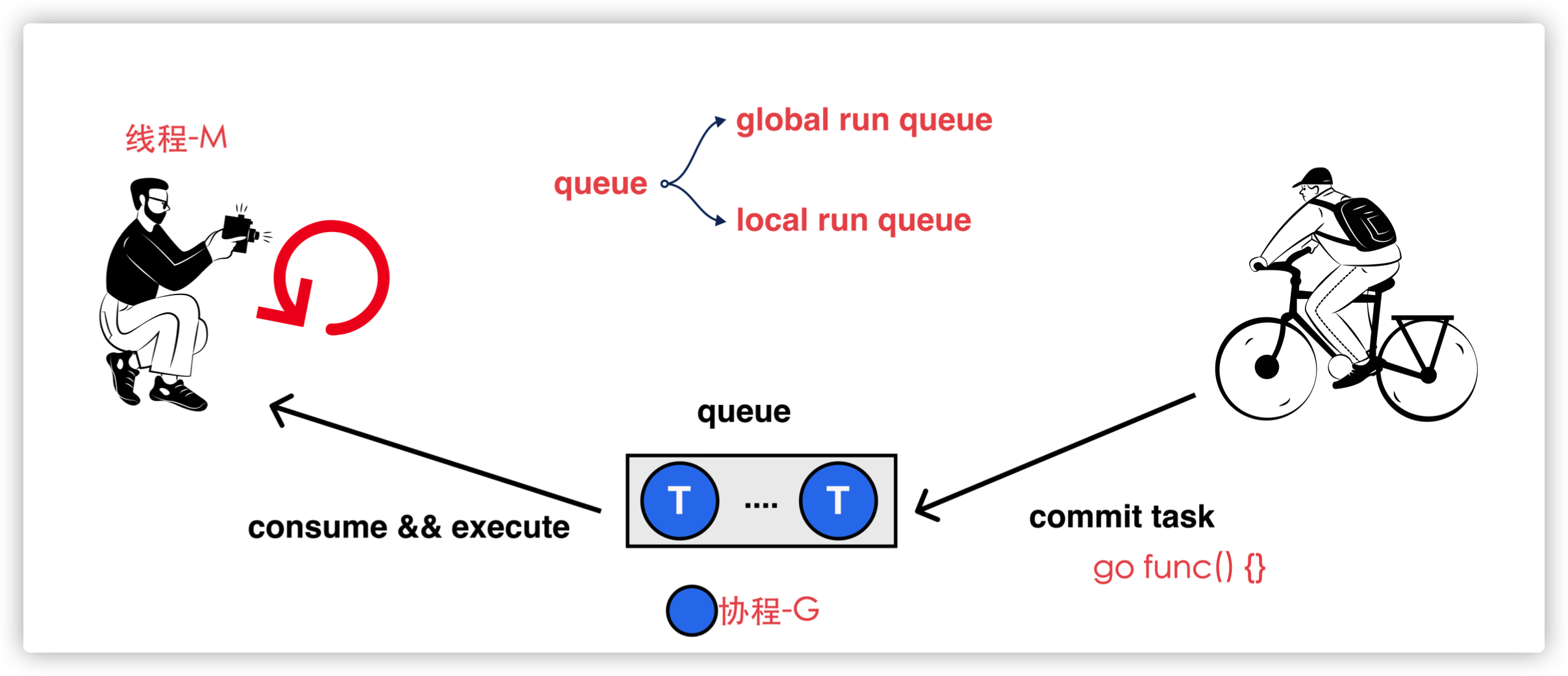

Go 的调度流程本质上是一个生产-消费流程

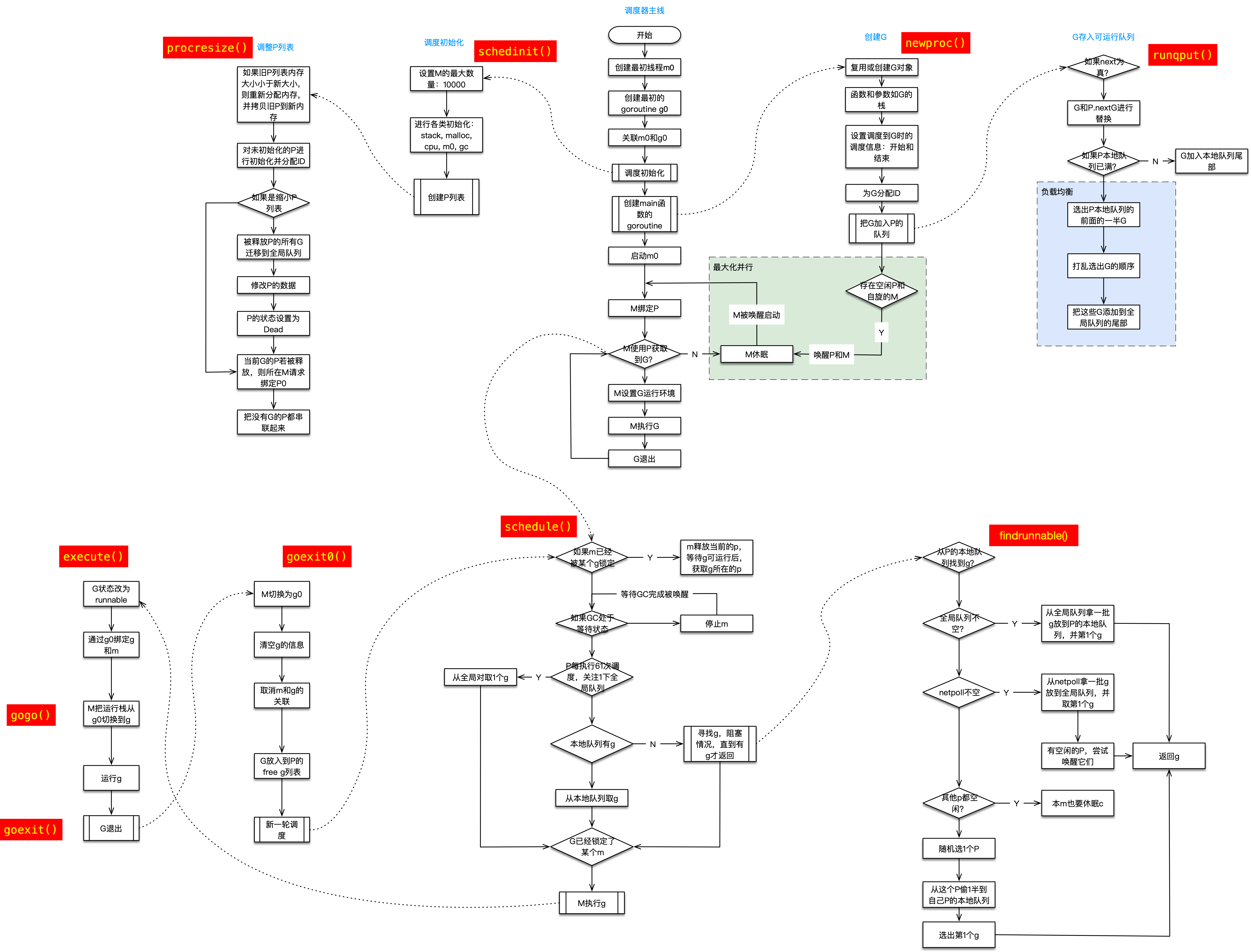

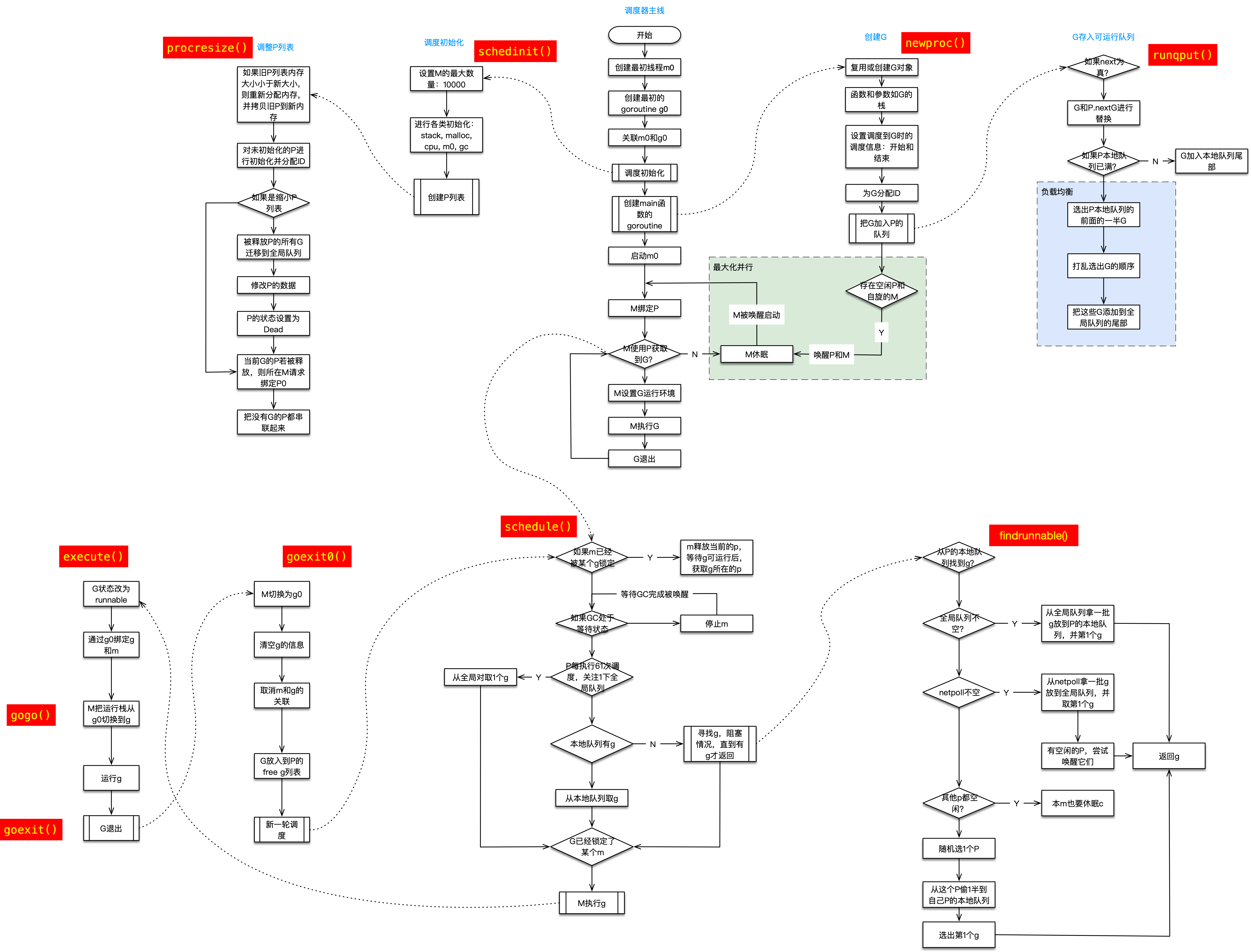

G-P-M调度模型如下:

goroutine 的生产端:

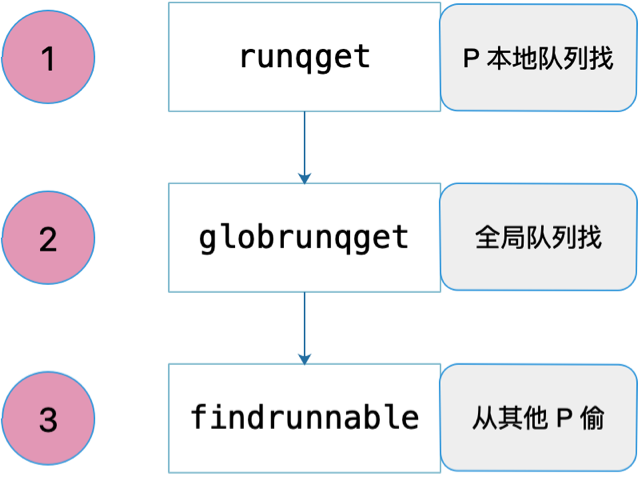

goroutine 的消费端:

M 执行调度循环时, 必须与一个 P 绑定.

Work stealing 就是说的 runqsteal -> runqgrab 这个流程

考虑如下代码输出:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

package main

import (

"fmt"

"runtime"

"time"

)

func main() {

runtime.GOMAXPROCS(1)

for i := 0; i < 10; i++ {

i := i

go func() {

fmt.Println(i)

}()

}

time.Sleep(time.Hour)

}

|

1

2

3

4

5

6

7

8

9

10

|

9

0

1

2

3

4

5

6

7

8

|

考虑下面代码:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

package main

func main() {

i := 1

go func() {

// 这个goroutine会导致进程在gc时hang 死

// GC时需要停止所有goroutine.而老版本的Go的g停止需要主动让出

// 1.14增加基于信号的抢占之后,该问题被解决

for {

i++

}

}()

}

|

下面流程图,画出了主要的调度流程,现在我们根据流程图分析相关源码

调度器初始化

schedinit

运行时通过 runtime.schedinit 函数初始化调度器:

在调度器初始函数执行的过程中会将 maxmcount 设置成 10000,这也就是一个 Go 语言程序能够创建的最大线程数,虽然最多可以创建 10000 个线程,但是可以同时运行的线程还是由 GOMAXPROCS 变量控制。

同时runtime/debug包的SetMaxThreads函数可以用来修改这一限制。该函数会返回旧的M数量的最大值。需要注意的是,如果你给定的新值比当时已有的M的数量小,运行时系统会立即引发一个运行时恐慌。所以调用这个函数一定要慎重,而且如果真的有必要,那么越早调用越好。因为调整的过程中会损耗部分性能。

我们从环境变量 GOMAXPROCS 获取了程序能够同时运行的最大处理器数之后就会调用 runtime.procresize 更新程序中处理器的数量,在这时整个程序不会执行任何用户 Goroutine,调度器也会进入锁定状态.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

|

// The bootstrap sequence is:

//

// call osinit 初始化系统核心数。

// call schedinit 初始化调度器。

// make & queue new G 创建新的 goroutine。

// call runtime·mstart 调用 mstart,启动调度。

//

// The new G calls runtime·main. 在新的 goroutine 上运行 runtime.main 函数。

func schedinit() {

// raceinit must be the first call to race detector.

// In particular, it must be done before mallocinit below calls racemapshadow.

// getg 由编译器实现

// get_tls(CX)

// MOVQ g(CX), BX; BX存器里面现在放的是当前g结构体对象的地址

_g_ := getg()

if raceenabled {

_g_.racectx, raceprocctx0 = raceinit()

}

//设置最大M数量

sched.maxmcount = 10000

tracebackinit()

moduledataverify()

//初始化栈空间复用管理链表

stackinit()

mallocinit()

// 初始化 m0

mcommoninit(_g_.m)

cpuinit() // must run before alginit

alginit() // maps must not be used before this call

modulesinit() // provides activeModules

typelinksinit() // uses maps, activeModules

itabsinit() // uses activeModules

msigsave(_g_.m)

initSigmask = _g_.m.sigmask

goargs()

goenvs()

parsedebugvars()

gcinit()

sched.lastpoll = uint64(nanotime())

// 初始化 P 的个数

// 系统中有多少核,就创建和初始化多少个 p 结构体对象

procs := ncpu

if n, ok := atoi32(gogetenv("GOMAXPROCS")); ok && n > 0 {

procs = n

}

//调整P数量

//注意:此刻所有P都是新建的,所以不可能返回有本地任务的P

if procresize(procs) != nil {

throw("unknown runnable goroutine during bootstrap")

}

// For cgocheck > 1, we turn on the write barrier at all times

// and check all pointer writes. We can't do this until after

// procresize because the write barrier needs a P.

if debug.cgocheck > 1 {

writeBarrier.cgo = true

writeBarrier.enabled = true

for _, p := range allp {

p.wbBuf.reset()

}

}

if buildVersion == "" {

// Condition should never trigger. This code just serves

// to ensure runtime·buildVersion is kept in the resulting binary.

buildVersion = "unknown"

}

}

|

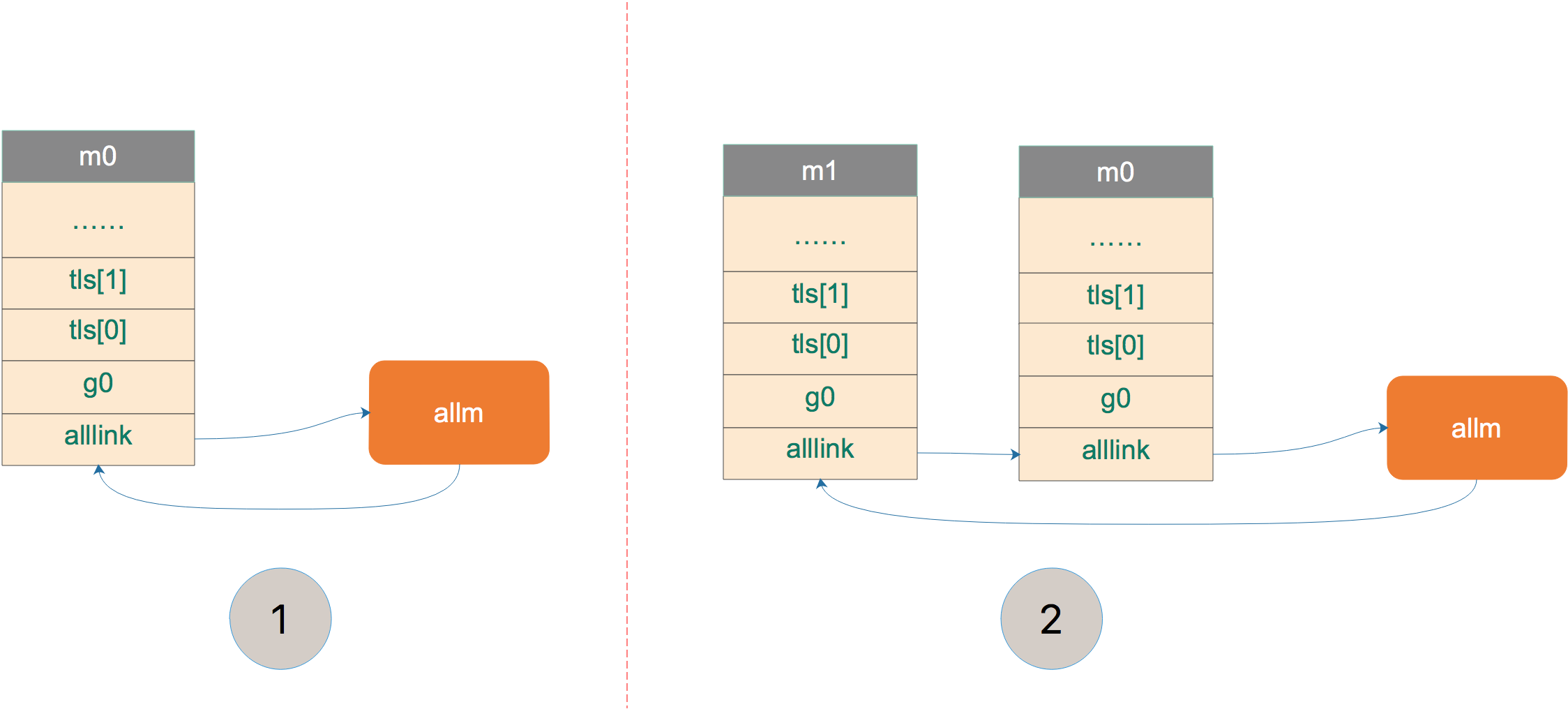

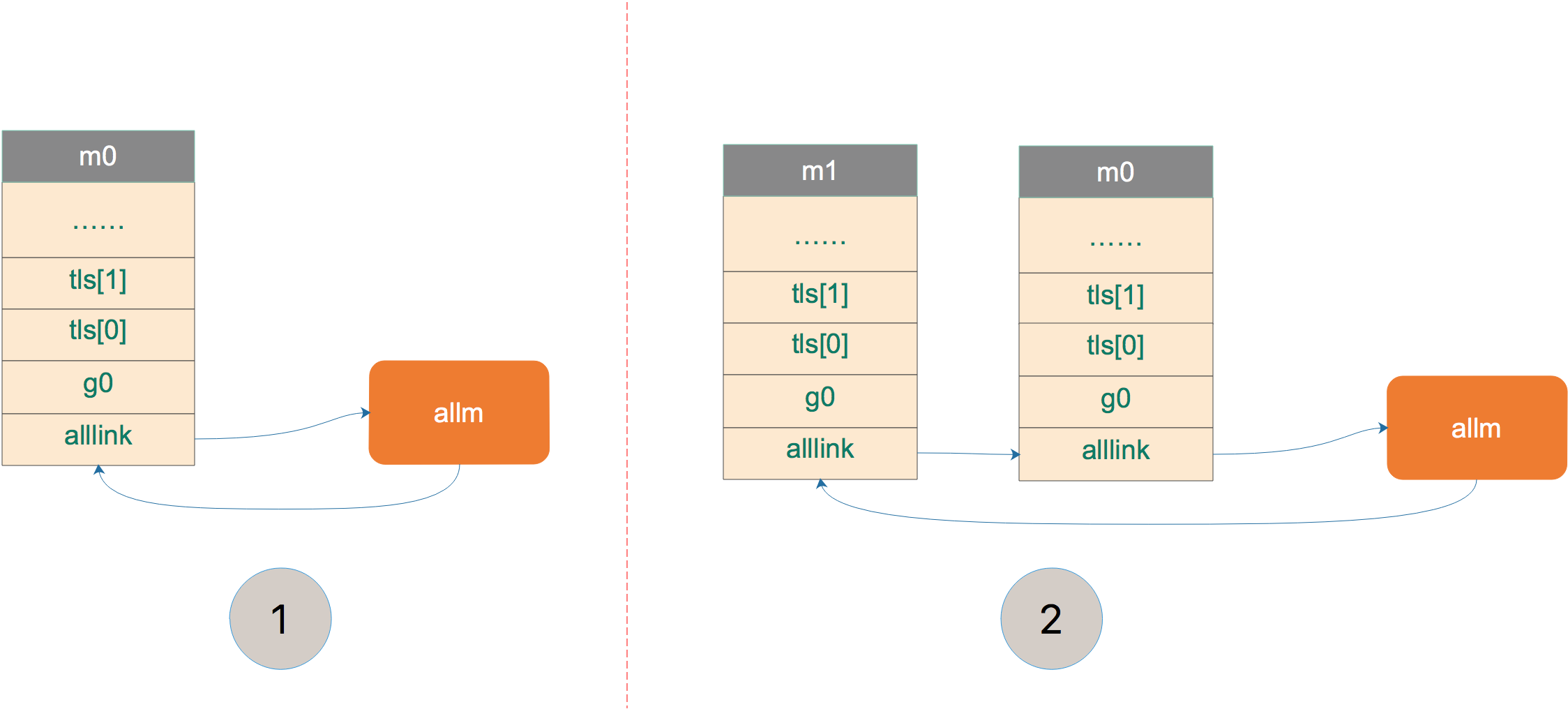

mcommoninit函数初始化m0.

上图中,将 m0 挂在 allm 上。之后,若新创建 m,则 m1 会和 m0 相连。

M 其实就是 OS 线程,它只有两个状态:自旋、非自旋。 在调度器初始化阶段,只有一个 M,那就是主 OS 线程,因此这里的 commoninit 仅仅只是对 M 进行一个初步的初始化, 该初始化包含对 M 及用于处理 M 信号的 G 的相关运算操作,未涉及工作线程的暂止和复始。

getg

函数首先调用 getg() 函数获取当前正在运行的 g,getg() 在 src/runtime/stubs.go 中声明,真正的代码由编译器生成。

1

2

3

4

|

// getg returns the pointer to the current g.

// The compiler rewrites calls to this function into instructions

// that fetch the g directly (from TLS or from the dedicated register).

func getg() *g

|

getg 返回当前正在运行的 goroutine 的指针,它会从 tls 里取出 tls[0],也就是当前运行的 goroutine 的地址。编译器插入类似下面的代码:

1

2

|

get_tls(CX)

MOVQ g(CX), BX; // BX存器里面现在放的是当前g结构体对象的地址

|

调整P列表

procresize

默认只有schedinit和startTheWorldWithSema会调用procresize函数.

- 在schedinit阶段,所有P对象都是新建的.除分配给当前主线程的外,其他都被放入空闲链表.

- 而startTheWorldWithSema会激活全部有本地任务的P对象

runtime.procresize 的执行过程如下:

- 调用时已经 STW,记录调整 P 的时间;

- 如果全局变量 allp 切片中的处理器数量少于期望数量,就会对切片进行扩容;

- 使用 new 创建新的处理器结构体并调用 runtime.p.init 方法初始化刚刚扩容的处理器;

- 如果当前的 P 还可以继续使用(没有被移除),则将 P 设置为 _Prunning;

- 否则将第一个 P 抢过来给当前 G 的 M 进行绑定,通过指针将线程 m0 和处理器 allp[0] 绑定到一起;

- 调用 runtime.p.destroy 方法释放不再使用的处理器结构;

- 通过截断改变全局变量 allp 的长度保证与期望处理器数量相等;

- 将除 allp[0] 之外的处理器 P 全部设置成 _Pidle 并加入到全局的空闲队列中;

调用 runtime.procresize 就是调度器启动的最后一步,在这一步过后调度器会完成相应数量处理器的启动,等待用户创建运行新的 Goroutine 并为 Goroutine 调度处理器资源。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

|

// Change number of processors. The world is stopped, sched is locked.

// gcworkbufs are not being modified by either the GC or

// the write barrier code.

// Returns list of Ps with local work, they need to be scheduled by the caller.

func procresize(nprocs int32) *p {

//p的数量

old := gomaxprocs

//首先再检查一遍新值和旧值,如果不合法就引发一个运行时恐慌,并终止该流程。

if old < 0 || nprocs <= 0 {

throw("procresize: invalid arg")

}

if trace.enabled {

traceGomaxprocs(nprocs)

}

// update statistics

// 更新统计信息,记录此次修改 gomaxprocs 的时间

now := nanotime()

if sched.procresizetime != 0 {

sched.totaltime += int64(old) * (now - sched.procresizetime)

}

sched.procresizetime = now

// Grow allp if necessary.

//如果allp的长度不够,allp上锁,调整allp的长度,去余补缺即可

//如果新值比全局P列表的长度大,则增长全局P列表切片(allp)。如果容量够就扩容,如果容量不够就新建一个新的切片,并把全局P列表中的P都拷贝到新切片中。

// 必要时增加 allp

// 这个时候本质上是在检查用户代码是否有调用过 runtime.MAXGOPROCS 调整 p 的数量

// 此处多一步检查是为了避免内部的锁,如果 nprocs 明显小于 allp 的可见数量(因为 len)

// 则不需要进行加锁

if nprocs > int32(len(allp)) {

// Synchronize with retake, which could be running

// concurrently since it doesn't run on a P.

// 此处与 retake 同步,它可以同时运行,因为它不会在 P 上运行。

lock(&allpLock)

if nprocs <= int32(cap(allp)) {

// 如果 nprocs 被调小了,扔掉多余的 p

allp = allp[:nprocs]

} else {

// 否则(调大了)创建更多的 p

nallp := make([]*p, nprocs)

// Copy everything up to allp's cap so we

// never lose old allocated Ps.

// 将原有的 p 复制到新创建的 new all p 中,不浪费旧的 p

copy(nallp, allp[:cap(allp)])

allp = nallp

}

unlock(&allpLock)

}

// initialize new P's

// 初始化新的 P

for i := old; i < nprocs; i++ {

pp := allp[i]

//申请新P对象

// 如果 p 是新创建的(新创建的 p 在数组中为 nil),则申请新的 P 对象

if pp == nil {

pp = new(p)

}

pp.init(i)

atomicstorep(unsafe.Pointer(&allp[i]), unsafe.Pointer(pp))

}

//经过一番清理之后,执行procresize函数的M的P也可能已经被清理掉了,所以如果侥幸这个P没有被清理掉就把P还给当前M,如果不幸已经被清理了就把全局P列表(allp)中的第一个P给它。

// 获取当前正在运行的 g 指针,初始化时 _g_ = g0

_g_ := getg()

//如果当前正在用的P属于被释放的那拨,那就换成allp[0]

//调度器初始化阶段,根本没有P,那就绑定allp[0]

if _g_.m.p != 0 && _g_.m.p.ptr().id < nprocs {

// continue to use the current P

//继续使用当前P

_g_.m.p.ptr().status = _Prunning

_g_.m.p.ptr().mcache.prepareForSweep()

} else {

// 初始化时执行这个分支

// release the current P and acquire allp[0]

//释放当前P,因为它已经失效

if _g_.m.p != 0 {

_g_.m.p.ptr().m = 0

}

_g_.m.p = 0

_g_.m.mcache = nil

//换成allp[0]

p := allp[0]

p.m = 0

p.status = _Pidle

// 如果是调度器初始化阶段,将 p0 和 m0 关联起来

acquirep(p)

if trace.enabled {

traceGoStart()

}

}

// free unused P's

// 释放多余的 P。由于减少了旧的 procs 的数量,因此需要释放

// 假设旧值为J,程序还会对全局P列表中第I+1到第J个P(如果有的话)进行清理。

for i := nprocs; i < old; i++ {

p := allp[i]

p.destroy()

// can't free P itself because it can be referenced by an M in syscall

// 不能释放 p 本身,因为他可能在 m 进入系统调用时被引用

}

// Trim allp.

// 清理完毕后,修剪 allp, nprocs 个数之外的所有 P

if int32(len(allp)) != nprocs {

lock(&allpLock)

allp = allp[:nprocs]

unlock(&allpLock)

}

//将没有本地任务的P放到空闲链表

var runnablePs *p

//最后,程序再次遍历前I个P,也就是新的全局P列表中的所有P,但是会跳过当前执行procresize函数的M的P。

for i := nprocs - 1; i >= 0; i-- {

p := allp[i]

//确保不是当前正在用的P

// allp[0] 跟 m0 关联了,不会进行之后的“放入空闲链表”

if _g_.m.p.ptr() == p {

continue

}

// 状态转为 idle

p.status = _Pidle

//如果它的可运行G队列为空,就把它加入调度器的空闲P列表。

if runqempty(p) {

//放入空闲链表

pidleput(p)

} else {

//否则尝试拿一个M来与这个P关联,成不成功不管,然后把它放入本地的可运行P列表。

//有本地任务,构建链表

p.m.set(mget())

// 第一个循环为 nil,后续则为上一个 p

// 此处即为构建可运行的 p 链表

p.link.set(runnablePs)

runnablePs = p

}

}

//函数的最后,初始化了一个“随机分配器”,将来有些 m 去偷工作的时候,会遍历所有的 P,这时为了偷地随机一些,就会用到 stealOrder 来返回一个随机选择的 P

stealOrder.reset(uint32(nprocs))

var int32p *int32 = &gomaxprocs // make compiler check that gomaxprocs is an int32

atomic.Store((*uint32)(unsafe.Pointer(int32p)), uint32(nprocs))

//函数最后会将这个拥有可运行G的P列表作为结果返回给调用者。

//返回有本地任务的P(链表)

//负责重启调度工作的程序会检查这个列表中的P,以保证它们一定能与一个M产生关联。随后程序会让与这些P关联的M都运行起来。

return runnablePs

}

// init initializes pp, which may be a freshly allocated p or a

// previously destroyed p, and transitions it to status _Pgcstop.

func (pp *p) init(id int32) {

// p 的 id 就是它在 allp 中的索引

pp.id = id

// 新创建的 p 处于 _Pgcstop 状态

pp.status = _Pgcstop

pp.sudogcache = pp.sudogbuf[:0]

for i := range pp.deferpool {

pp.deferpool[i] = pp.deferpoolbuf[i][:0]

}

pp.wbBuf.reset()

//为P分配cache对象

if pp.mcache == nil {

// 如果 old == 0 且 i == 0 说明这是引导阶段初始化第一个 p

if id == 0 {

if mcache0 == nil {

throw("missing mcache?")

}

// Use the bootstrap mcache0. Only one P will get

// mcache0: the one with ID 0.

pp.mcache = mcache0

} else {

//创建cache

pp.mcache = allocmcache()

}

}

if raceenabled && pp.raceprocctx == 0 {

if id == 0 {

pp.raceprocctx = raceprocctx0

raceprocctx0 = 0 // bootstrap

} else {

pp.raceprocctx = raceproccreate()

}

}

lockInit(&pp.timersLock, lockRankTimers)

}

// destroy releases all of the resources associated with pp and

// transitions it to status _Pdead.

//

// sched.lock must be held and the world must be stopped.

// 释放未使用的 P,一般情况下不会执行这段代码

func (pp *p) destroy() {

// Move all runnable goroutines to the global queue

// 将本地任务转移到全局队列

// 将所有 runnable Goroutine 移动至全局队列

for pp.runqhead != pp.runqtail {

// Pop from tail of local queue

// 从本地队列中 pop

pp.runqtail--

gp := pp.runq[pp.runqtail%uint32(len(pp.runq))].ptr()

// Push onto head of global queue

//首先要把P的可运行G队列中的G放入调度器可运行G队列的头部。

globrunqputhead(gp)

}

//其次将P的runnaex字段中的G(如果有的话)放入调度器的可运行G队列的头部。

if pp.runnext != 0 {

//将gp加入调度器可运行G队列头部

globrunqputhead(pp.runnext.ptr())

pp.runnext = 0

}

if len(pp.timers) > 0 {

plocal := getg().m.p.ptr()

// The world is stopped, but we acquire timersLock to

// protect against sysmon calling timeSleepUntil.

// This is the only case where we hold the timersLock of

// more than one P, so there are no deadlock concerns.

lock(&plocal.timersLock)

lock(&pp.timersLock)

moveTimers(plocal, pp.timers)

pp.timers = nil

pp.numTimers = 0

pp.adjustTimers = 0

pp.deletedTimers = 0

atomic.Store64(&pp.timer0When, 0)

unlock(&pp.timersLock)

unlock(&plocal.timersLock)

}

// If there's a background worker, make it runnable and put

// it on the global queue so it can clean itself up.

//然后是将P持有的GC标记专用G从Gwaiting状态转到Grunnable状态并放入调度器的可运行G队列末尾。

if gp := pp.gcBgMarkWorker.ptr(); gp != nil {

casgstatus(gp, _Gwaiting, _Grunnable)

if trace.enabled {

traceGoUnpark(gp, 0)

}

//将gp加入调度器可运行G队列尾部

globrunqput(gp)

// This assignment doesn't race because the

// world is stopped.

pp.gcBgMarkWorker.set(nil)

}

// Flush p's write barrier buffer.

if gcphase != _GCoff {

wbBufFlush1(pp)

pp.gcw.dispose()

}

for i := range pp.sudogbuf {

pp.sudogbuf[i] = nil

}

pp.sudogcache = pp.sudogbuf[:0]

for i := range pp.deferpool {

for j := range pp.deferpoolbuf[i] {

pp.deferpoolbuf[i][j] = nil

}

pp.deferpool[i] = pp.deferpoolbuf[i][:0]

}

systemstack(func() {

for i := 0; i < pp.mspancache.len; i++ {

// Safe to call since the world is stopped.

mheap_.spanalloc.free(unsafe.Pointer(pp.mspancache.buf[i]))

}

pp.mspancache.len = 0

pp.pcache.flush(&mheap_.pages)

})

//释放当前P绑定的cache

freemcache(pp.mcache)

pp.mcache = nil

//将当前P的G复用链转移到全局

//还需要调用gfpurge函数将P的自由G列表的所有G都转移到调度器的自由G列表中。

//将P的自由G列表的所有G都转移到调度器的自由G列表

gfpurge(pp)

traceProcFree(pp)

if raceenabled {

if pp.timerRaceCtx != 0 {

// The race detector code uses a callback to fetch

// the proc context, so arrange for that callback

// to see the right thing.

// This hack only works because we are the only

// thread running.

mp := getg().m

phold := mp.p.ptr()

mp.p.set(pp)

racectxend(pp.timerRaceCtx)

pp.timerRaceCtx = 0

mp.p.set(phold)

}

raceprocdestroy(pp.raceprocctx)

pp.raceprocctx = 0

}

pp.gcAssistTime = 0

//最后将P设置为Pdead状态,以便之后进行销毁。之所以不能在这里立即销毁,是因为它们可能被正在进行系统调用的M引用,如果现在就销毁,就会在那些M完成系统调用时造成错误。

pp.status = _Pdead

}

|

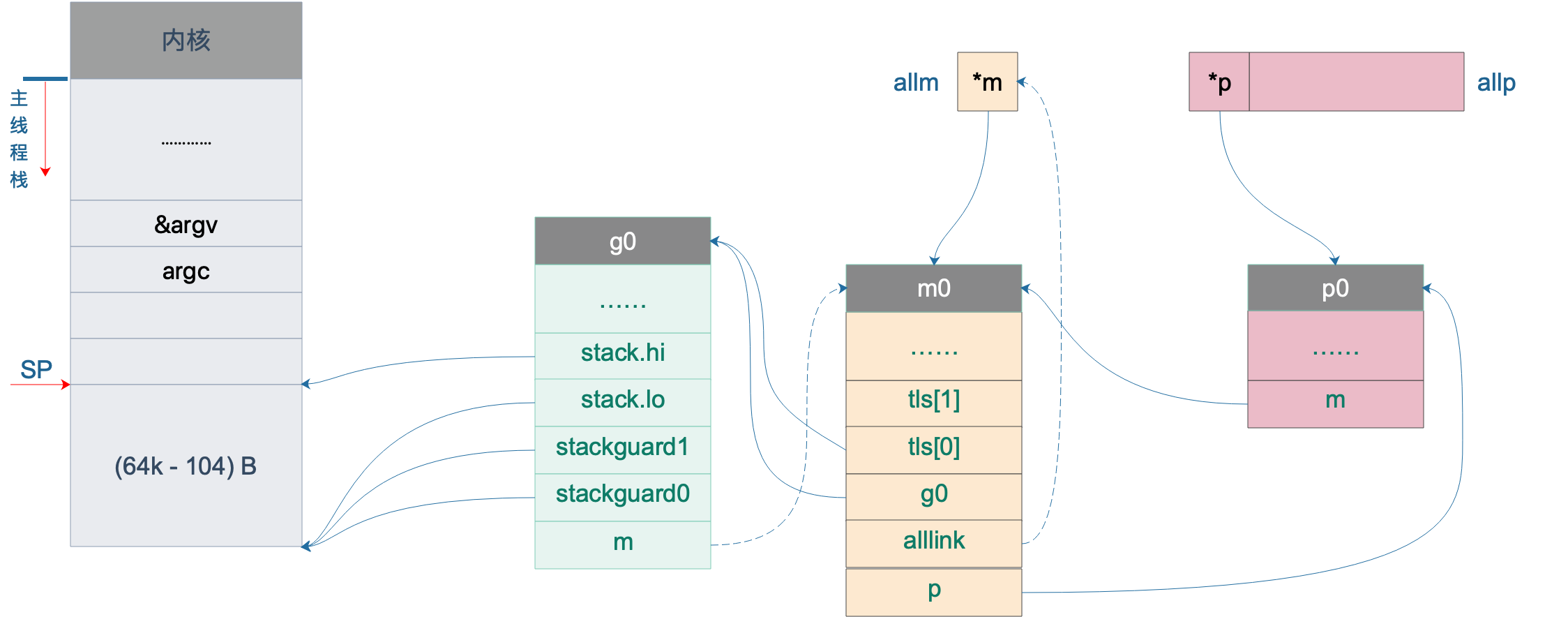

这样,整个 procresize 函数就讲完了,这也意味着,调度器的初始化工作已经完成了。

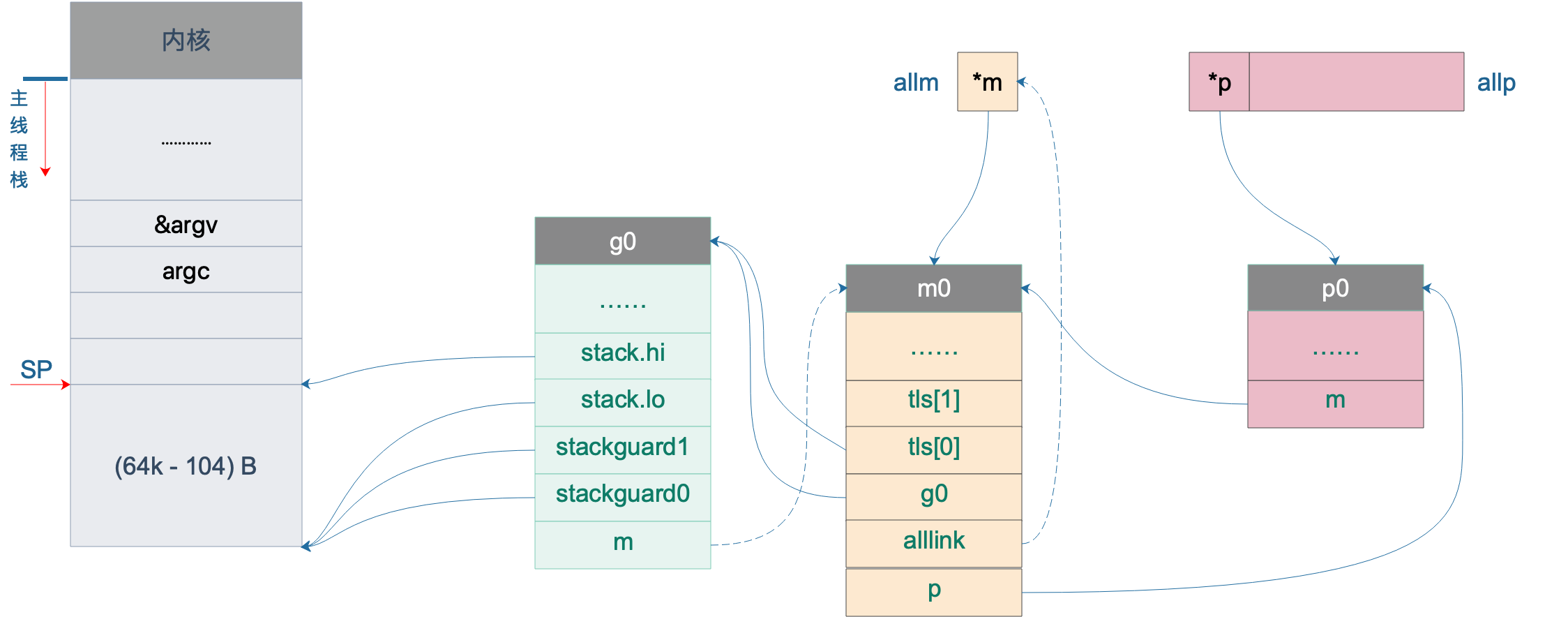

- 使用 make([]p, nprocs) 初始化全局变量 allp,即 allp = make([]p, nprocs)

- 循环创建并初始化 nprocs 个 p 结构体对象并依次保存在 allp 切片之中

- 把 m0 和 allp[0] 绑定在一起,即 m0.p = allp[0],allp[0].m = m0

- 把除了 allp[0] 之外的所有 p 放入到全局变量 sched 的 pidle 空闲队列之中

说明一下,最后一步,代码里是将所有空闲的 P 放入到调度器的全局空闲队列;对于非空闲的 P(本地队列里有 G 待执行),则是生成一个 P 链表,返回给 procresize 函数的调用者。

最后我们将 allp 和 allm 都添加到图上:

acquirep

用 acquirep(p) 绑定获取到的 p 和 m,主要的动作就是设置 p 的 m 字段,更改 p 的工作状态为 _Prunning,并且设置 m 的 p 字段。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

// Associate p and the current m.

//

// This function is allowed to have write barriers even if the caller

// isn't because it immediately acquires _p_.

//

//go:yeswritebarrierrec

func acquirep(_p_ *p) {

// Do the part that isn't allowed to have write barriers.

wirep(_p_)

// Have p; write barriers now allowed.

// Perform deferred mcache flush before this P can allocate

// from a potentially stale mcache.

_p_.mcache.prepareForSweep()

if trace.enabled {

traceProcStart()

}

}

|

先调用 wirep 函数真正地进行关联,之后,将 p0 的 mcache 资源赋给 m0。再来看 wirep:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

|

// wirep is the first step of acquirep, which actually associates the

// current M to _p_. This is broken out so we can disallow write

// barriers for this part, since we don't yet have a P.

//

//go:nowritebarrierrec

//go:nosplit

func wirep(_p_ *p) {

_g_ := getg()

if _g_.m.p != 0 {

throw("wirep: already in go")

}

if _p_.m != 0 || _p_.status != _Pidle {

id := int64(0)

if _p_.m != 0 {

id = _p_.m.ptr().id

}

print("wirep: p->m=", _p_.m, "(", id, ") p->status=", _p_.status, "\n")

throw("wirep: invalid p state")

}

_g_.m.p.set(_p_)

_p_.m.set(_g_.m)

_p_.status = _Prunning

}

|

可以看到就是一些字段相互设置,执行完成后:

1

2

|

g0.m.p = p0

p0.m = m0

|

并且,p0 的状态变成了 _Prunning。

runqempty

函数 runqempty 用来判断一个 P 是否是空闲,依据是 P 的本地 run queue 队列里有没有 runnable 的 G,如果没有,那 P 就是空闲的。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

// runqempty reports whether _p_ has no Gs on its local run queue.

// It never returns true spuriously.

// 如果 _p_ 的本地队列里没有待运行的 G,则返回 true

func runqempty(_p_ *p) bool {

// Defend against a race where 1) _p_ has G1 in runqnext but runqhead == runqtail,

// 2) runqput on _p_ kicks G1 to the runq, 3) runqget on _p_ empties runqnext.

// Simply observing that runqhead == runqtail and then observing that runqnext == nil

// does not mean the queue is empty.

// 这里涉及到一些数据竞争,并不是简单地判断 runqhead == runqtail 并且 runqnext == nil 就可以

for {

head := atomic.Load(&_p_.runqhead)

tail := atomic.Load(&_p_.runqtail)

runnext := atomic.Loaduintptr((*uintptr)(unsafe.Pointer(&_p_.runnext)))

if tail == atomic.Load(&_p_.runqtail) {

return head == tail && runnext == 0

}

}

}

|

并不是简单地判断 head == tail 并且 runnext == nil 为真,就可以说明 runq 是空的。因为涉及到一些数据竞争,例如在比较 head == tail 时为真,但此时 runnext 上其实有一个 G,之后再去比较 runnext == nil 的时候,这个 G 又通过 runqput跑到了 runq 里去了或者通过 runqget 拿走了,runnext 也为真,于是函数就判断这个 P 是空闲的,这就会形成误判。

因此 runqempty 函数先是通过原子操作取出了 head,tail,runnext,然后再次确认 tail 没有发生变化,最后再比较 head == tail 以及 runnext == nil,保证了在观察三者都是在“同时”观察到的,因此,返回的结果就是正确的。

说明一下,runnext 上有时会绑定一个 G,这个 G 是被当前 G 唤醒的,相比其他 G 有更高的执行优先级,因此把它单独拿出来。

pidleput

将P放入全局空闲 P 列表:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

// Put p to on _Pidle list.

// Sched must be locked.

// May run during STW, so write barriers are not allowed.

//go:nowritebarrierrec

// 将 p 放到 _Pidle 列表里

func pidleput(_p_ *p) {

if !runqempty(_p_) {

throw("pidleput: P has non-empty run queue")

}

_p_.link = sched.pidle

sched.pidle.set(_p_)

// 增加全局空闲 P 的数量

atomic.Xadd(&sched.npidle, 1) // TODO: fast atomic

}

|

构造链表的过程其实比较简单,先将 p.link 指向原来的 sched.pidle 所指向的 p,也就是原空闲链表的最后一个 P,最后,再更新 sched.pidle,使其指向当前 p,这样,新的链表就构造完成。

pidleget

1

2

3

4

5

6

7

8

9

10

11

12

13

|

// Try get a p from _Pidle list.

// Sched must be locked.

// May run during STW, so write barriers are not allowed.

//go:nowritebarrierrec

// 试图从 _Pidle 列表里获取 p

func pidleget() *p {

_p_ := sched.pidle.ptr()

if _p_ != nil {

sched.pidle = _p_.link

atomic.Xadd(&sched.npidle, -1) // TODO: fast atomic

}

return _p_

}

|

比较简单,获取链表最后一个,再更新 sched.pidle,使其指向前一个 P。

releasep

解除当前工作线程和当前 P 的绑定关系:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

// Disassociate p and the current m.

// 解除 p 与 m 的关联

func releasep() *p {

_g_ := getg()

if _g_.m.p == 0 {

throw("releasep: invalid arg")

}

_p_ := _g_.m.p.ptr()

if _p_.m.ptr() != _g_.m || _p_.status != _Prunning {

print("releasep: m=", _g_.m, " m->p=", _g_.m.p.ptr(), " p->m=", hex(_p_.m), " p->status=", _p_.status, "\n")

throw("releasep: invalid p state")

}

if trace.enabled {

traceProcStop(_g_.m.p.ptr())

}

_g_.m.p = 0

_p_.m = 0

_p_.status = _Pidle

return _p_

}

|

主要的工作就是将 p 的 m 字段清空,并将 p 的状态修改为 _Pidle。

handoffp

handoffp函数实现抢占p的功能.

当 p 的本地运行队列或全局运行队列里面有待运行的 goroutine,说明还有很多工作要做,调用 startm(p, false) 启动一个 m 来结合 p,继续工作。

当除了当前的 p 外,其他所有的 p 都在运行 goroutine,说明天下太平,每个人都有自己的事做,唯独自己没有。为了全局更快地完成工作,需要启动一个 m,且要使得 m 处于自旋状态,和 p 结合之后,尽快找到工作。

最后,如果实在没有工作要处理,就将 p 放入全局空闲队列里。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

|

// Hands off P from syscall or locked M.

// Always runs without a P, so write barriers are not allowed.

//go:nowritebarrierrec

func handoffp(_p_ *p) {

// handoffp must start an M in any situation where

// findrunnable would return a G to run on _p_.

// if it has local work, start it straight away

//如果P本地或全局有任务,直接唤醒某个M开始工作

if !runqempty(_p_) || sched.runqsize != 0 {

startm(_p_, false)

return

}

// if it has GC work, start it straight away

if gcBlackenEnabled != 0 && gcMarkWorkAvailable(_p_) {

startm(_p_, false)

return

}

// no local work, check that there are no spinning/idle M's,

// otherwise our help is not required

// 所有其它 p 都在运行 goroutine,说明系统比较忙,需要启动 m

if atomic.Load(&sched.nmspinning)+atomic.Load(&sched.npidle) == 0 && atomic.Cas(&sched.nmspinning, 0, 1) { // TODO: fast atomic

startm(_p_, true)

return

}

lock(&sched.lock)

if sched.gcwaiting != 0 {

_p_.status = _Pgcstop

sched.stopwait--

if sched.stopwait == 0 {

notewakeup(&sched.stopnote)

}

unlock(&sched.lock)

return

}

if _p_.runSafePointFn != 0 && atomic.Cas(&_p_.runSafePointFn, 1, 0) {

sched.safePointFn(_p_)

sched.safePointWait--

if sched.safePointWait == 0 {

notewakeup(&sched.safePointNote)

}

}

// 全局队列有工作

if sched.runqsize != 0 {

unlock(&sched.lock)

startm(_p_, false)

return

}

// If this is the last running P and nobody is polling network,

// need to wakeup another M to poll network.

if sched.npidle == uint32(gomaxprocs-1) && atomic.Load64(&sched.lastpoll) != 0 {

unlock(&sched.lock)

startm(_p_, false)

return

}

// 没有工作要处理,把 p 放入全局空闲队列

pidleput(_p_)

unlock(&sched.lock)

}

|

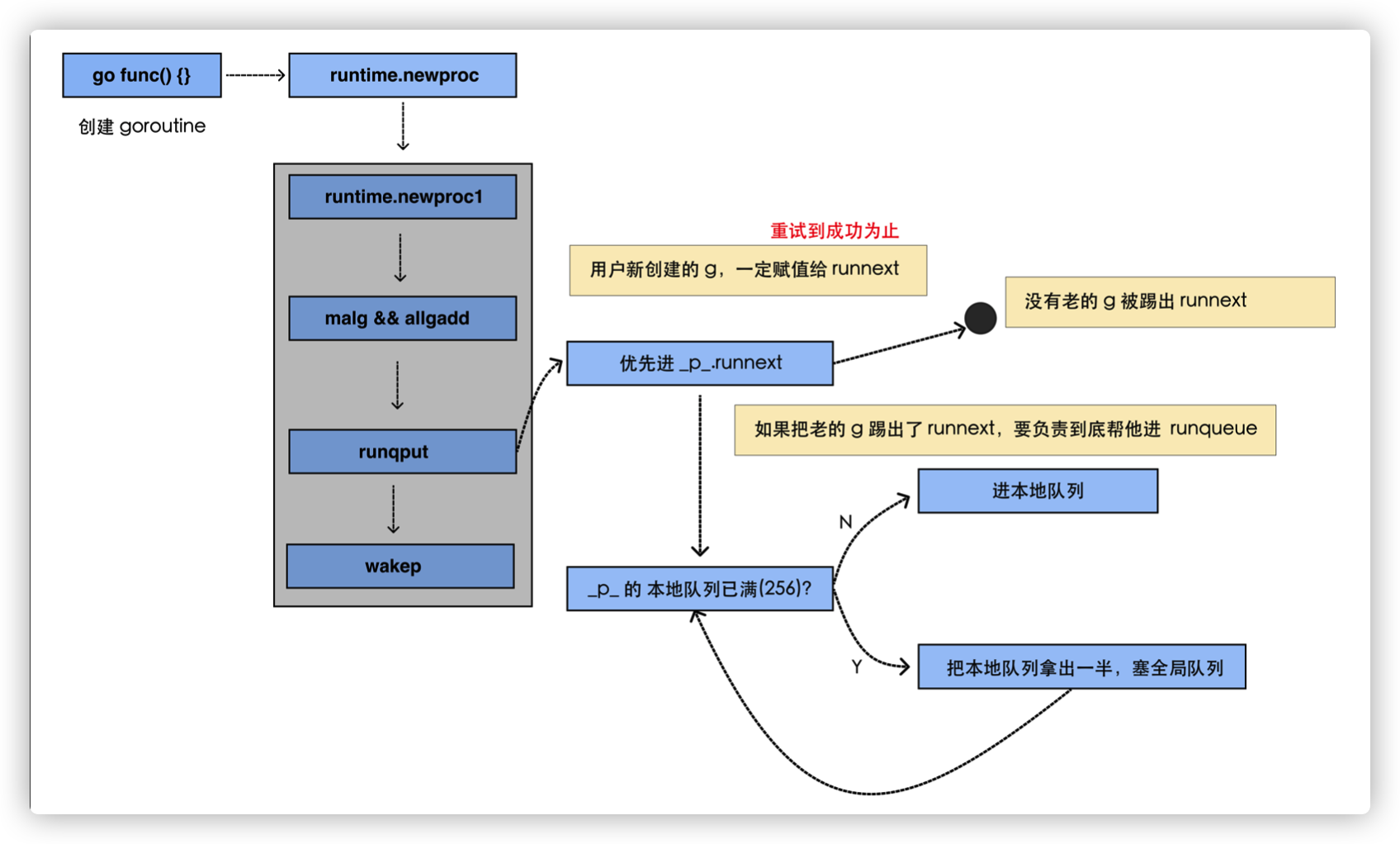

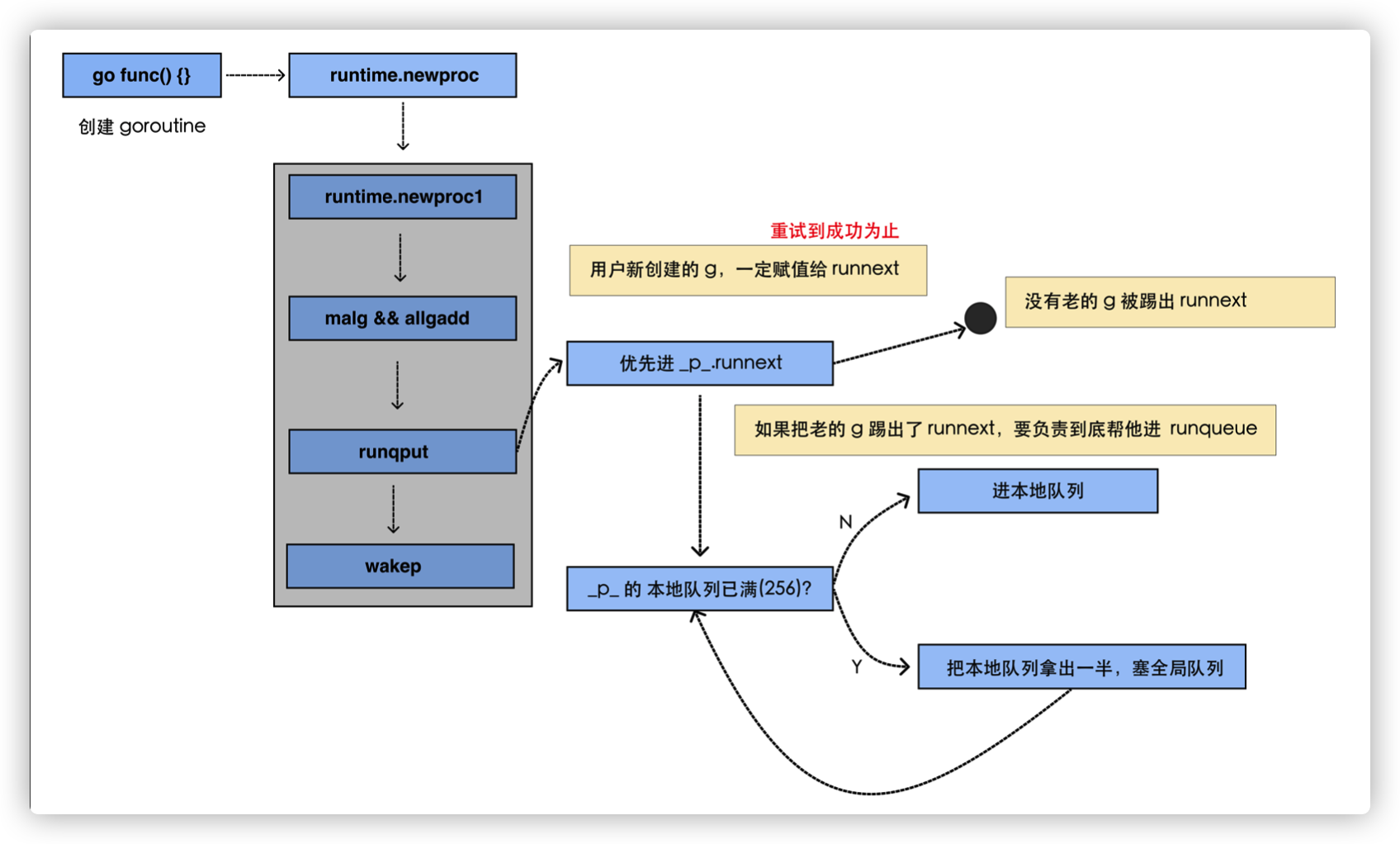

创建G

创建 G 的过程也是相对比较复杂的,我们来总结一下这个过程:

- 首先尝试从 P 本地 gfree 链表或全局 gfree 队列获取已经执行过的 g

- 初始化过程中程序无论是本地队列还是全局队列都不可能获取到 g,因此创建一个新的 g,并为其分配运行线程(执行栈),这时 g 处于 _Gidle 状态

- 创建完成后,g 被更改为 _Gdead 状态,并根据要执行函数的入口地址和参数,初始化执行栈的 SP 和参数的入栈位置,并将需要的参数拷贝一份存入执行栈中

- 根据 SP、参数,在 g.sched 中保存 SP 和 PC 指针来初始化 g 的运行现场

- 将调用方、要执行的函数的入口 PC 进行保存,并将 g 的状态更改为 _Grunnable

- 给 Goroutine 分配 id,并将其放入 P 本地队列的队头或全局队列(初始化阶段队列肯定不是满的,因此不可能放入全局队列)

- 检查空闲的 P,将其唤醒,准备执行 G,但我们目前处于初始化阶段,主 Goroutine 尚未开始执行,因此这里不会唤醒 P。

值得一提的是,newproc 是由 go:nosplit 修饰的函数, 因此这个函数在执行过程中不会发生扩张和抢占,这个函数中的每一行代码都是深思熟虑过、确保能够在有限的栈空间内 完成执行。

newproc

编译器会将所有的 go 关键字被转换成 runtime.newproc 函数,该函数会接收大小和表示函数的指针 funcval。在这个函数中我们还会获取 Goroutine 以及调用方的程序计数器,然后调用 runtime.newproc1 函数

newproc 函数需要两个参数:一个是新创建的 goroutine 需要执行的任务,也就是 fn,它代表一个函数 func;还有一个是 fn 的参数大小。

可能会感到奇怪,为什么要给 newproc 传一个表示 fn 的参数大小的参数呢?

我们知道,goroutine 和线程一样,都有自己的栈,不同的是 goroutine 的初始栈比较小,只有 2K,而且是可伸缩的,这也是创建 goroutine 的代价比创建线程代价小的原因。

换句话说,每个 goroutine 都有自己的栈空间,newproc 函数会新创建一个新的 goroutine 来执行 fn 函数,在新 goroutine 上执行指令,就要用新 goroutine 的栈。而执行函数需要参数,这个参数又是在老的 goroutine 上,所以需要将其拷贝到新 goroutine 的栈上。拷贝的起始位置就是栈顶,这好办,那拷贝多少数据呢?由 siz 来确定。

继续看代码,newproc 函数的第二个参数:

1

2

3

4

|

type funcval struct {

fn uintptr

// variable-size, fn-specific data here

}

|

有一个例子:

1

2

3

4

5

6

7

8

9

|

package main

func hello(msg string) {

println(msg)

}

func main() {

go hello("hello world")

}

|

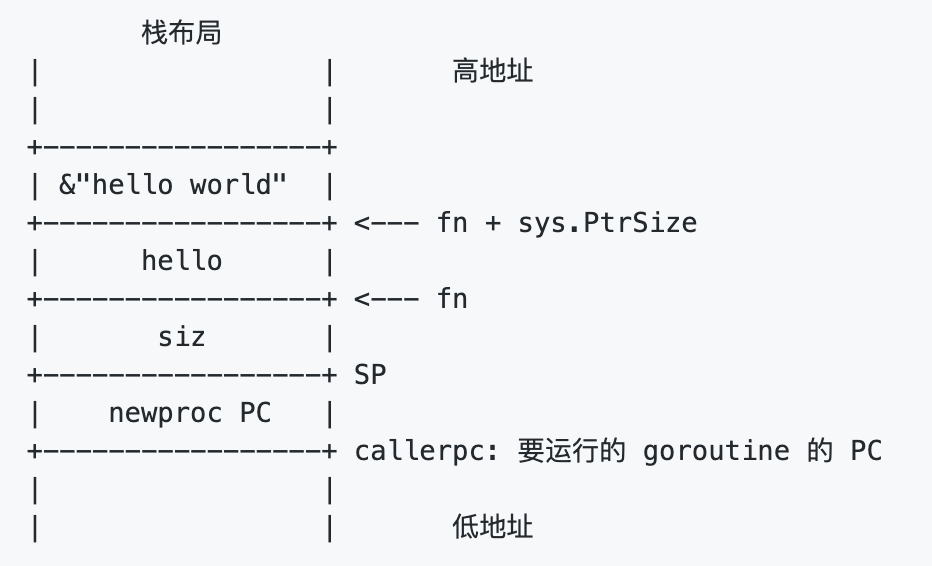

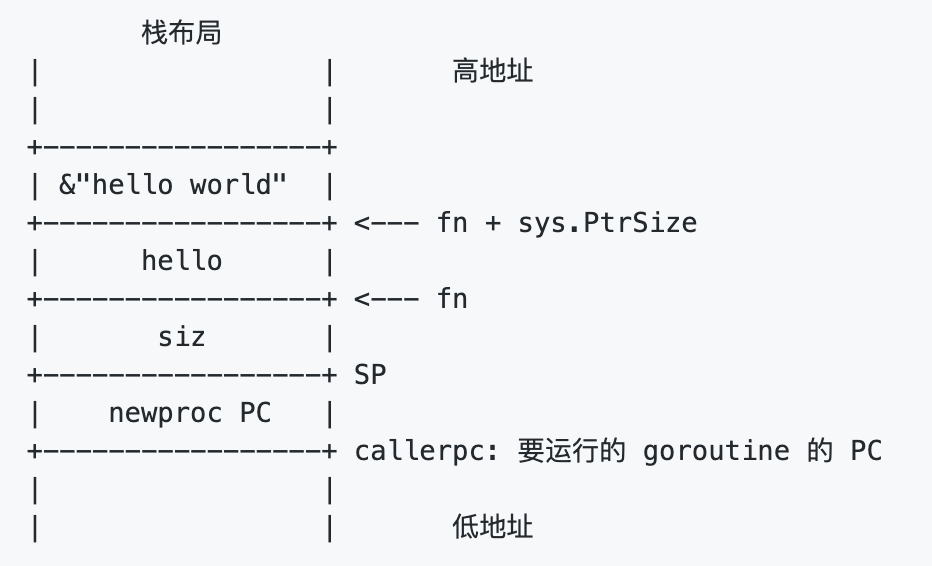

栈布局是这样的:

栈顶是 siz,再往上是函数的地址,再往上就是传给 hello 函数的参数,string 在这里是一个地址。因此前面代码里先 push 参数的地址,再 push 参数大小。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

|

// Create a new g running fn with siz bytes of arguments.

// Put it on the queue of g's waiting to run.

// The compiler turns a go statement into a call to this.

// Cannot split the stack because it assumes that the arguments

// are available sequentially after &fn; they would not be

// copied if a stack split occurred.

//go:nosplit

func newproc(siz int32, fn *funcval) {

//获取第一参数地址

//argp 跳过 fn,向上跳一个指针的长度,拿到 fn 参数的地址。

argp := add(unsafe.Pointer(&fn), sys.PtrSize)

gp := getg()

// 获取调用者的指令地址,也就是调用 newproc 时由 call 指令压栈的函数返回地址

//通过 getcallerpc 获取调用者的指令地址,也就是调用 newproc 时由 call 指令压栈的函数返回地址,也就是 runtime·rt0_go 函数里 CALL runtime·newproc(SB) 指令后面的 POPQ AX 这条指令的地址。

pc := getcallerpc()

// systemstack 的作用是切换到 g0 栈执行作为参数的函数

// 用 g0 系统栈创建 goroutine 对象

// 传递的参数包括 fn 函数入口地址,argp 参数起始地址,siz 参数长度,调用方 pc(goroutine)

//调用 systemstack 函数在 g0 栈执行 fn 函数。如果是初始化过程中,由 runtime·rt0_go 函数调用,本身是在 g0 栈执行,因此会直接执行 fn 函数。而如果是我们在程序中写的 go xxx 代码,在执行时,就会先切换到 g0 栈执行,然后再切回来。

systemstack(func() {

newproc1(fn, (*uint8)(argp), siz, gp, pc)

})

}

// Should be a built-in for unsafe.Pointer?

//go:nosplit

func add(p unsafe.Pointer, x uintptr) unsafe.Pointer {

return unsafe.Pointer(uintptr(p) + x)

}

// getg returns the pointer to the current g.

// The compiler rewrites calls to this function into instructions

// that fetch the g directly (from TLS or from the dedicated register).

func getg() *g

|

runtime.newproc1 会根据传入参数初始化一个 g 结构体,我们可以将该函数分成以下几个部分介绍它的实现:

- 获取或者创建新的 Goroutine 结构体;

- 将传入的参数移到 Goroutine 的栈上;

- 更新 Goroutine 调度相关的属性;

- 将 Goroutine 加入处理器的运行队列;

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

|

// mainStarted indicates that the main M has started.

var mainStarted bool

// Create a new g running fn with narg bytes of arguments starting

// at argp. callerpc is the address of the go statement that created

// this. The new g is put on the queue of g's waiting to run.

// 创建一个运行 fn 的新 g,具有 narg 字节大小的参数,从 argp 开始。

// callerps 是 go 语句的起始地址。新创建的 g 会被放入 g 的队列中等待运行。

func newproc1(fn *funcval, argp *uint8, narg int32, callergp *g, callerpc uintptr) {

/*

首先是 Goroutine 结构体的创建过程

*/

// 当前 goroutine 的指针

// 因为已经切换到 g0 栈,所以无论什么场景都是 _g_ = g0

// g0 是指当前工作线程的 g0

_g_ := getg()

if fn == nil {

_g_.m.throwing = -1 // do not dump full stacks

throw("go of nil func value")

}

// 禁止这时 g 的 m 被抢占因为它可以在一个局部变量中保存 p

_g_.m.locks++ // disable preemption because it can be holding p in a local var

//"参数+返回值"所需空间(对齐)

// 参数加返回值所需要的空间(经过内存对齐)

siz := narg

siz = (siz + 7) &^ 7

// We could allocate a larger initial stack if necessary.

// Not worth it: this is almost always an error.

// 4*sizeof(uintreg): extra space added below

// sizeof(uintreg): caller's LR (arm) or return address (x86, in gostartcall).

if siz >= _StackMin-4*sys.RegSize-sys.RegSize {

throw("newproc: function arguments too large for new goroutine")

}

//从当前P复用链表获取空闲的G对象

// 当前工作线程所绑定的 p

// 初始化时 _p_ = g0.m.p,也就是 _p_ = allp[0]

_p_ := _g_.m.p.ptr()

// 从 p 的本地缓冲里获取一个没有使用的 g

//初始化时为空,返回 nil

newg := gfget(_p_)

// 初始化阶段,gfget 是不可能找到 g 的

// 也可能运行中本来就已经耗尽了

if newg == nil {

// new 一个 g 结构体对象,然后从堆上为其分配栈,并设置 g 的 stack 成员和两个 stackgard 成员

// 创建一个拥有 _StackMin 大小的栈的 g

newg = malg(_StackMin)

// 初始化 g 的状态为 _Gdead

casgstatus(newg, _Gidle, _Gdead)

// 放入全局变量 allgs 切片中

// 将 Gdead 状态的 g 添加到 allg,这样 GC 不会扫描未初始化的栈

allgadd(newg) // publishes with a g->status of Gdead so GC scanner doesn't look at uninitialized stack.

}

/*

上述代码会先从处理器的 gFree 列表中查找空闲的 Goroutine,如果不存在空闲的 Goroutine,就会通过 runtime.malg 函数创建一个栈大小足够的新结构体。

*/

//测试 G stack

if newg.stack.hi == 0 {

throw("newproc1: newg missing stack")

}

//测试G status

if readgstatus(newg) != _Gdead {

throw("newproc1: new g is not Gdead")

}

/*

接下来,我们会调用 runtime.memmove 函数将 fn 函数的全部参数拷贝到栈上,argp 和 narg 分别是参数的内存空间和大小,我们在该方法中会直接将所有参数对应的内存空间整片的拷贝到栈上:

*/

//计算所需空间大小,并对齐

totalSize := 4*sys.RegSize + uintptr(siz) + sys.MinFrameSize // extra space in case of reads slightly beyond frame

totalSize += -totalSize & (sys.SpAlign - 1) // align to spAlign

//确定SP位置

sp := newg.stack.hi - totalSize

// 确定参数入栈位置

spArg := sp

if usesLR {

// caller's LR

*(*uintptr)(unsafe.Pointer(sp)) = 0

prepGoExitFrame(sp)

spArg += sys.MinFrameSize

}

// 处理参数,当有参数时,将参数拷贝到 Goroutine 的执行栈中

if narg > 0 {

// 从 argp 参数开始的位置,复制 narg 个字节到 spArg(参数拷贝)

memmove(unsafe.Pointer(spArg), unsafe.Pointer(argp), uintptr(narg))

// This is a stack-to-stack copy. If write barriers

// are enabled and the source stack is grey (the

// destination is always black), then perform a

// barrier copy. We do this *after* the memmove

// because the destination stack may have garbage on

// it.

// 栈到栈的拷贝。

// 如果启用了 write barrier 并且 源栈为灰色(目标始终为黑色),

// 则执行 barrier 拷贝。

// 因为目标栈上可能有垃圾,我们在 memmove 之后执行此操作。

if writeBarrier.needed && !_g_.m.curg.gcscandone {

f := findfunc(fn.fn)

stkmap := (*stackmap)(funcdata(f, _FUNCDATA_ArgsPointerMaps))

if stkmap.nbit > 0 {

// We're in the prologue, so it's always stack map index 0.

// 我们正位于序言部分,因此栈 map 索引总是 0

bv := stackmapdata(stkmap, 0)

bulkBarrierBitmap(spArg, spArg, uintptr(bv.n)*sys.PtrSize, 0, bv.bytedata)

}

}

}

/*

拷贝了栈上的参数之后,runtime.newproc1 会设置新的 Goroutine 结构体的参数,包括栈指针、程序计数器并更新其状态到 _Grunnable:

*/

//初始化用于保存执行现场的区域

// 把 newg.sched 结构体成员的所有成员设置为 0

memclrNoHeapPointers(unsafe.Pointer(&newg.sched), unsafe.Sizeof(newg.sched))

// 设置 newg 的 sched 成员,调度器需要依靠这些字段才能把 goroutine 调度到 CPU 上运行

//设置 sched 的 sp 字段,当 goroutine 被调度到 m 上运行时,需要通过 sp 字段来指示栈顶的位置,这里设置的就是新栈的栈顶位置。

newg.sched.sp = sp

newg.stktopsp = sp

//此处保存的是goexit地址

// newg.sched.pc 表示当 newg 被调度起来运行时从这个地址开始执行指令

//设置 pc 字段为函数 goexit 的地址加 1,也说是 goexit 函数的第二条指令,goexit 函数是 goroutine 退出后的一些清理工作。

newg.sched.pc = funcPC(goexit) + sys.PCQuantum // +PCQuantum so that previous instruction is in same function

//设置 g 字段为 newg 的地址。

newg.sched.g = guintptr(unsafe.Pointer(newg))

//此处的调用是关键,调整sched成员和newg的栈

gostartcallfn(&newg.sched, fn)

// 初始化 g 的基本状态

newg.gopc = callerpc

newg.ancestors = saveAncestors(callergp) // 调试相关,追踪调用方

// 设置 newg 的 startpc 为 fn.fn,该成员主要用于函数调用栈的 traceback 和栈收缩

// newg 真正从哪里开始执行并不依赖于这个成员,而是 sched.pc

newg.startpc = fn.fn

if _g_.m.curg != nil {

newg.labels = _g_.m.curg.labels

}

if isSystemGoroutine(newg, false) {

atomic.Xadd(&sched.ngsys, +1)

}

newg.gcscanvalid = false

// 设置 g 的状态为 _Grunnable,可以运行了

casgstatus(newg, _Gdead, _Grunnable)

//设置唯一id

if _p_.goidcache == _p_.goidcacheend {

// Sched.goidgen is the last allocated id,

// this batch must be [sched.goidgen+1, sched.goidgen+GoidCacheBatch].

// At startup sched.goidgen=0, so main goroutine receives goid=1.

//Sched.goidgen是一个全局计数器

//每次取回一段有效区间,然后在该区间分配,避免频繁地去全局操作.

// Sched.goidgen 为最后一个分配的 id,相当于一个全局计数器

// 这一批必须为 [sched.goidgen+1, sched.goidgen+GoidCacheBatch].

// 启动时 sched.goidgen=0, 因此主 Goroutine 的 goid 为 1

_p_.goidcache = atomic.Xadd64(&sched.goidgen, _GoidCacheBatch)

_p_.goidcache -= _GoidCacheBatch - 1

_p_.goidcacheend = _p_.goidcache + _GoidCacheBatch

}

// 设置 goid

newg.goid = int64(_p_.goidcache)

_p_.goidcache++

if raceenabled {

newg.racectx = racegostart(callerpc)

}

if trace.enabled {

traceGoCreate(newg, newg.startpc)

}

/*

在最后,该函数会将初始化好的 Goroutine 加入处理器的运行队列并在满足条件时调用 runtime.wakep 函数唤醒新的处理执行 Goroutine:

*/

// 将这里新创建的 g 放入 p 的本地队列或直接放入全局队列

// true 表示放入执行队列的下一个,false 表示放入队尾

runqput(_p_, newg, true)

//如果有其他空闲P,则尝试唤醒某个M出来执行任务

//如果有M处于自旋等待P或G状态,放弃

//如果当前创建的是main goroutine(runtime.main),那么还没有其他任务需要执行,放弃

if atomic.Load(&sched.npidle) != 0 && atomic.Load(&sched.nmspinning) == 0 && mainStarted {

wakep()

}

_g_.m.locks--

if _g_.m.locks == 0 && _g_.preempt { // restore the preemption request in case we've cleared it in newstack

_g_.stackguard0 = stackPreempt

}

}

|

newproc1通过两种不同的方式获取新的 runtime.g 结构体:

- 调用runtime.gfget 从 Goroutine 所在处理器的 gFree 列表或者调度器的 sched.gFree 列表中获取 runtime.g 结构体;

- 调用 runtime.malg 函数生成一个新的 runtime.g 函数并将当前结构体追加到全局的 Goroutine 列表 allgs 中。

gostartcallfn

在newproc1创建G任务时,我们在初始化G.sched时,pc保存的是goexit而非fn.关键秘密就是随后调用的gostartcallfn函数.

运行时创建 Goroutine 时会通过下面的代码设置调度相关的信息,前两行代码会分别将程序计数器和 Goroutine 设置成 runtime.goexit 函数和新创建的 Goroutine:

1

2

3

4

5

|

...

newg.sched.pc = funcPC(goexit) + sys.PCQuantum

newg.sched.g = guintptr(unsafe.Pointer(newg))

gostartcallfn(&newg.sched, fn)

...

|

但是这里的调度信息 sched 不是初始化后的 Goroutine 的最终结果,经过 runtime.gostartcallfn 和 runtime.gostartcall 两个函数的处理:

1

2

3

4

5

6

7

8

9

10

11

12

|

// adjust Gobuf as if it executed a call to fn

// and then did an immediate gosave.

func gostartcallfn(gobuf *gobuf, fv *funcval) {

var fn unsafe.Pointer

if fv != nil {

// fn: gorotine 的入口地址,初始化时对应的是 runtime.main

fn = unsafe.Pointer(fv.fn)

} else {

fn = unsafe.Pointer(funcPC(nilfunc))

}

gostartcall(gobuf, fn, unsafe.Pointer(fv))

}

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

// adjust Gobuf as if it executed a call to fn with context ctxt

// and then did an immediate gosave.

func gostartcall(buf *gobuf, fn, ctxt unsafe.Pointer) {

// newg 的栈顶,目前 newg 栈上只有 fn 函数的参数,sp 指向的是 fn 的第一参数

sp := buf.sp

if sys.RegSize > sys.PtrSize {

sp -= sys.PtrSize

*(*uintptr)(unsafe.Pointer(sp)) = 0

}

// 为返回地址预留空间

sp -= sys.PtrSize

// 这里填的是 newproc1 函数里设置的 goexit 函数的第二条指令

// 伪装 fn 是被 goexit 函数调用的,使得 fn 执行完后返回到 goexit 继续执行,从而完成清理工作

*(*uintptr)(unsafe.Pointer(sp)) = buf.pc

// 重新设置 buf.sp

//然后再次设置sp和pc,此时pc才是G任务函数

buf.sp = sp

// 当 goroutine 被调度起来执行时,会从这里的 pc 值开始执行,初始化时就是 runtime.main

buf.pc = uintptr(fn)

buf.ctxt = ctxt

}

|

函数 gostartcallfn 只是拆解出了包含在 funcval 结构体里的函数指针,转过头就调用 gostartcall。将 sp 减小了一个指针的位置,这是给返回地址留空间。果然接着就把 buf.pc 填入了栈顶的位置:

1

|

*(*uintptr)(unsafe.Pointer(sp)) = buf.pc

|

原来 buf.pc 只是做了一个搬运工。重新设置 buf.sp 为送减掉一个指针位置之后的值,设置 buf.pc 为 fn,指向要执行的函数,这里就是指的 runtime.main 函数。之后,当调度器“光顾”此 goroutine 时,取出 buf.sp 和 buf.pc,恢复 CPU 相应的寄存器,就可以构造出 goroutine 的运行环境。

newg 栈顶位置的内容是一个跳转地址,指向 runtime.goexit 的第二条指令,当 goroutine 退出时,这条地址会载入 CPU 的 PC 寄存器,跳转到这里执行“扫尾”工作。

gfget

首先,G对象默认会复用.除P本地的复用链表外,还有全局链表在多个P之间共享.

runtime.gfget 中包含两部分逻辑,它会根据处理器中 gFree 列表中 Goroutine 的数量做出不同的决策:

- 当处理器的 Goroutine 列表为空时,会将调度器持有的空闲 Goroutine 转移到当前处理器上,直到 gFree 列表中的 Goroutine 数量达到 32;

- 当处理器的 Goroutine 数量充足时,会从列表头部返回一个新的 Goroutine;

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

|

// Get from gfree list.

// If local list is empty, grab a batch from global list.

func gfget(_p_ *p) *g {

retry:

//如果本地P的G队列为空且全局G队列不空,尝试从全局链表中转移一批到G本地

if _p_.gFree.empty() && (!sched.gFree.stack.empty() || !sched.gFree.noStack.empty()) {

lock(&sched.gFree.lock)

// Move a batch of free Gs to the P.

//最多转移32个

for _p_.gFree.n < 32 {

// Prefer Gs with stacks.

gp := sched.gFree.stack.pop()

if gp == nil {

gp = sched.gFree.noStack.pop()

if gp == nil {

break

}

}

sched.gFree.n--

_p_.gFree.push(gp)

_p_.gFree.n++

}

unlock(&sched.gFree.lock)

//再试

goto retry

}

//从P本地G队列提取复用对象

gp := _p_.gFree.pop()

if gp == nil {

return nil

}

_p_.gFree.n--

if gp.stack.lo == 0 {

//分配新栈

// Stack was deallocated in gfput. Allocate a new one.

systemstack(func() {

gp.stack = stackalloc(_FixedStack)

})

gp.stackguard0 = gp.stack.lo + _StackGuard

} else {

if raceenabled {

racemalloc(unsafe.Pointer(gp.stack.lo), gp.stack.hi-gp.stack.lo)

}

if msanenabled {

msanmalloc(unsafe.Pointer(gp.stack.lo), gp.stack.hi-gp.stack.lo)

}

}

return gp

}

|

当goroutine执行完毕,调度器相关函数会将G对象放回P复用G链表

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

|

// Put on gfree list.

// If local list is too long, transfer a batch to the global list.

func gfput(_p_ *p, gp *g) {

if readgstatus(gp) != _Gdead {

throw("gfput: bad status (not Gdead)")

}

stksize := gp.stack.hi - gp.stack.lo

//如果栈发生过扩张,则释放

if stksize != _FixedStack {

// non-standard stack size - free it.

stackfree(gp.stack)

gp.stack.lo = 0

gp.stack.hi = 0

gp.stackguard0 = 0

}

//放回P本地复用链表

_p_.gFree.push(gp)

_p_.gFree.n++

//如果本地复用对象过多,则转移一批到全局链表

if _p_.gFree.n >= 64 {

lock(&sched.gFree.lock)

//本地保留32个

for _p_.gFree.n >= 32 {

_p_.gFree.n--

gp = _p_.gFree.pop()

if gp.stack.lo == 0 {

sched.gFree.noStack.push(gp)

} else {

sched.gFree.stack.push(gp)

}

sched.gFree.n++

}

unlock(&sched.gFree.lock)

}

}

|